游戏加载卡在99%,AI模型训练到一半内存爆满,这些让人抓狂的瞬间背后,都是同一个看不见的敌人在作祟——内存墙。

你是否还记得,当你正全神贯注地在虚拟世界里激战,屏幕突然卡顿,或是那个价值百万的AI模型训练到一半,因为内存不足而被迫中断的绝望感?

这些看似不相关的问题,其实都指向了同一个技术瓶颈——我们设备里的DRAM(动态随机存取存储器)已经跟不上处理器的脚步了。但这一切即将发生翻天覆地的变化,一场围绕DRAM技术迭代的深刻革命正在芯片实验室里悄然进行。

咱们平时用电脑、玩手机,可能很少想到里面那些比指甲盖还小的内存芯片。这些DRAM芯片的基本结构其实几十年没大变——一个晶体管加一个电容,专业点叫1T1C结构-7。

简单来说,电容存电荷(代表1或0),晶体管控制读写。但这个电容会漏电,所以DRAM得定期刷新,64毫秒就得来一次-7。

过去几十年,DRAM产业一直沿着摩尔定律狂奔,把晶体管越做越小。你肯定听说过芯片制程从90纳米、65纳米一路降到现在的10纳米级别。

但实际上,到了20纳米以下,这条路越来越难走-7。现在的DRAM厂商都不直接提具体尺寸了,改用1x、1y、1z、1a、1b这种代号-2。

为啥这么难?电容这东西太占地方了,要维持足够的电容值,随着制程缩小,电容就得做得又细又高,像根极细的针。业内把这种比例叫做“宽高比”,现在已经做到1:50的极限,再高制造工艺就吃不消了-7。

电晶体那边也不省心,漏电流问题越来越严重。晶体管越小,控制电流的能力越弱,电容里存的电荷漏得越快-7。

内存芯片的存储单元尺寸已经从几十年前的相对宽敞,缩小到现在的大约0.0137平方微米,也就是13700平方纳米-5。

这种微缩困境导致传统2D DRAM快要撞上物理墙了,而这正是DRAM技术迭代必须突破的首要障碍。

当平面扩展遇到天花板,工程师们学会了往高处发展——就像城市里地价太贵就盖摩天大楼一样。3D DRAM就是这个思路:把存储单元一层层堆起来。

2025年IEEE VLSI研讨会上,SK海力士透露了未来三十年的研发路线图,重点就是把4F² VG平台和3D DRAM技术引入10纳米以下制程-1。这个4F² VG技术把传统平面栅极改成垂直排列,能减少每个存储单元占用的芯片面积-1。

业界对3D DRAM的探索已有多条路径。NEO半导体推出的3D X-DRAM,借鉴了3D NAND闪存的经验,目标是实现512层堆叠,将单芯片容量提升到64Gb至512Gb-3。

想象一下,这相当于把一层楼的图书馆改装成一座高楼大厦——同样大小的芯片,能存更多的数据,还能更快地调出所需内容-3。

铠侠公司则走了一条不同的路线,他们研发了高度可堆叠的氧化物半导体沟道晶体管,已经成功验证了8层堆叠结构的可行性-8。

这些氧化物半导体有极低的关断电流特性,能把DRAM的刷新功耗显著降下来-8。对于AI服务器这种耗电大户,这可是个大利好。

更有意思的是3D DRAM内部的结构创新。NEO半导体开发了1T1C(单晶体管+电容器)和3T0C(三晶体管+零电容器)两种变体-3。

1T1C结构使用高K电介质作为电容器,数据保留时间能超过450秒,远超传统DRAM的毫秒级水准-3。这意味着刷新频率可以大幅降低,直接省电。

而3T0C结构则完全抛弃了电容器,基于电流感应机制实现数据读写,特别适合AI推理和存内计算这些需要高速、低延迟的场景-3。

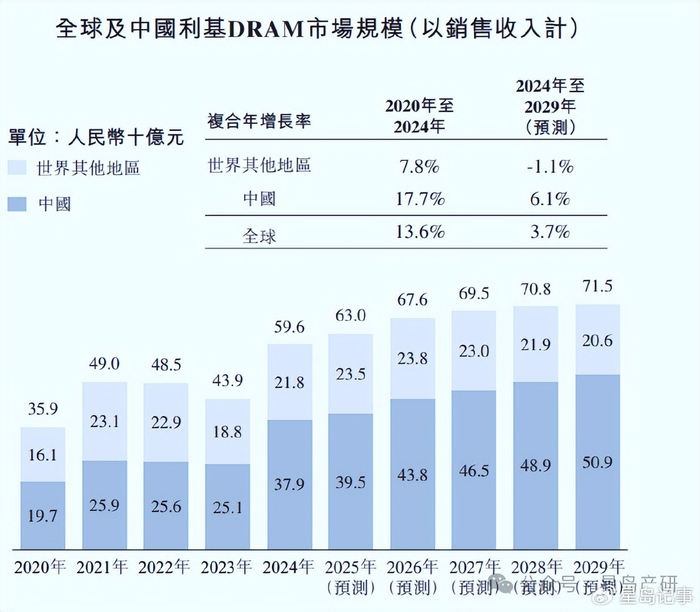

如果说3D DRAM是未来方向,那么HBM(高带宽内存)就是眼下最炙手可热的技术。2026年初的数据显示,HBM已经占到整个DRAM市场营收的23%-4。

AI“超级周期”把HBM从高端显卡的小众配件,推向了存储产业的中心舞台-4。

HBM为啥这么重要?简单说,AI处理器越来越快,但传统内存喂数据的速度跟不上,处理器就得“饿着肚子”等数据,这就是所谓的“内存墙”-4。

HBM通过3D堆叠和硅通孔技术,把带宽做到了极致。而即将在2026年2月量产的HBM4,更是把这个概念推向了新高度-9。

HBM4有多强?它把接口宽度从1024位直接翻倍到2048位,单堆栈带宽超过2TB/s,差不多是早期HBM3e系统的三倍-4。

三星和SK海力士已经控制着全球90%的HBM生产-9,现在这两家巨头都计划在2026年2月开始大规模生产HBM4-9。

HBM4还有一个革命性设计——逻辑基础芯片。传统内存堆栈的底层也用标准DRAM工艺制造,但HBM4改用5纳米和3纳米逻辑工艺制造这个底层-4。

这样做的好处是,可以把内存控制器甚至特定的AI加速逻辑直接放进内存堆栈里。数据跑的距离短了,功耗效率能提升40%-4。

对需要处理海量参数的AI大模型来说,这种带宽和能效提升是突破性的。英伟达的下一代Rubin架构,每颗芯片就要用8到12堆栈HBM4-4。

DRAM技术迭代的下一站是个性化定制。台厂华邦电的CUBE产品具备高带宽、低功耗、散热优化与可定制化特点,第一波就瞄准了海外穿戴式装置与轻量AI眼镜-6。

南亚科的定制化DRAM,则是把高密度、3D IC和高频宽架构整合到客户逻辑芯片里-6。

材料创新也在同步进行。铠侠使用的氧化物半导体(如氧化铟镓锌),提供了比传统单晶硅更优的电气性能和制造一致性-3-8。

这种材料关断电流极低,有助于大幅降低DRAM的刷新功耗-8。

SK海力士在2025年IEEE VLSI研讨会上公布的三十年路线图,揭示了行业的长远规划-10。他们计划在结构、材料和组件三个维度同时创新,将4F² VG平台和3D DRAM技术应用到10纳米级及以下制程-10。

虽然业内有人担心3D堆叠层数增加会导致成本上升,但SK海力士首席技术官车善勇认为,持续的技术创新可以解决这个问题-10。

更长远来看,HBM4之后的路线图也在规划中。从2026年起,HBM4/4e将逐步采用晶圆对晶圆键合技术,到2028年,HBM5将成为主流-6。

这些技术进步不仅会让数据中心和AI服务器受益,最终也会惠及普通消费者。

未来,你的笔记本可能轻松运行现在需要高端显卡才能带的游戏,手机甚至可能配备512GB内存-3。AI应用会更加普及,响应速度会更快,而所有这些,都源于今天发生在DRAM芯片内部的技术革命。

游戏卡顿的最后一秒被流畅画面取代,AI训练不再因内存不足而中断。三星和SK海力士工厂里,为AI巨头定制的HBM4芯片正从生产线涌向全球数据中心-9。

铠侠实验室中,氧化物半导体堆叠的3D DRAM原型静静闪烁着信号灯-8。这些技术突破将沿着半导体供应链传递,最终抵达每一台智能设备。

当手机突然拥有远超今天的运行内存,当自动驾驶系统能瞬时处理海量环境数据,人们可能不会想到,这些体验升级源于多年前开始的DRAM技术迭代。存储芯片内部的结构革新,正悄然重塑人与机器交互的每一瞬间。

网友“科技探路者”问: 看了文章很受启发,但有个实际问题——这些高大上的3D DRAM和HBM4技术,什么时候能让我们普通消费者实实在在地感受到变化?具体会在哪些日常设备上体现出来?

答:这个问题问得很实在!高端技术从实验室走到我们手中确实需要时间,但这次DRAM技术迭代的影响会比想象中来得更快。

首先,最直接的感受会是明年开始的旗舰手机和笔记本电脑。2026年下半年,搭载HBM4内存的AI PC将开始上市。这些电脑能本地运行更复杂的AI模型,比如实时视频编辑、高质量图像生成,而不需要联网依赖云端服务。

游戏体验会有明显提升。2027年左右,游戏主机和高端显卡将采用基于3D DRAM技术的存储方案。游戏加载时间会大幅缩短,甚至可能实现“无感加载”,开放世界游戏中的卡顿和画面弹出问题将得到显著改善。

普通人最能感受到的可能是手机续航的提升。采用氧化物半导体等新材料的DRAM芯片,能将内存刷新功耗降低多达50%-8。这意味着同样电池容量的手机,待机时间会更长,这对于经常外出的人来说是个实实在在的好处。

另外,智能家居和汽车也会受益。更高效、容量更大的DRAM将使智能家居设备能处理更复杂的本地指令,而不总是需要云端响应。自动驾驶系统能同时处理更多传感器数据,做出更安全的决策。

价格方面,新技术初期会集中在高端设备,但随着产量增加,大约2-3年就会普及到中端产品。就像5G技术一样,最初只有旗舰机搭载,现在千元机也普及了。

网友“芯片爱好者”问: 文章中提到了HBM4带宽超过2TB/s,这个数字听起来很惊人,但能不能用更直观的方式解释一下,这么高的带宽对AI发展到底有多重要?另外,为什么三星和SK海力士能垄断90%的HBM市场?

答:好问题!2TB/s的带宽确实抽象,咱们做个对比就明白了。目前主流DDR5内存的带宽大约是50GB/s,HBM4的带宽是它的40倍以上。如果说DDR5是双向四车道高速公路,HBM4就是拥有80条车道的超级公路。

对AI发展而言,这种带宽突破至关重要。现在的AI大模型有上万亿个参数,训练时需要把这些参数不停地在处理器和内存之间搬运。如果内存带宽不够,再强的处理器也得“饿着肚子”等数据,这就是所谓的“内存墙”-4。

HBM4的高带宽意味着AI模型训练时间可以从几周缩短到几天,推理速度也能大幅提升。这对自动驾驶、医疗诊断等实时AI应用尤其关键——毫秒级的延迟减少可能就意味着事故的避免或生命的挽救。

为什么三星和SK海力士能垄断90%的HBM市场?这背后有几个原因:

一是先发优势和技术积累。韩国企业在3D堆叠和TSV(硅通孔)技术上有超过十年的研发经验,这些是制造HBM的核心技术。SK海力士早在2013年就推出了第一代HBM-9。

二是巨大的资本投入。SK海力士计划将其龙仁半导体集群的投资从128万亿韩元增加到600万亿韩元(约410亿美元)-9。这种规模的投资是大多数竞争者难以匹敌的。

三是与关键客户的深度绑定。三星和SK海力士与英伟达、台积电形成了紧密的合作关系。SK海力士通过“One-Team”联盟将逻辑基础芯片外包给台积电,确保与英伟达GPU的完美兼容-9。

四是制造工艺的复杂性。HBM需要将多个DRAM芯片垂直堆叠并用硅通孔连接,制造难度远高于传统内存。良率提升需要长时间的生产经验积累,新进入者很难在短期内达到经济规模。

网友“未来观察家”问: 文章提到DRAM技术未来三十年的路线图,很好奇除了堆叠层数增加,DRAM技术还会有哪些根本性的变革?会不会有一天DRAM被全新的存储技术取代?

答:这个问题很有前瞻性!未来三十年的DRAM技术迭代确实不仅限于“堆得更高”,而是有多维度的根本性变革。

首先是架构上的融合创新。未来的DRAM可能会与计算单元更紧密地结合,出现“存算一体”架构。就像HBM4中已经开始的逻辑基础芯片-4,未来可能有更多处理功能直接集成在内存内部。这种架构特别适合AI推理等特定场景,能大幅减少数据搬运,提升能效。

其次是材料的全面升级。除了文章中提到的氧化物半导体,研究人员还在探索铁电材料、相变材料等全新的存储介质。铠侠已经展示了使用氧化铟镓锌作为沟道材料的晶体管,它具有极低的关断电流-8。未来可能出现完全基于新原理的非易失性DRAM,既能快速读写,又能在断电时保持数据。

第三是三维结构的极致优化。现在的3D堆叠主要是垂直方向,未来可能会出现更复杂的立体结构,如交叉堆叠、蜂窝状排列等,最大化利用芯片空间。NEO半导体设想的512层堆叠只是起点-3,随着制造技术进步,千层堆叠也可能成为现实。

至于DRAM是否会被取代——短期内不会,但长期看会有融合与演进。每种存储技术都有其最适合的应用场景:SRAM速度最快但密度低,NAND密度高但速度慢,DRAM正好在中间。未来可能出现的是异构集成,将不同存储技术集成在同一封装内,由系统智能分配数据。

一些革命性技术如存内计算正在实验室中取得进展,它能在内存中直接进行简单计算,特别适合AI的矩阵运算。但完全取代传统计算架构还需要克服许多挑战。

可以肯定的是,未来三十年的存储技术将更加多样化、专业化。DRAM会继续演进,也可能衍生出新的变种,但“快速、易失、中等密度”这一细分市场,DRAM及其衍生技术仍将扮演核心角色。这场DRAM技术迭代不仅是技术的升级,更是计算范式的转变。