哎呀,说到电脑内存,大伙儿脑子里蹦出来的多半是“ DDR4 3200MHz ”或者“ 16GB ”这些个参数吧?但您有没有琢磨过,内存条和CPU这两兄弟,到底是咋“说上话”的?这背后的功臣,就是那个不常被提起但至关重要的DRAM接口。它就像城市里一条不断被拓宽、升级的主干道,从最初的羊肠小道发展到如今的立体高速,直接决定了数据这趟“车”能跑多快、拉多少货。今儿咱就唠唠这条“路”的变迁史,保准比你看那些生硬的参数表有意思多了!

要想弄懂接口为啥重要,咱得先瞧瞧内存的“芯”脏是咋跳动的。其实啊,每一颗DRAM存储芯片的核心,都是数以亿计的“1T1C”小单元,说白了就是一个晶体管(Transistor)配一个电容(Capacitor)-1。数据就靠电容里头有没有电荷来记着,有电是“1”,没电就是“0”-1。这些小单元整齐排成巨大的方格阵列(行和列),要存取数据时,CPU得先告诉内存“我要第几行第几列”,过程就像在地图上先找纵坐标再找横坐标-1。

最早的“对话”方式可笨拙了。CPU每次要数据,都得把行地址和列地址分开、挨个儿告诉内存,效率低得急死人-5。后来工程师们灵机一动:既然程序常常连续访问一片地方的数据(这叫“空间局部性”),那要是访问同一行,是不是可以只报列地址就行了?-5。这想法催生了FPM DRAM和EDO DRAM,效率蹭蹭就上去了-5。这就好比送快递,第一次得找清楚楼栋门牌,后面同楼的包裹,只说房间号就能送到了。

随着CPU这位“大哥”跑得越来越快,它对内存带宽的需求就像无底洞。最初的解决方案简单粗暴:提高内存芯片的工作频率。但这很快遇到了天花板——频率太高,电气信号在电路板上传输时就容易失真、反射,变得“模糊不清”-6。

这可咋整?工程师们祭出了两大法宝来优化这条DRAM接口。

第一招,叫“预取(Prefetch)”。你可以把它理解成“批发变零售”的物流优化。DDR1时代是“2n预取”,意思是内存芯片内部一次性准备2倍的数据,然后在接口上分两次高速传给CPU-6。到了DDR4变成“8n预取”,DDR5更是达到了“16n预取”-6。相当于仓库一次打包好16件货,让传送带以超高效率分批送出,大大提升了接口数据吞吐的效率-6。

第二招,更偏重“修路”本身,即不断提升信号完整性。 这就是一场从DDR1到DDR5的漫长“精修”之旅-6:

DDR1 引入了数据选通信号(DQS)和末端电压匹配(终结电阻),让信号质量好了不少-6。

DDR2 搞出了“差分DQS信号对”和片内终结(ODT),进一步对抗干扰-6。

DDR3/DDR4 则玩起了更精细的活,比如为数据和命令使用不同的参考电压,并把电压校准调得更准-6。

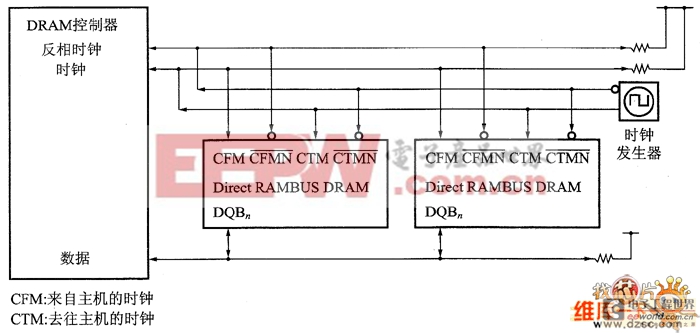

当速度冲到每秒几千兆次传输(GT/s)时,主板上的电路负载和信号衰减成了新“路障”。这时,单纯的“修路”不够用了,得请专业的“信号交警”上岗。这就是内存接口芯片,主要包括寄存时钟驱动器(RCD)和数据缓冲器(DB)-4。

它们的作用至关重要。比如在服务器常用的RDIMM内存条上,RCD芯片负责重整和驱动从CPU来的命令、地址和时钟信号,确保指令能清晰、准确地传达给内存条上的每一颗DRAM芯片-4-7。这就像在繁忙的高速路口设立了一个信号放大和中继站,保证远处也能收到清晰的指令。而DB芯片则专门缓冲数据信号,在更高级的LRDIMM内存条上使用,能进一步减轻CPU的负载-4。

为了让AI数据中心这类“超级都市”的数据流通更顺畅,更复杂的“立交桥系统”也被设计出来,比如MRDIMM(多路复用列DIMM)-7。它能让内存条上的两列存储单元同时工作,把通往CPU的数据通道拓宽了近一倍,根据瑞萨电子的数据,这能将内存带宽提升6%到33%-7。你看,优化DRAM接口,已经从最初的“铺路”演变为设计精妙的“交通枢纽系统”了。

未来的路在何方?方向已经很清晰了。

一是继续“拓宽路面”。像Tachyum公司开源的TDIMM技术,就直接把内存通向处理器的数据位宽从64位提升到了128位-9。这相当于直接把双向四车道扩成了八车道,单条内存带宽据称可达惊人的281GB/s-9。

二是发展“专用高速城际快线”。这就是HBM(高带宽内存),它通过3D堆叠和硅中介层,让内存和处理器(如GPU)紧紧挨着,用极短的、海量的并行“微通道”互联,专为AI计算这种对带宽饥渴的应用服务-3。当然,这条路造价不菲,是典型的“高端定制”。

三是面向大众的“主干道”持续升级。根据SK海力士的路线图,我们熟悉的DDR标准将继续演进,DDR6内存预计在2029-2031年间到来-10。同时,更省电的LPDDR6也会同步发展,服务于从手机到边缘计算的各种设备-10。

说到底,DRAM接口技术的发展史,就是一部与物理限制斗智斗勇、不断为数据流通“疏堵保畅”的历史。它或许不如CPU和显卡那样光鲜亮丽,但却是确保整个计算系统真正“跑起来”的根基。下次当你选择内存条时,除了容量和频率,不妨也想想它背后那条精妙、复杂的“数据高速路”——正是这些工程师们的智慧,让我们的数字世界得以飞奔向前。

1. 网友“硬件老饕”问:看了文章,感觉接口学问真大!那我装机选内存,DDR5普条、带RCD的服务器条(比如RDIMM),还有那些高频游戏条,到底咋选?它们接口上本质区别在哪?

答:老饕你这问题问到点子上了!这几类内存的DRAM接口设计目标不同,确实适合不同场景。

普通DDR4/DDR5内存条(UDIMM):这是咱台式机最常见的。它的接口设计追求直接、低延迟,所有信号从CPU内存控制器直接连接到每一颗内存芯片。优点是响应快,成本低。缺点是当单条容量很大或插满多条时,电气负载重,信号质量会下降,所以频率和稳定性有天花板。这就好比一条从CPU家门口直接修出去的马路,车少时贼快,但车一多、目的地一远,就容易堵车、出事故。

服务器内存条(如RDIMM、LRDIMM):它们核心是加了“信号中继站”(RCD芯片,或RCD+DB芯片)-4-7。RCD就像在长距离传输中加了个信号放大器,能保证命令、地址信号清晰传达到内存条末端的每一颗芯片,因此能稳定支持更高容量、更多数量的内存条-7。代价是略微增加了一点延迟(多了一道中转)。LRDIMM连数据信号都缓冲,负载能力更强-4。这就像在主干道上建了带信号重整的枢纽站,保证长途大巴(数据)无论开往多远的目的地(内存芯片),指令都清晰无误,特别适合需要海量、稳定内存的服务器和工作站。

高频游戏/超频条(通常也是UDIMM):它们的接口和普条本质一样,但“用料”和“调教”极端。会使用更高质量的电容器、更精密的PCB布线,并在生产时用特挑的芯片,都是为了在“直接连接”的架构下,把信号完整性和时钟稳定性推到物理极限,从而达成极高的频率。这好比用顶级沥青、严格管控车道,把那条“家门口的马路”硬是修成了能跑赛车的直线加速道,追求极致的瞬时速度。

所以怎么选?普通家用游戏办公,UDIMM(包括高频条)最合适,延迟低、性价比高。如果是组多核处理器工作站、小型服务器或需要超大容量(比如128GB以上单条),RDIMM的稳定性和扩展性优势就体现出来了。普通主板不支持服务器内存,这一点务必注意。

2. 网友“折腾小白”问:大神,我想给老电脑超频内存,BIOS里那些时序参数(像CL、tRCD、tRP)调得我头晕,它们和您文章里说的“接口”有关系吗?调这些到底在调啥?

答:小白同学,恭喜你摸到了“折腾”的进阶门槛!你问的时序参数,和DRAM接口的工作流程是紧密相关的,它们本质上是规定内存芯片内部各种操作需要等待多少个时钟周期。

你可以把内存芯片想象成一个有多层结构的仓库(Bank),数据放在一个个小格子(Cell)里。接口负责传递“取货指令”,而时序参数就是这套内部物流系统的操作手册时间表。

CL(CAS Latency):这是最著名的参数。当CPU说“我要某行某列的数据”后,从发出列地址(CAS)到数据真正送到接口引脚上的延迟周期。可以理解为“从下达精准取货指令到货物出库的时间”。

tRCD(RAS to CAS Delay):从激活某一行(RAS)到可以发送列地址(CAS)之间的最小间隔。相当于“打开仓库某一层(行)的货架通道后,需要稳定一下,才能开始找具体格子(列)”。

tRP(RAS Precharge Time):关闭当前激活的行,准备打开新一行所需的最小时间。好比“关掉当前这层货架的灯和门,然后为打开下一层做准备”。

调这些参数,就是在保证稳定的前提下,尽可能压缩这个“物流时间表”。数值越小,延迟越低,响应越快。但它们受限于DRAM接口的物理特性和芯片体质:

信号质量是基础:如果接口信号本身不干净(比如主板布线差或频率太高),缩短时序就会导致指令识别错误,系统蓝屏崩溃。这就是为什么超频时常说要“加压”或“放宽时序”来保稳定,加压是为了让信号幅度更强,放宽时序是给纠错留出更多时间容限。

芯片体质是上限:不同批次的内存芯片,其内部晶体管开关速度有差异。好体质(特挑颗粒)能在同样电压下用更紧的时序工作。

所以,你的操作是在接口传输的宏观指令与芯片内部操作的微观延迟之间寻找最佳平衡点。建议先从主板XMP/EXPO预设开始,再尝试微调。记住一条:先求稳定,再求极限。不稳时,优先略微增加电压(如DRAM VDDQ),其次才是放宽时序。

3. 网友“未来观察者”问:文章最后提到DDR6和HBM,感觉好遥远。从接口技术看,未来5年对我们普通消费者影响最直接的变化会是啥?是必须换DDR6平台吗?

答:观察者你好!你的视角很实际。未来5年,接口技术的演进对普通消费者的影响,可能不是“必须换”的颠覆,而是一种体验的平滑升级和选择的多样化。

首先,关于DDR6:根据行业路线图(如SK海力士的),DDR6大约在2029-2031年登场-10。未来5年内(到2030年左右),我们大概率会处于DDR5的成熟与普及期,并逐步看到DDR6早期平台的亮相。对你来说,影响可能是:

DDR5成本下降,成为绝对主流:就像当年DDR4替代DDR3一样,DDR5内存和主板的价格会越来越亲民,性能(尤其是带宽)远超DDR4。新装机的朋友,DDR5平台会成为高性价比之选。

DDR6初期的“观望期”:第一批DDR6平台(可能搭配新一代CPU)上市时,价格会偏高,且需要主板、CPU全部更换。对于大部分普通用户(游戏、办公),成熟的末期DDR5平台性能已完全过剩,没必要立即追新。DDR6的真正优势(比如可能更高的带宽、更优的能效)在消费级领域需要时间体现。

更直接的影响可能来自其他接口技术的“跨界”融合:

LPDDR内存进入台式机/笔记本:低功耗的LPDDR5/LPDDR6,传统上用于手机。但现在,像苹果M系列芯片、英特尔某些移动平台,已将LPDDR内存直接封装到处理器旁边(称为板载内存)。这种方式通过极短的物理距离和优化的接口,能获得极高的带宽和能效。未来,这种“一体化”设计可能从高端轻薄本向更多设备扩展,带来更省电、更紧凑的设备。

CXL(Compute Express Link)接口的影响:CXL是一种基于PCIe的高速互连协议,它允许CPU以更高效的方式访问内存扩展卡、加速器内存等。未来你可能看到,主板除了插普通内存条,还有一个CXL插槽,可以插上一张“大容量内存扩展卡”,轻松将电脑内存从64GB扩展到1TB以上,这对于视频剪辑、大型科学计算的爱好者会非常有用。这可以看作是一种更灵活、更强大的“外部内存接口”。

总结一下:未来5年,普通消费者不必焦虑于DDR6的换代压力,反而可以尽情享受DDR5成熟带来的高带宽红利。更值得关注的是,内存的形态和连接方式可能会更加多样(板载、扩展卡等),让你能根据自己的需求(极致能效、极致容量、极致带宽)做出更灵活的选择。技术的进步,最终是为了提供更丰富、更贴合需求的体验,而不仅仅是参数的飙升。