电脑开机后,CPU开始急速运转,屏幕上流畅的游戏画面和秒开的网页背后,是一套精密复杂的内存结构在默默运转。每当你为加载太慢而烦躁时,可能就是内存架构在某个环节上“打了个盹”。

当你今天插上那根16GB的DDR4内存条时,可能不知道它内部隐藏着一个多层级的微型宇宙。

现代DDR内存的基本架构从顶层到底层可以分为通道、DIMM、rank、bank group、bank、子阵列等层次-3。每个层次都不是随机堆砌的,而是工程师们为解决特定问题精心设计的解决方案。

就拿最常见的DDR4内存来说,当你打开任务管理器看到内存占用率时,背后是多个通道在同时工作。每个通道提供64bit的位宽,通常由8个DRAM芯片共同实现,每个芯片贡献8bit-3。

这种分层结构就像一个大城市的交通网络,数据不会全部挤在一条高速路上,而是有组织地在不同层级的道路间分流和汇聚。

内存控制器会向下发送包含对应DRAM地址的指令,从而在对应的内存位置读取数据-3。最底层的子阵列由数个块组成,水平方向上的块共享一个行解码器,每次读取会选择其中一行激活到行缓冲区-3。

DRAM的核心记忆单元结构为1T1C,也就是一个读取电晶体管和一个电容-4。这个小得惊人的结构决定了整个内存行业的天花板。

电晶体管控制着数据进出的“门禁”,而电容则负责“记住”0或1。选电容当存储单元的原因其实很朴素——电容是电子电路中最基本的三种元件之一,自然成为存储信息的选择-4。

电晶体管的栅极连有字线,施加电压后可以让晶体管处于开启状态,可以用来执行读、写或更新操作-4。位元线则连接电晶体的汲极,将自电容通过已开启电晶体的电荷送到感测放大器侦测0或1的信号-4。

像棋盘线交错的字线和位元线可以准确定位每一个记忆体单元,让周边线路挑选以读写其中信息-4。这就是你每次点击保存时,数据在内存中的精确落脚点。

电荷在电容中并不稳定,会慢慢流失,所以内存需要定期刷新-4。目前DRAM的信息刷新时间一般为64毫秒-4。这意味着即使你不做任何操作,内存也在默默地进行自我维护,防止数据“挥发”。

过去几十年里,DRAM组织结构演进的主线就是如何在更小的空间内容纳更多的存储单元。当制程工艺进入20纳米以下时,问题开始变得棘手。

DRAM的基本结构在微缩过程中遇到了尖锐挑战-4。问题核心在于:制程微缩的方向与DRAM使用的晶体管以及电容所需的物理特性背道而驰-4。

首先就是电容值的问题。2000年左右的电容值必须保持在40fF左右,当时的电容已经开始利用芯片上的垂直空间,要么挖成深沟状放在晶体管下方,要么堆叠成圆柱状置于晶体管上方-4。

但制程微缩会让圆柱底部缩小,电容面积减少,电容值也会随之降低。为了维持足够的电容值,必须增加电容的高度,导致圆柱的宽高比越来越大-4。

以10纳米级别制程为例,电容值必须维持在10-20fF以上-4。不过当宽高比到达1:50左右时,就很难再推进了,因为过高的圆柱会造成蚀刻难度大增,尖锐的底部形状也会引发新的电性问题-4。

电晶体方面问题同样严峻。DRAM晶体管最注重的是漏电流控制,因为漏电流会严重影响电容保存信息的能力-4。

栅极感应汲极泄漏是主要问题之一,指的是栅极的电位高于汲极的电位时,即使晶体管处于关闭状态,电流仍然会从汲极泄漏流向衬底-4。

随着制程微缩,晶体管通道变短,栅极对通道上电流的控制能力减弱,这就是所谓的短通道效应-4。漏电流问题因此变得越发棘手,直接限制了制程的进一步缩小。

面对这些挑战,工程师们提出了各种创新的DRAM组织结构方案。在晶体管结构上,出现了凹槽式通道阵列晶体管、鞍鳍晶体管、具有栅极工作功能控制的埋栅晶体管等新型结构-4。

这些设计都是为了在晶体管尺寸不断缩小的前提下,依然保持对电流的良好控制。你看那些科技新闻里“突破性内存技术”的报道,大多数都是在这些微观结构上做出了改进。

而针对电容问题,业界一方面在开发更高介电常数的材料,另一方面也在探索全新的电容结构。比如将电容做成更复杂的立体形状,在有限空间内获得更大的有效面积。

有意思的是,当平面微缩遇到瓶颈时,工程师开始将目光投向第三维度。3D堆叠DRAM技术逐渐成为新方向,不再一味追求在平面上缩小单元尺寸,而是通过垂直堆叠来增加存储密度。

不同的DRAM组织结构直接决定了内存的性能特点。传统DDR内存依靠增加通道和提升频率来增加带宽,但这种方法受限于主板布线能力和信号完整性问题。

更高带宽的内存如HBM则采用了截然不同的结构,通过硅通孔技术和2.5D/3D堆叠,将多个DRAM芯片与逻辑芯片紧密集成在一起,实现了超高的带宽和能效比。

随着人工智能和大数据应用爆发,对内存带宽的需求呈指数级增长,这也推动了DRAM组织结构的快速演进。传统的平面分层结构正在被更立体的集成方式所取代。

回答:当然有关系!简单说,双通道就是把内存控制器通往内存的道路从一条扩展成了两条。

在DRAM的组织结构里,“通道”是最高层级的通信路径。每个通道能提供64位的数据位宽,传统的单通道内存就只有这么一条64位的“高速公路”连接CPU和内存。当你启用双通道时,相当于有两条64位的并行道路,总位宽达到128位,数据吞吐量理论上翻倍-3。

这就像是把单车道扩建成了双车道,堵车情况自然缓解很多。在实际的硬件上,主板上会有颜色标识的内存插槽,将两根内存插入对应颜色的插槽就能启用双通道模式。

不过要注意的是,这个“翻倍”是理论最大值,实际体验取决于很多因素。有些应用对内存带宽特别敏感,比如核显玩游戏或者视频编辑,双通道提升会比较明显;而对于一些更依赖内存延迟的应用,双通道带来的改善可能就没那么显著了。

回答:这问题问到点子上了!根本原因就在于它们存储数据的物理原理完全不同。

DRAM用的是电容存储电荷来表示0和1,而电容有个天然缺陷——会漏电。就像漏气的轮胎需要定期打气一样,DRAM中的电荷也会慢慢流失,所以必须定期刷新(给电容充电)来保持数据-4。目前的行业标准是每64毫秒刷新一次-4。

而闪存用的是浮栅晶体管,通过困住电荷在绝缘层中来存储数据,这种结构下电荷能保持很久,完全不需要主动刷新。这也是为什么固态硬盘断电后数据能保存多年,而内存一断电数据立刻就没了。

两种技术各有利弊:DRAM的刷新机制虽然麻烦,但换来的是极快的读写速度和几乎无限的擦写次数;闪存虽然不需要刷新,数据保持时间长,但写入速度慢,而且有擦写次数限制。所以电脑需要同时使用这两种存储器,让它们各司其职。

回答:这是个价值亿万美元的问题!从目前趋势看,DRAM在可预见的未来仍将占据主流,但会经历重大变革。

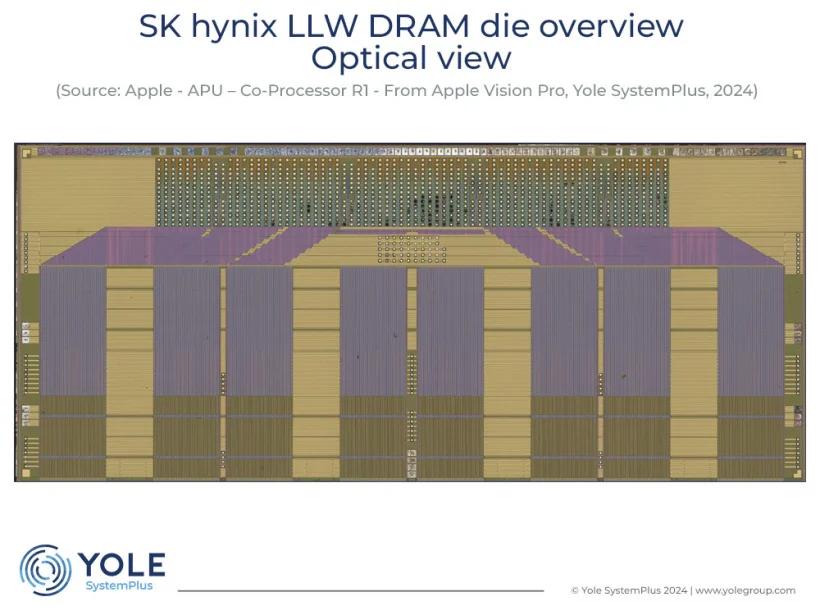

在结构上,2.5D/3D堆叠是明确方向。通过硅通孔等技术将多个DRAM芯片垂直堆叠,能大幅提高带宽和能效比。三星、SK海力士和美光都在这个领域激烈竞争-7-9。

工艺方面,EUV光刻技术正成为竞争焦点。三星已经在超过五层工艺中使用EUV,而美光则采取更谨慎的策略,只在关键层使用-10。这种技术路径的分化将影响未来高端市场的竞争格局。

至于替代技术,像磁阻内存、相变内存等新型非易失性内存确实在崛起,它们有可能在某些领域取代DRAM,但全面替代还为时过早。更可能的未来是“内存-存储”层级结构的模糊化,不同类型的存储器通过CXL等高速互联技术形成统一的存储池。

未来几年的看点是HBM等高带宽内存的普及,以及存算一体等新架构的成熟。不过无论技术怎么变,满足应用需求、控制成本仍将是驱动行业发展的两大核心动力。