打开手机查看一张照片,或是在电脑上处理一份文档,背后都有无数个微小电荷在动态随机存取存储器的精密网格中奔流不息。

DRAM芯片图中的每个单元,都像是一个需要定时补水的微型水桶,通过1个晶体管和1个电容的简单组合,承载着数字世界最基础的0和1-1。

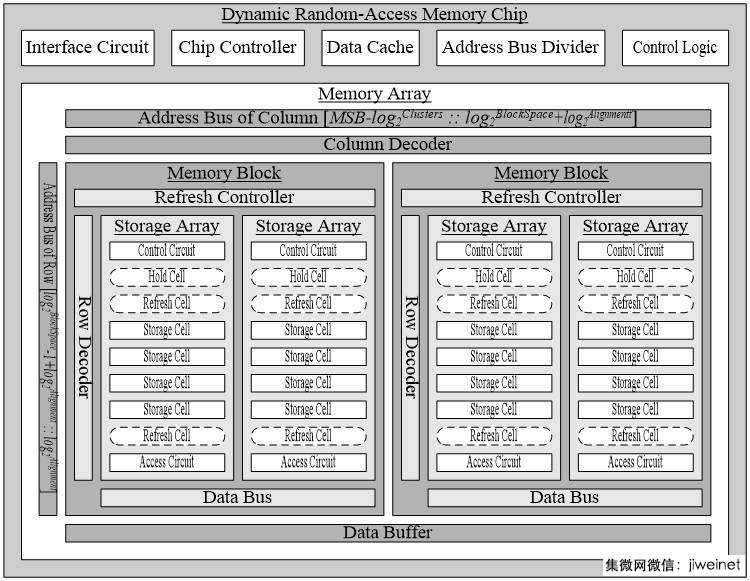

这块被称为动态随机存取存储器的芯片,内部结构比城市交通网络更加精密复杂。每个存储单元所占的面积仅为整个芯片的50%-55%,其余空间被外围电路和周边线路占据-8。

DRAM芯片图乍看之下像是一个精密的蜂巢,但它的运作方式却更加动态和脆弱。与它的兄弟SRAM不同,DRAM需要定时“刷新”来维持记忆。

这是因为它的存储原理基于电容中的电荷——有电荷代表1,无电荷代表0-1。

但电容会漏电,就像水桶会慢慢蒸发水分。因此DRAM必须定期读取每个单元的内容,将电荷恢复到理想水平,这个过程大约每32毫秒就要进行一次-8。

这种“动态”特性给设计带来了挑战,但也使DRAM能够以更小的面积存储更多数据。从经济角度看,DRAM的成本远低于SRAM,而存储密度却远高于后者-7。

如果你仔细观察一张高分辨率的DRAM芯片图,会发现它最基本的构建单元是1T1C结构——一个晶体管加一个电容-1。

这个简单结构背后是数十年工程优化的结果。晶体管充当开关,控制对电容的访问;而电容则负责保存电荷,也就是保存数据。

在制造过程中,工程师们面临一个棘手问题:如何在越来越小的空间内容纳足够的电容来存储可检测的电荷量?随着制程微缩,这个问题变得越来越尖锐-9。

为了解决这一挑战,业界发展出了两种主要技术:沟槽电容和堆叠电容。沟槽电容向下挖掘硅片,而堆叠电容则向上建立结构-9。

把这些1T1C单元排列起来,就形成了DRAM的核心——存储阵列。想象一个巨大的停车场,每个车位就是一个存储单元,通过行地址和列地址来定位-1。

阵列的组织方式并非随意。早期的设计试图在一条位线上挂接尽可能多的单元,但很快发现这样会导致位线过长,电容值增大,最终拖慢性能-4。

现代DRAM采用更智慧的设计,通过二维行列结构将单元组织成网格状。当CPU请求数据时,DRAM首先解析行地址,选中一行数据加载到行缓存中,然后根据列地址挑选出具体数据块-1。

这种方式效率高得多,特别是当需要访问同一行中的多个数据时,因为行缓存已经准备好了整行数据,只需改变列地址就能快速获取相邻数据。

一个完整的DRAM芯片图展现的是多层级的复杂架构。从最小的存储单元开始,向上逐级组织成存储阵列、存储块、芯片、模组-1。

一个芯片包含多个存储块,不同块共享控制线、地址线和数据线。由于芯片引脚数量有限,每个芯片通常只支持4到16比特的数据位宽-1。

为了满足现代计算机64比特的数据位宽需求,多个芯片被组织成“秩”的结构。在一个秩中,不同芯片共享地址线和控制线,但各自提供一部分数据位-1。

我们常见的内存条上往往正反两面各有一排芯片,每面8个芯片组成一个秩,这样一个双面内存条就包含两个秩-1。

从DDR到DDR4,再到如今的DDR5,DRAM芯片图记录了这一技术不断追求更高带宽的历程。带宽的计算公式很直观:带宽 = 时钟频率 × 总线宽度 × 每时钟数据段数 / 8-8。

在AI和大数据时代,传统DRAM面临新的挑战。随着AI大模型从训练走向推理应用,数据计算强度呈指数级增长,“存储墙”问题日益凸显-10。

这就好比一条高效的生产线,如果物料供应跟不上设备加工速度,再先进的生产设备也无法发挥应有效能-10。

为了突破这一瓶颈,高带宽存储器应运而生。HBM通过3D堆叠架构和硅通孔技术,将多个DRAM芯片垂直集成,实现了带宽的跨越式提升-10。

从手机到数据中心,DRAM无处不在。2022年的数据显示,移动终端、服务器和PC分别占据DRAM下游应用市场的35%、33%和16%-2。

这三个领域加起来已经超过了80%的市场份额,但剩余的份额分散在汽车电子、物联网等新兴领域,这些正是未来增长的关键点。

特别是在AI时代,DRAM的角色正在发生根本性转变。它不再仅仅是“系统内存”,而是升级为“算力基石”,在AI算力构建中发挥着不可替代的作用-10。

随着AI服务器与大型语言模型对内存带宽需求大增,HBM这类高性能DRAM的市场前景广阔。国际研究机构预测,全球HBM市场规模将从2024年的170亿美元增长至2030年的980亿美元-5。

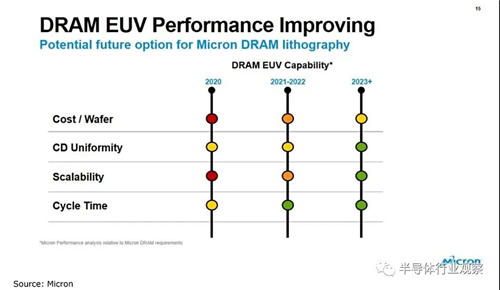

面对平面DRAM制程逼近物理极限的挑战,产业正在转向立体化。三星、SK海力士、美光等巨头正在积极布局3D DRAM-5。

三星正在开发垂直通道晶体管DRAM,预计最快2到3年内推出实际产品;SK海力士已经展示了5层堆叠原型,良率达到56.1%-5。

与此同时,中国DRAM产业也在迎头赶上。在长江存储专注于NAND Flash的同时,长鑫存储正代表中国企业与全球三大DRAM巨头同台竞技-10。

中国DRAM市场规模已从2020年的1667亿元增长至2024年的2380亿元,预计2025年将达到2517亿元。这一庞大的市场需求正在转化为产业发展的强劲动力-10。

当我们在手机屏幕上滑动时,指尖触碰的是经过数百万个1T1C单元传递的数据流,每个单元比红细胞还小,却支撑着整个数字世界的记忆需求-8。

从个人电脑的DDR内存条到AI服务器中的HBM堆叠,DRAM芯片图描绘的不只是电路连接,更是人类信息处理能力进化的轨迹-5。

如今全球DRAM市场三强鼎立,但随着3D堆叠、近存计算等新技术路线的发展,这幅产业版图正在被重新绘制-10。

1. 问:我经常听说DRAM需要“刷新”,这个过程会不会拖慢电脑速度?

这是个很实际的顾虑!DRAM刷新确实需要占用资源,但现代设计已经把这影响降到了最低。刷新过程大约每32毫秒进行一次,每次只针对一小部分存储单元-8。

更重要的是,刷新操作完全在DRAM芯片内部进行,不需要数据流入或流出芯片,这最大限度地减少了系统资源的占用-8。

实际上,刷新操作消耗的功耗仅占DRAM总功耗的10%左右,而带来的好处是DRAM能以更小的面积存储更多数据,成本也更低-8。正是这种权衡使DRAM成为个人电脑和手机内存的主流选择。如果没有这种“动态”特性,我们可能得多花好几倍的钱买内存,或者带着像砖头一样厚的手机。

2. 问:为什么DRAM市场被几大巨头垄断,新公司很难进入?

这个问题触及了DRAM产业的核心壁垒。首先,技术门槛极高——DRAM需要在纳米尺度上制造由晶体管和电容组成的精密单元,对电荷控制和工艺精度的要求达到原子级别-10。

专利壁垒森严。三星、SK海力士、美光等巨头已经构筑了严密的专利网络,新进入者需要投入大量资源进行研发和专利规避-10。

再者,生态认证漫长。高端服务器、通信设备等市场对DRAM的稳定性要求极高,供应商需要经历长达数年的严格认证才能进入供应链-10。一旦入围,就会形成强大的客户粘性。DRAM是高度标准化产品,只有实现大规模量产和极高良率,才能抵消巨额研发和资本开支,这也构成了强大的规模经济壁垒-10。

3. 问:AI时代对DRAM有什么特殊需求?普通电脑的DRAM不能用在AI服务器上吗?

AI确实给DRAM带来了全新挑战。传统DRAM面临的主要问题是“存储墙”——当处理器速度越来越快时,内存带宽跟不上,就像高效生产线遇到物料供应瓶颈-10。

为此,高带宽存储器应运而生。HBM通过3D堆叠技术,将多个DRAM芯片像楼层一样垂直堆叠起来,并使用硅通孔技术在层间建立数千个垂直连接-10。这种设计大幅提升了带宽,同时减少了功耗和占用空间。

普通电脑的DRAM确实不能满足AI服务器的需求。AI模型训练需要同时处理海量数据,对内存带宽和容量的要求远高于传统应用。目前高端AI芯片往往配备数百GB甚至TB级别的HBM内存,带宽可达普通DDR5内存的十倍以上-5。