哎呀,不知道大家有没有过这种经历哈?兴致勃勃地装了一台新电脑,CPU是顶配,显卡是最新款,可有时候加载个大游戏或者处理个视频,总觉得差点意思,不是那么“跟手”。这时候,老鸟们可能会幽幽地说一句:“内存拖后腿了吧?”其实啊,这“后腿”很可能就出在很多人不太注意的地方——DRAM的IO区。今天咱就唠唠这个藏在内存条芯片里的“交通枢纽”,看看它到底是咋工作的,为啥它一“堵车”,你电脑再强的芯也得干等着。

咱先打个比方。你把DRAM存储单元(就是那个靠电容存电荷的小格子-2)想象成一个个巨大的立体仓库,里面堆满了数据。而CPU呢,是个急性子的加工厂,需要不停地从仓库里取原料(数据)。这个仓库本身内部搬运货架的速度,也就是DRAM的核心操作速度,其实并不快,大概在200 Mb/s的量级-1。

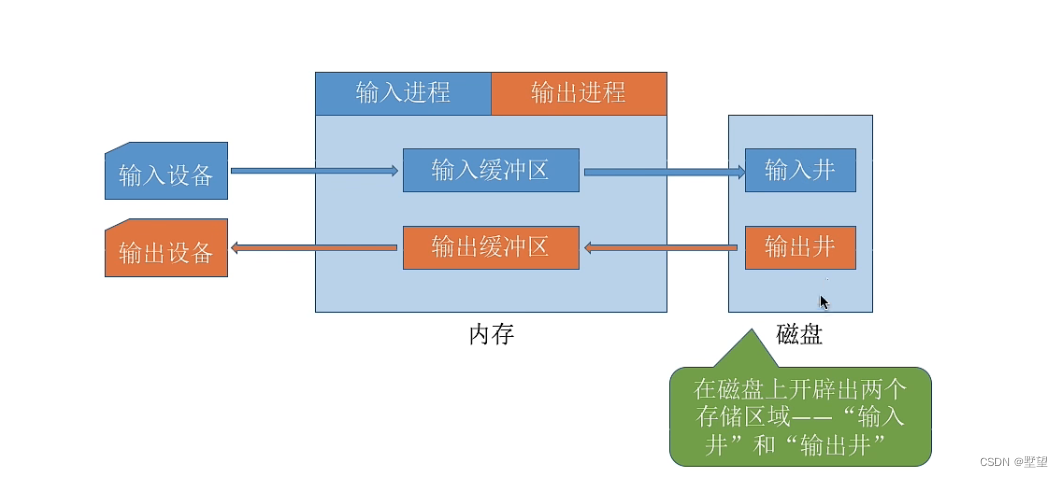

但你看现在的内存标准,动不动就是几千甚至上万Mb/s的传输率,这是咋做到的?奥秘就在于DRAM的IO区。它就像是仓库出口处一个超级高效、多条车道并行的高速公路收费站-1。仓库内部可能用叉车一次搬出来一大堆货物(这就是“预取”技术),然后到了IO区这个“收费站”,所有货物被快速分拣、打包,同时通过好多条收费通道(也就是IO引脚)以极高的速度发射出去。这样一来,尽管仓库内部搬运速度慢,但凭借出口的并行高速发射,整体数据传输率就猛飙上去了,比如早期的GDDR5就能实现单引脚7Gb/s的速率-1。所以,这个IO区根本上决定了内存条最终能跑多快,是连接慢速存储核心和高速外部世界的桥梁。

但是,这个“收费站”的设计,可是工程师们掉头发的主战场。这里有个核心矛盾:存储单元阵列做得越来越密,容量越来越大,但连接到IO区的“内部道路”——也就是全局位线(Global Bitline)——数量却因为成本和布线复杂度的限制,不能无限增加-7。这就好比仓库扩建得越来越大,但通往收费站的干线公路还是那么几条,很容易就成为瓶颈。

特别是在3D堆叠DRAM(像HBM那种)里,这个问题更明显-7。多个存储层通过硅通孔(TSV)垂直叠起来,对外通道的总带宽是挺高,但每一层内存数据通往本层IO接口的内部带宽是有限的-7。如果只能同时访问一个层,那巨大的外部通道带宽就浪费了。这就引出了新技术,比如“同步多层访问”(SMLA),想法就是让多个存储层同时干活,协调好数据流,共同利用好高速出口,从而把内部带宽整体提上去-7。

在IO电路本身,信号完整性也是大挑战。速度跑到每秒几十亿次传输时,信号容易衰减、变形,还会受到电源噪声干扰-3。为了让你收到的数据信号眼图睁得足够大、足够清晰(好判断是0还是1),工程师们在IO区的驱动器里加入了“预加重”技术,这有点像在喊话时提前提高音调,以抵消远距离传输的衰减-3。同时,接收端也得特别设计,让它对电源电压波动不那么敏感,保证稳定识别-3。这些精细活,都发生在IO区这个方寸之地上。

看到这,你可能觉得这都是芯片设计公司的事。但其实,理解了这些,你就能看懂内存规格里那些术语的深意了。

比如,为什么高频率、低时序的内存条又贵又受欢迎?高频率直接提升了IO接口“收费站”的车辆放行速率。而低时序(尤其是CL值)部分反映了数据从仓库里找到并送到IO接口的延迟。这两者结合,才能带来真正的流畅体验。

再比如,为什么显卡用的GDDR和电脑用的DDR走向了不同的设计道路?因为显卡需要极高的带宽来处理并行的图形数据流,所以它的IO区设计更激进,引脚数量、预取架构都朝着极致带宽优化,功耗和延迟相对是次要考虑。而系统内存(DDR)更需要平衡带宽、延迟、容量和功耗,是一个更综合的工程。

最新的LPDDR5X等移动内存标准,其进步也深刻体现在IO技术上。通过采用自预加重驱动器和优化的时钟树等新型IO电路,在提升至8.5Gbps速率的同时,还能比前代降低约20%的功耗-3。这正是IO区设计精进的直接成果,它让我们的手机在更快的运行速度下,还能保持甚至延长续航。

所以,下回你再挑选内存条或者看手机发布会,听到那些复杂的参数时,可以想想背后那个默默工作的DRAM的IO区。它虽不起眼,但正是这一点一滴的技术攻坚,在持续打破着数据流动的“墙”,推动着我们整个计算体验的升级。科技的魅力,不就在这些解开束缚、让信息自由奔跑的细节之中嘛。

1. 网友“硬件萌新”问:大佬讲得好详细!但我还有个基础问题,您说的DRAM核心速度(200Mb/s左右)和我们在商品页看到的内存条速度(比如DDR5-4800,指4800MT/s)差距巨大。这个差距全是由IO区的“预取”技术弥补的吗?具体是怎么“预取”的呢?

答:哎呀,这问题问到点子上了!确实是这么巨大的差距,而“预取”是其中最关键的魔法之一,但也不是唯一的魔法。我来细说一下。

你可以把“预取”想象成仓库(存储阵列)的搬运策略。假设CPU每次想要64比特数据。如果仓库搬运工(核心操作)一次只搬1比特,那为了凑齐64比特,他就得来回跑64趟,慢死了。所以,现代DRAM的设计是:既然跑一趟,我就多搬点!这个“一趟搬多少”的倍数,就是预取位数。

比如在DDR SDRAM时代,DDR1的预取是2位,DDR4是8位,到了DDR5更是达到了16位-1。这是什么意思呢?当CPU需要一个数据时,IO区的控制逻辑会一次性从存储阵列里把连续的一长串数据(比如16位)都读到行缓冲区(Row Buffer,可以理解成仓库门口的临时周转区)里-2。虽然核心操作还是那个慢速(比如200Mb/s),但因为它一次读取的数据量很大,所以等效的“数据供给速率”就提高了。

IO区的高速并行接口(就是那些引脚)再从行缓冲区里,精准地选取CPU需要的那部分数据,以非常高频率的时钟(利用DDR技术的上升沿和下降沿都传数据)发射出去。这样一来,内部慢速的批量取货,加上外部高速的精准发送,就实现了核心低速到接口高速的转换。

所以,你看到的4800MT/s(百万次传输/秒),是IO接口最终对外的爆发速度。这背后是预取架构(增大单次数据量)、双倍数据率(一个时钟周期传两次数据) 和高位宽接口(多条数据线并行) 共同作用的结果。DRAM的IO区,正是协调这套“内部慢搬,外部快发”流水线的总指挥。

2. 网友“装机纠结者”问:看了文章,那我选内存条,是频率越高越好,还是时序越低越好?IO区的优劣,在商品参数上能直接看出来吗?

答:哈,这是个经典的“要跑车极速还是起步快”的权衡问题,我聊聊我的看法。

首先,频率(如4800MHz)和时序(如CL40)都重要,但它们描述的侧面不同。频率,基本直接对应IO区对外发射数据的“时钟节奏”,决定了数据传输的“最大吞吐率”,就像高速公路的车流速度。时序(尤其是CL值),则更多反映了数据从存储阵列寻址、读取到送至IO接口的“初始延迟”,就像你从家门口开车上高速入口所需的时间。

理想情况当然是“高频率+低时序”。但物理学定律和成本摆在那儿,通常频率冲得很高时,维持极低的时序会非常困难,所以高频率内存的CL值往往也更高(比如DDR5-4800的CL值可能比DDR4-3200的高)。

那怎么选呢?看你的应用:

如果你是游戏玩家,特别是玩那些对延迟敏感的电竞游戏、开放世界游戏,游戏中经常要随机访问大量小数据,那么“低时序”带来的延迟降低,感知可能更明显。优先在频率达标(比如当前平台主流)的前提下,选时序更低的产品。

如果你是内容创作者,需要处理视频剪辑、大型工程文件,这些应用更依赖于连续、海量的数据吞吐,那么更高的频率和带宽带来的收益更大。此时可以稍微放宽对时序的要求。

至于IO区的优劣,在消费级产品参数上很难直接体现。它是芯片内部的设计水平。但我们可以间接判断:选择知名品牌的原厂颗粒(如三星、海力士、美光)产品,通常意味着其内部的IO区电路设计更成熟、信号完整性更好,也更能稳定支持其标称的频率和时序。那些能轻松超频到很高频率且稳定的高端内存条,其IO区的体质和设计通常也更优秀。

3. 网友“未来科技控”问:文章提到了3D堆叠和HBM,说IO区瓶颈更突出。那像现在AI计算这么火,对内存带宽要求变态高,未来的DRAM的IO技术会往什么方向发展?我们普通电脑会用上HBM那种东西吗?

答:这个问题很有前瞻性!AI计算确实是驱动内存技术极限发展的最大动力之一。未来DRAM的IO区技术,我觉得会沿着这几个方向“卷”:

继续“堆”并行度:这是最直接的路。HBM(高带宽内存)其实就是把多个DRAM芯片通过硅通孔(TSV)垂直叠起来,并在最底层用一个面积很大的“中介层”互联,从而实现超高位宽(1024位甚至2048位)的IO接口-7。相比台式机DDR的64位宽,这相当于把高速公路从64车道直接扩宽到上千车道。未来,堆叠层数、TSV密度和中介层技术会继续进步,让带宽再上台阶。

“同步多层访问”等智能调度技术普及:就像文中提到的SMLA技术-7,未来的IO控制器会更智能,不再是简单地访问一层,而是能协调多层同时工作,并发地准备和传输数据,把内部通道的利用率榨干,最大化外部带宽。这需要更复杂的IO区控制逻辑和协议支持。

IO电路本身的速度与能效比竞赛:传输速率不会停止,比如从8.5Gbps向10Gbps以上迈进。这就需要文中提到的那些更先进的驱动器、接收器、时钟同步和电源管理技术-3。同时,如何在提速率的同时控制住功耗(特别是对移动设备),是永恒的主题。新材料(如新型晶体管)也可能被引入IO区。

关于普通电脑用HBM,短期内大概率不会。主要原因还是成本。HBM的复杂3D封装工艺极其昂贵。它对带宽的需求是极致的,但大多数消费级应用(游戏、办公)对带宽的需求,目前高性能的GDDR(用于显卡)和DDR5/DDR6(用于主机内存)已经能够较好地满足。AI PC的发展可能会成为一个变数,如果端侧大模型应用爆发,对内存带宽产生颠覆性需求,那么将HBM或类似技术引入高端PC平台也是可能的。但对我们大多数普通人来说,未来一段时间,更可能享受到的是这些高端IO技术“下放”带来的DDR标准进步,比如更高频率、更高能效的下一代DDR内存。