美光科技宣布退出消费型内存市场的消息,如同一颗投入湖面的石子,在行业内外激起了层层涟漪,也让我们普通用户看着电脑配置单上越来越贵的“内存条”价格直皱眉头-9。

市场调研显示,消费级DDR4内存的价格在短期内曾出现惊人的上涨,甚至一度反超了新一代的DDR5产品-6。背后的逻辑很直接:AI数据中心就像巨大的内存吞噬者,把厂商的产能和注意力都吸走了-8。

当依赖传统“堆内存”的路径变得越来越昂贵,一种更聪明、更精细化的内存使用哲学——“DRAM Off”——开始从企业级数据中心向更广阔的应用领域渗透。

当前的DRAM市场,用“疯狂”来形容并不为过。这不只是普通消费者在装电脑时感觉内存条贵了,而是一场席卷全球供应链的结构性风暴。

从2025年下半年开始,DDR4等旧世代产品因厂商宣布逐步停产(EOL),导致价格在短时间内暴涨超过40%,出现了“旧比新贵”的倒挂奇观-3。

风暴的“风眼”是人工智能。为AI服务器提供动力的高频宽内存(HBM),其需求呈爆炸式增长。TrendForce预测,到2026年,HBM在DRAM总销售额中的占比将从2023年的8%激增至41%-5。

几乎所有的HBM产品都流向了英伟达、AWS、谷歌和AMD等少数几家研发AI芯片的巨头-5。为了追求更高的利润,三星、SK海力士、美光等主要制造商正将产能大规模转向HBM和高端DDR5产品-6。

其直接结果就是,用于消费电子和普通服务器的标准DRAM供应被大幅挤压。IDC的分析甚至预测,这种短缺局面可能会持续到2027年,并重塑全球设备市场的格局-8。

“DRAM Off”并不是一个具体的产品,而是一种设计和架构哲学。它的核心思想是:通过系统性的优化,最大限度地减少对昂贵、紧缺的DRAM的依赖,用更聪明的方法满足计算需求。

这绝不是简单地减少内存条,而是“好钢用在刀刃上”。企业级云架构已经摸索出了一些成熟路径,这些思路正变得对普通开发者和用户具有参考价值。

首先是内存分层。你可以把DRAM想象成办公室桌面上最顺手的位置,而NVMe固态硬盘就像旁边的文件柜。

内存分层技术将二者结合成一个统一的逻辑内存空间。系统会智能地将最频繁访问的“热点”数据留在DRAM(第0层)中,而将不常用的“冷”数据迁移到速度稍慢但容量大得多的NVMe存储(第1层)中。

VMware的实践显示,这种技术可以实现虚拟机密度翻倍,而性能影响通常低于5%-2。对于用户而言,这意味着在有限的硬件上能同时运行更多任务。

其次是模型量化,这尤其针对AI应用。 AI模型通常使用FP32(单精度浮点数)格式,每个参数占据4字节。通过量化技术,可以将精度降低为INT8(整型8位)甚至FP4,将内存占用减少75%至87.5%-2。

尽管精度略有损失,但在许多推理场景下,准确率仍能保持在95%以上,这种以极小精度代价换取巨大内存和算力节省的做法,正变得越来越流行。

一些更激进的“DRAM Off”探索,正在试图彻底摆脱对外部DRAM的依赖。这听起来有些不可思议,但在特定的边缘计算场景中,已经成为现实。

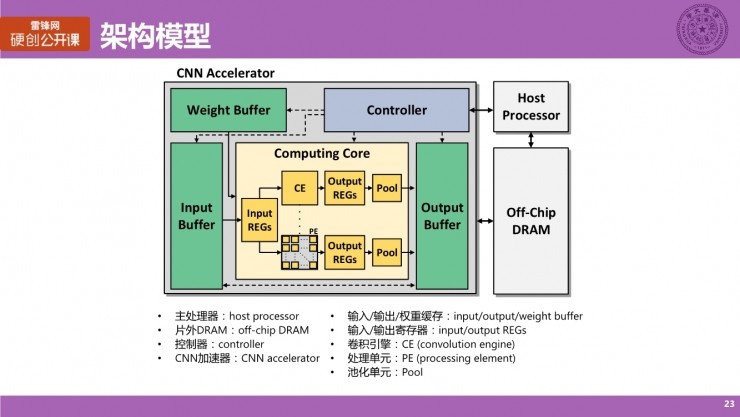

以Hailo-8和Hailo-8L这类AI加速器为例,它们采用了“DRAM-less”设计,将整个推理过程所需的存储都集成在芯片内部-2。

这样做的好处显而易见:它移除了设备中最受供应链制约、价格波动也最剧烈的DRAM组件,仅此一项就能为每台设备的物料成本降低多达100美元-2。

同时,由于数据无需在芯片外的DRAM中来回搬运,访问延迟极低,功耗也更小,非常适合对功耗、成本和实时性要求苛刻的物联网、自动驾驶传感器等边缘设备。

当然,这种方案牺牲了灵活性,但它指明了一个方向:为特定任务定制化设计计算单元,通过架构创新来规避通用硬件的瓶颈。这不正是“DRAM Off”思想的终极体现吗?

拥抱“DRAM Off”的理念并非没有代价,它本质上是一系列精细的权衡。首先面临的就是性能与成本的拉锯。将数据从快速的DRAM迁移到NVMe,必然会引入额外的延迟。

尽管高端NVMe的读取延迟可以控制在200微秒以内,但这对于要求亚毫秒级响应的极低延迟应用(如高频交易)来说,仍然是不可接受的-2。

其次是对软件和开发者技能提出了更高要求。实施内存分层、模型量化或异构计算,不再是“插上内存条就能用”的简单操作。

它要求开发者和系统架构师深入理解应用的数据访问模式,进行针对性的设计和调优。例如,模型量化就需要收集代表性的数据集进行校准,并对不同层进行敏感性分析,以确保精度损失在可控范围内-2。

最后是复杂性的增加。一个融合了多种内存类型和计算单元的系统,其部署、监控和故障排查的复杂度远高于同质化的传统系统。企业需要更强大的运维工具和专业知识来驾驭这套新体系。

展望未来,“DRAM Off”所代表的精细化内存管理,很可能从一种应对短缺的权宜之计,演变为可持续计算的常态。技术的演进正在两个方面为这一趋势铺路。

一方面,新硬件在不断涌现。英特尔、AMD等CPU厂商正积极在其平台中集成对内存分层和新型存储器(如CXL协议下的内存池化)的支持。

另一方面,软件生态也在快速成熟。像vLLM这样的开源项目,通过其PagedAttention等技术,已经能够为大型语言模型推理带来30-50%的内存节省-2。这些工具正使得先进的“DRAM Off”技术变得更容易被广大开发者所采用。

对于普通用户和中小企业来说,立即采用最前沿的技术或许不现实,但建立“内存效率意识”正当时。在采购新硬件时,不再单纯追求大内存,而是评估自己的真实工作负载。

在日常使用中,养成优化软件设置、及时清理后台无用进程的习惯,同样是“DRAM Off”理念在个人层面的实践。

当每一份内存资源都被珍惜和高效利用时,我们或许能在AI浪潮带来的硬件需求风暴中,找到一条更稳健、更经济的航行之路。

问:作为一个普通电脑用户,不是搞AI的,DRAM短缺和“DRAM Off”这些高大上的概念跟我到底有啥关系?我能做点啥?

当然有关系,而且关系不小!您可能已经感觉到了,这两年想给老电脑升级内存,或者买新电脑时,内存部分的预算比过去高了不少-6。这就是全球供需波动传导到我们消费者身上的直接体现。

您可以做的第一件事是 “审视真实需求”。很多人习惯性认为内存“越大越好”,但您不妨打开任务管理器,看看在日常最重度使用时,内存占用是否真的超过了16GB。如果很少突破,那么在配新机时选择32GB而非跟风上64GB,就是最直接的“个人DRAM Off”,能省下不少钱。

第二是 “优化使用习惯”。这就像节水节电一样。关掉开机自启动的、用不上的软件;浏览器不要一次性打开几十个标签页;定期重启电脑,都能有效释放被无意义占用的内存。对于游戏玩家,关注游戏内的纹理质量、视野距离等图形设置,这些选项往往比分辨率更消耗内存。

第三,如果确实需要升级,可以 “关注时机与替代方案”。目前市场上DDR4和DDR5价格波动剧烈-3。如果您的平台同时支持两种规格,不妨计算一下性价比。有时候,将16GB DDR5换成32GB DDR4,花费更少而获得的总容量更大,对多任务性能的提升可能更显著,这也是一种灵活的应对策略。

问:我是一个小公司的IT运维,老板看到云服务账单上涨很头疼。您提到的这些企业级“DRAM Off”方案,我们这样规模的公司能落地吗?从哪入手风险最小?

您提的这个问题非常实际。对于中小企业来说,全面改造架构不现实,但完全可以采用 “由点及面、小步快跑” 的策略,从风险最低、见效最快的地方入手。

第一个推荐的入手点是 “虚拟化环境的资源审视”。如果您公司使用了VMware或类似平台,可以重点分析那些“僵尸虚拟机”或分配了远超出其所需内存的虚拟机。

很多测试机或老旧业务系统,常年只使用很低的内存,却占着很大的配额。通过调整这些虚拟机的内存配置(称为“内存回收”),往往能立即在不影响业务的情况下,为新应用腾出资源,推迟硬件采购。这正是内存分层技术要解决的问题的初级手动版-2。

第二个方向是 “数据库与缓存优化”。很多业务系统的性能瓶颈在于数据库查询。您可以利用监控工具,找出那些最高频、最消耗资源的SQL查询。通过增加数据库索引、优化查询语句,或者引入Redis等内存缓存来缓存热点数据,可以用更少的内存支撑更高的并发。这比单纯给数据库服务器加内存条更治本。

第三个低成本尝试是 “利用云服务的成本优化工具”。主流云厂商(如AWS、Azure、GCP)都提供了成本管理器和资源优化建议。这些工具会自动分析您云主机的CPU和内存使用率,并给出“下调实例规格”的建议。

例如,一台持续半年内存使用率从未超过40%的云主机,就非常适合降配。您可以先选择一两台非核心业务的机器,按照建议降配并观察一周,如果性能稳定,就能形成显著的月度成本节约。

问:我是一名学生,对AI开发很感兴趣。您提到“模型量化”可以大幅减少内存占用,这会不会让模型变得很“笨”,效果变差?在实际学习中该怎么使用它?

这是一个非常棒的、触及本质的问题。您的担心很有道理,但请放心,模型量化绝不是简单地让模型“变笨”,而更像是一种“信息的有损压缩”,目标是保留最关键的信息,舍弃对结果影响微乎其微的细节。

这就好比把一张高清照片(FP32)转换成一张高质量的网页图片(INT8),在肉眼看来几乎没区别,但文件体积小了很多-2。

在实际学习中,您可以这样开始接触和使用它:

首选从“后训练量化”开始。这是最简单的方式,您不需要重新训练模型。以PyTorch为例,使用其torch.quantization模块,您可以加载一个预训练好的模型(比如一个图像分类模型),然后准备几百张代表性的图片(校准数据集),让框架自动分析每一层对量化的敏感度,并生成一个INT8版本的模型。整个过程就像运行一个脚本,您可以立即对比原模型和量化模型在精度和速度上的差异,直观感受其效果。

明确应用场景。量化在模型推理阶段应用最广、最成熟。也就是说,当您的模型训练完成后,准备部署到手机、网页或边缘设备上运行时,量化是必不可少的步骤。著名的AI框架,如TensorFlow Lite、PyTorch Mobile,其核心优化之一就是量化。而在模型训练阶段,目前主流还是使用混合精度训练(结合FP16和FP32),直接使用INT8训练还属于前沿研究领域。

利用现成的强大工具库。对于当下热门的大语言模型,直接上手量化可能比较复杂。我强烈推荐您从 Hugging Face的 transformers 库搭配 bitsandbytes 库开始-2。bitsandbytes 实现了“4-bit量化”等先进技术,让您只需添加几行代码,就能将巨大的LLM以极低的内存占用加载到消费级显卡上运行,这对于个人学习和实验来说是革命性的。您可以在Colab等免费平台上,亲手体验量化如何让原本需要专业硬件才能跑起来的模型,变得“平易近人”。