打开电脑主机,拔下那根黑色长条,很多人不知道这个叫内存的东西,其实是由数百万个比头发丝还细的电容和晶体管组成的精密迷宫。

一个DRAM单元,说白了就是一个电容加一个晶体管。电容负责存电荷,有电荷代表“1”,没电荷就是“0”。而晶体管就是个电子开关,控制着充放电-1。

这种设计简单得让人惊讶,但正因如此,DRAM才能做得这么小、这么便宜,挤进我们每一个电子设备里。

DRAM内部的世界是个标准的二维网格。想象一下围棋棋盘,每个交叉点放着一个存储单元。横的叫“字线”,竖的叫“位线”,这就是寻址系统-1。

当你想要读取某个特定数据时,CPU会发送一组坐标:行地址和列地址。字线解码器收到行地址后,会激活整行单元。

这些被激活的单元通过位线连接到位线放大器上。放大器在这里扮演了关键角色,因为电容释放的电荷信号太微弱了,需要被放大才能识别-1。

有意思的是,读取DRAM的过程其实是个“破坏性”操作。读取完成后,原本存储的信息就消失了,所以系统必须马上把数据再写回去。这个过程叫做“刷新”。

DRAM为什么叫“动态”存储器?就是因为里面的电荷会慢慢漏掉,需要不断刷新才能保持数据,大约每64毫秒就得全面刷新一次-1。

DRAM的读写过程很像交响乐团的表演。字线解码器是指挥,位线放大器是乐手,而数据则像音符在总线上流动。

读操作时,位线放大器捕捉到微弱的电荷信号后,会将其放大并锁存。然后列地址解码器会从这一行数据中,精准挑出你需要的那一位-1。

写操作则相反,数据从内存控制器出发,沿着位线找到目标单元,然后给电容充电或放电。

这里有个技术细节值得注意:信号完整性对DRAM至关重要。写数据从控制器出发,经过主板、插槽、内存条,到达DRAM颗粒时已经衰减了。

所以读数据的幅度通常比写数据大,因为读数据直接从DRAM出来,还没经过那些路径衰减-6。

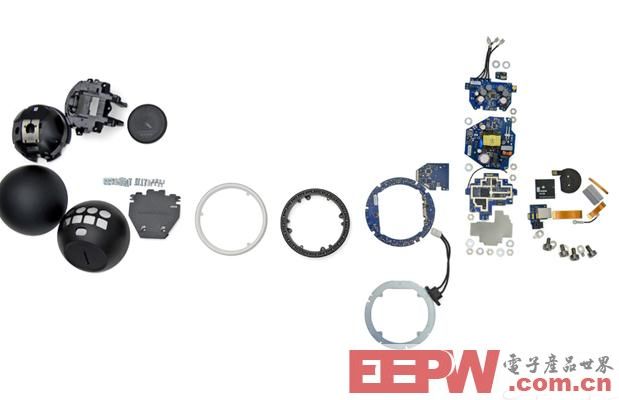

当一块DRAM出现问题时,工程师们就像医生给病人做手术一样,对它进行“解剖分析”。

传统的故障分析方法包括机械抛光、湿法化学蚀刻、等离子蚀刻和聚焦离子束铣削等-4。现在随着芯片封装技术的变化,背面分析方法也越来越流行。

尤其是倒装芯片和芯片引线封装的出现,再加上金属层数的增加,工程师们不得不从芯片背面下手-4。

这种情况下,主要的挑战就是移除大量的硅材料。完成这一步后,才能用各种显微技术观察芯片内部结构。

对于降级DRAM的利用,工程师们也有妙招。他们会在非易失性存储器中存储一个“可用DRAM地图”,记录哪些内存块是可用的-9。

这样处理器就能避开故障区域,只使用正常部分。这种方法大大提高了DRAM的利用率,降低了生产成本。

如今的DRAM市场,最热门的词是HBM(高带宽内存)。随着人工智能的爆发,HBM的需求直线上升。

据预测,HBM在DRAM市场的份额将从2023年的8%激增到2025年的33%-3。这背后是英伟达、亚马逊、谷歌和AMD等巨头的巨大需求,四家公司吃掉了95%的HBM需求-3。

在技术节点上,DRAM正在向更小的尺寸迈进。业内预测,到2027年底,DRAM将进入个位数纳米技术节点-8。

这意味着未来的DRAM芯片会更小、更节能、容量更大。我们可能会看到32Gb、48Gb甚至64Gb的单芯片-8。

3D堆叠是另一个重要方向。就像高楼大厦一样,DRAM也开始向上发展。垂直沟道晶体管单元、IGZO DRAM单元等技术正在研发中-8。

基于eDRAM的内存计算加速器正在崛起。韩国科学技术院的研究团队开发出了一种名为DynaPlasia的芯片,将计算逻辑直接集成在DRAM存储单元内-2。

这种设计能显著减少数据搬运,降低功耗,特别适合人工智能运算。相比传统的数字DRAM解决方案,吞吐量提高了约15倍-2。

内存分解技术也在数据中心得到应用。密歇根大学的研究人员开发了Infiniswap软件,能让服务器在内存不足时借用其他服务器的闲置内存-7。

虽然访问远程内存比本地慢,但比把数据交换到磁盘快多了。这项技术能将集群内存利用率提高达47%,节省高达27%的成本-7。

对于那些对性能要求不高的消费电子产品,降级DRAM的应用正在变得更加智能。不再需要预先分类和硬件跳线,系统可以自动检测可用内存块-9。

电脑内存条安静地躺在主板上,等待工程师的下一次“分解手术”。当HBM4内存开始普及,DDR5频率向8800MT/s迈进-3。

一位工程师调整显微镜焦点,聚焦离子束正在剥开又一片DRAM芯片的外衣,纳米尺度下的电容阵列在屏幕上闪烁,宛如夜空中微缩的都市灯火。