哎呦我去,最近搞机的老铁们有没有发现,内存圈子里又开始念叨什么“FBS”、“全缓冲”这些词儿了?尤其是那些搞服务器、搭数据中心的兄弟,更是被什么内存带宽、容量密度这些词儿搞得头晕眼花。今儿咱就唠点实在的,掰扯掰扯这个DRAM FBS(其实就是FB-DIMM,全缓冲内存模组)到底是个啥玩意儿,它咋就能让服务器“支棱”起来-1。

你想想看,早些年那服务器,内存要想扩容提升性能,路子比较野。传统招数是啥?就是让内存控制器那嘎达伸出来一大堆数据线,跟章鱼爪子似的,直接连到每一个DRAM内存条上-1。这招在速度要求不高的时候还行,可一旦你想把路拓宽(加带宽)或者让车跑更快(提速度),麻烦就来了。信号干扰得厉害,噼里啪啦的,不仅速度有天花板,能插的内存条数量也受限,容量根本上不去-1。这就好比一条老国道,车一多就堵死,想多跑车?没门!

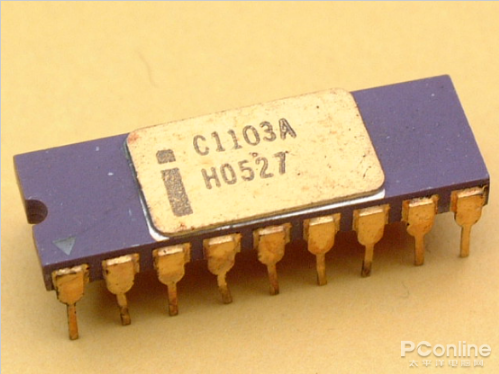

这时候,DRAM FBS 技术就闪亮登场了,它整了个非常巧活的思路。它不像以前那样“多头直连”,而是在内存控制器和内存条之间,安排了一个“交通总指挥”——一颗叫AMB(先进内存缓冲)的芯片-1-4。这个AMB可牛了,它跟内存控制器之间的通信,从以前的“并肩走”的并行大巴,改成了“排好队、一个接一个”的高速串行小队,有点像PCI-E总线那样干活-1-4。这么一整,好处大大滴:内存控制器不用再费劲巴拉地直接管理所有内存颗粒,线路简化了,信号纯净了,最关键的是,一条串行链路上可以挂上好多好多内存条!理论上去讲,能支持的内存容量和带宽那是蹭蹭往上涨啊-4。所以说,这DRAM FBS 首要解决的痛点,就是突破了传统架构下高带宽与高容量难以兼得的困境,给服务器海量数据吞吐铺了条高速公路-1。

不过咧,老话说得好,“甘蔗没有两头甜”。这DRAM FBS 方案这么厉害,代价是啥?第一个就是“发热”-4。多了一个AMB芯片当总调度,那功耗肯定比普通内存条要高,发热量不小。所以你看,只要是正经的FB-DIMM内存条,清一色都得穿上“马甲”——配上金属散热片,不然工作起来温度压不住-4。第二个就是“延迟”-1。数据从控制器出来,得经过AMB调度一下再分发,这个中转过程自然会引入一点点额外的时间延迟(Latency)。对于追求极致瞬时响应的某些应用场景,这算是个小缺憾吧-1。

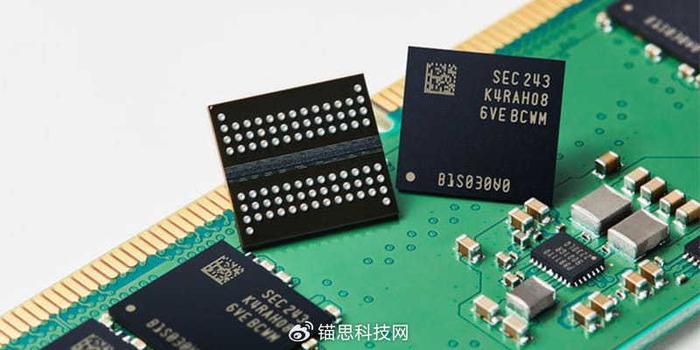

那有兄弟要问了,这技术听起来挺古早的,现在还有用吗?哎,这话可别说早了。你知道现在最火的是啥?AI!各种大模型、高性能计算(HPC)把服务器需求推得嗷嗷叫-3。根据一些行业分析,2026年AI服务器和传统数据中心的需求双重爆发,对内存的带宽、容量和稳定性要求达到了新高度-8。虽然现在最顶尖的AI服务器可能更追捧HBM(高带宽内存),但在更广泛的企业级服务器、高性能工作站领域,需要大容量、稳定可靠的内存方案,FB-DIMM的设计思想——通过缓冲和串行化来扩展通道能力——其内核逻辑并不过时。它代表了在特定历史阶段,为了解决内存墙问题的一种重要且成功的架构探索-9。

所以,咱们回头看DRAM FBS,它不仅仅是一个具体的内存条产品,更是一种解决系统级瓶颈的设计思路。它告诉我们,当直连遇到瓶颈时,通过引入“缓冲”和“串行化”这样的中间层来进行管理和调度,往往能打开新的局面。这种思路,在今天的芯片互连、异构计算里依然能看到影子。对于咱们搞技术、做运维的来说,了解它的好坏,才能真正理解服务器内存子系统演进背后的逻辑,下次再遇到选型或者调优,心里才不会发慌。

1. 网友“硬核装机佬”提问:

“看了文章,大概懂了FB-DIMM是靠AMB芯片串起来干活。但我好奇的是,这AMB芯片具体都干了哪些脏活累活?它难道就是个简单的数据中转站吗?”

答:

这位兄弟问到了点子上!这个AMB芯片,可不是个简单的“快递驿站”,它是个身兼数职的“超级管家”,干的活细得很。

首先,它干最核心的协议转换活。前面说了,内存控制器那边是串行指令,而DRAM颗粒认的是并行信号。AMB就负责在这两种语言之间做“同声传译”,把串行指令精准地翻译、分解成并行信号发给颗粒,反过来又把颗粒返回的并行数据打包成串行数据流发回去-1-9。这是它最基本也是最重要的功能。

它是个信号增强中继站。在高速信号传输中,衰减和失真不可避免。AMB芯片内置了强大的信号驱动器和接收器,能够对经过它的数据信号进行重整和加强,补偿长距离或多节点带来的信号损耗,确保命令和数据能准确无误地传递到链路上的每一个模组,甚至到链条末端还能保持信号质量-1。这就像在一条长水管上隔一段加个增压泵,保证水压始终够用。

再者,它还是个自主纠错工程师。AMB集成了高级的错误检查和纠正功能。它能实时监测数据传输的完整性,比如使用CRC(循环冗余校验)等技术-4。更厉害的是,部分高级的AMB还支持一种叫“位元通道容错移转校正”的能力-1。简单说,就是它能自动检测到哪一条物理数据通道出问题了,然后在线运行中就把这条坏路屏蔽掉,把数据导流到其他好路上,整个过程系统可能都感觉不到,大大提升了系统的可靠性和可维护性-1。

它实现了读写并发。因为所有读写操作都经过AMB缓冲调度,内存控制器可以更灵活地安排任务,在某些情况下可以实现读取和写入操作的同时进行,从而更充分地利用内存带宽-1。

所以,你看,这颗小小的AMB芯片,可谓是“麻雀虽小,五脏俱全”,它通过承担这些复杂任务,彻底把内存控制器解放了出来,让后者能专注于更高层次的调度,这才是FB-DIMM架构能实现高扩展性的根本所在。

2. 网友“迷茫的IT采购”提问:

“我们公司明年要扩容数据中心,正在做预算和选型。看到文章里说现在内存市场涨价很猛,也提到FB-DIMM这种技术。我想知道,在当前(2026年)的市场环境下,像FB-DIMM这类技术方案,还有实际的采购和应用价值吗?还是说已经是过时的东西了?”

答:

这位做采购的朋友,你的顾虑非常实际,是做预算时必须要考虑的核心问题。直接给结论:FB-DIMM作为一种具体产品形态,在全新的主流服务器采购中确实已不是首选,但其技术理念并未过时,且在某些特定场景和存量市场仍有价值。

首先,必须正视市场主流。当前和未来服务器内存的绝对主角是DDR4/DDR5,特别是支持纠错码的ECC内存和寄存式内存(RDIMM)。它们的性能、功耗和成本平衡性更好,得到了英特尔、AMD最新平台的原生支持。而像FB-DIMM这种需要特殊平台支持的技术,在新品市场中份额已经很小。

但是,这绝不等于它没有价值。你的应用场景是关键考量因素:

1. 存量系统扩容与维护:很多金融、电信等关键行业,其核心业务系统可能还运行在5年甚至更早前采购的(如英特尔至强E5/E7 v3/v4世代等)服务器上,这些平台设计之初就是基于FB-DIMM。对于这些系统,扩容和维护的唯一选择就是继续采购FB-DIMM内存。这是一个稳定的存量市场,虽然新条子可能因为产量小而不便宜,但对于保障业务连续性的价值而言,这笔投资是必要的。

2. 对最大内存容量有极端需求的特定场景:虽然DDR4/5的LRDIMM也能提供巨大容量,但FB-DIMM在其鼎盛时期,单系统支持384GB甚至更高容量的能力是令人印象深刻的-4。如果你有少数特殊的、需要海量内存(而非极致带宽)的历史应用或分析平台,且运行在旧架构上,那么基于FB-DIMM的系统可能仍是满足需求的最经济路径(无需彻底更换全新服务器集群)。

3. 理解其设计思想对当前采购的启示:现在为你采购新服务器时,虽然不买FB-DIMM,但它的核心教训——关注内存扩展性——非常重要。你需要仔细评估:新服务器平台每个CPU支持多少内存通道? 单条内存最大容量是多少? 满配下的总内存容量和带宽能否满足未来3-5年的业务增长? 避免再次陷入“内存墙”困境。

关于你提到的价格问题,2026年内存市场确实处于上行周期,主要受AI服务器争夺高端产能(如HBM)影响,导致通用服务器DRAM供应紧张、价格普涨-3-6。这种市场态势下,无论采购哪种内存,预算都应留足弹性。对于FB-DIMM这种“非标品”,其价格受通用市场波动影响相对较小,更多取决于具体的供需和渠道,需要你进行针对性的市场询价。

3. 网友“技术考古爱好者”提问:

“很有意思的技术史!从文章看,FB-DIMM可以搭配DDR2或DDR3芯片-4。我想知道,这种缓冲式架构,理论上能不能适配现在的DDR4甚至DDR5芯片?是什么限制了它的进一步发展?是技术本身的天花板,还是被更优的方案(比如串行内存总线)给替代了?”

答:

这位“考古”朋友,你这个问题非常有深度,直接问到了技术演进路线的十字路口。先说答案:从纯技术原理上讲,FB-DIMM的缓冲架构思想完全可以适配DDR4/DDR5,但它在与另一种更根本的架构变革——内存总线全面串行化——的竞争中,逐渐失去了优势。

首先,为什么说技术上可行?FB-DIMM的本质,是在并行DRAM核心和(当时的)并行内存控制器之间,插入一个串行缓冲层(AMB)作为适配和解耦-1-9。只要AMB芯片的设计跟上DRAM颗粒的IO速度和协议,它理论上可以为任何一代并行DRAM(包括DDR4、DDR5)提供这种缓冲和串行化服务。AMB甚至可以让内存控制器“感觉不到”后端的DRAM具体是DDR2还是DDR3-1,这种解耦特性是其灵活性的体现。

它为什么没有成为通往DDR4/DDR5的主流路径呢?主要是被以下几股合力“拍在了沙滩上”:

1. 功耗与成本之殇:这是FB-DIMM的“阿喀琉斯之踵”。AMB芯片本身功耗可观,导致内存条发热大,必须加装散热片,增加了成本和设计复杂度-4。到了DDR4时代,电压降低,本身就在追求更低功耗,FB-DIMM的功耗劣势被进一步放大。与此同时,替代方案成熟了。

2. “真·串行总线”方案的降维打击:FB-DIMM是在并行内存总线的框架内,通过“打补丁”(加AMB)的方式局部引入串行。而更彻底的革命,是将内存控制器与DRAM之间的物理接口本身也改为串行。这正是DDR5一个重要的发展方向。DDR5的DIMM引入了电源管理芯片(PMIC),同时其子通道划分、更高的带宽需求也在推动接口向更串行化、类似总线式的方向发展。这种“原生”的改进,比通过额外芯片“转接”更高效、功耗也更优。

3. 产业生态的转向:英特尔作为FB-DIMM的主要推手,在其后续的处理器架构(如从Nehalem到Skylake系列)中,将内存控制器更深度地集成进CPU,并优化了对DDR3/DDR4 RDIMM/LRDIMM的支持。这些标准模组通过寄存器(RCD)和数据缓冲(DB) 芯片也能实现类似的部分缓冲和扩展功能,但实现路径更简洁,与行业标准融合更好,形成了更强大的产业生态。最终,市场选择了这条路径。

所以,限制FB-DIMM发展的,不是它无法适配新技术,而是它作为一种“过渡性增强方案”的历史使命已经完成。它精彩地解决了DDR2/3时代高端服务器面临的容量与带宽矛盾-9,证明了串行化在内存子系统的巨大潜力。而它的精神遗产——缓冲、解耦、串行化——已经被后续技术(如DDR5的特性、以及更激进的串行内存接口研究)所吸收和超越。技术进化就是这样,一个灿烂的“解决方案”最终往往成为通向更优“架构”的垫脚石。