哎呀,说到现在的电子设备,大家是不是总觉得更新换代忒快了?手机、电脑,个个都喊着性能更强、功耗更低。但你知道不,在这些设备心脏——芯片——的内部,有些看似不起眼的小设计,却是决定性能和稳定性的关键。今天咱就唠唠这里头的一个核心角色:DRAM Pads(动态随机存取存储器焊盘)。你可别小看这些微小的金属接触点,它们就像是芯片内部繁忙都市的“交通枢纽”和“港口码头”,设计得好不好,直接关系到数据“货物”的进出速度与安全,搞不好就是设备卡顿、耗电快的元凶-1。

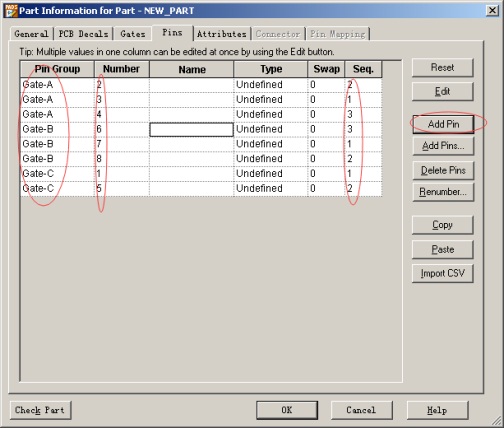

先来说说很多工程师头疼的第一个问题:芯片封装兼容性太差,导致设计成本飙升。你想啊,市面上芯片封装类型那么多,像WB BGA、eLQFP这些,各有各的玩法。传统的DRAM pads布局往往只盯死一种封装方式,好比修高铁只修一条线,别的车想上都上不来。结果呢?厂家想灵活应对不同客户的需求,就得为不同封装重新设计布局,这时间成本和金钱成本可就海了去了,最后还不是转嫁到咱们消费者头上?不过现在有新技术了,通过一种“内-中-外”三排焊盘的分组布局,让同一颗芯片能轻松适配不同的封装方案-1。这就相当于把原来的单行道扩建成了一个规划科学的多层立交桥系统,无论你是来自BGA封装还是eLQFP封装的“数据车辆”,都能找到合适的“匝道”快速接入,大大提升了设计的灵活性和性价比-1。

解决了“路”怎么修的问题,接下来更关键的是“路”的质量和安全性。这就是DRAM pads要面对的第二个核心痛点:数据漏电,导致存储的信息掉得快、不靠谱。尤其是在芯片工艺越来越精细的今天,晶体管小到纳米级别,内部结构娇贵得很。传统的连接方式,好比直接用一根很粗的管子捅到芯片最精细的活性区域去连接,很容易造成损伤,产生微小的“陷阱”和应力-6。这些损伤点就成了“漏电的闸门”,让DRAM电容里存着的电荷(也就是你的游戏进度、正在写的文档)悄悄溜走,表现出来就是数据保存时间缩短,设备为了保住数据不得不更频繁地刷新,结果就是耗电如流水,后台悄悄干活,电池顶不住-6。先进的DRAM pads设计在这里就扮演了“保护性接口”或“缓冲垫”的角色。它在杂质区和接触点之间加入了一个额外的垫层电极,让连接不再直接“粗暴”地接触最脆弱的活性区-6。这感觉就像在珍贵的古董家具上安装配件时,先垫上一层柔软的保护垫再操作,避免了直接刮伤。这样一来,结点漏电流被有效抑制,数据保持特性变得杠杠的,你的设备也就更省电、更稳定-6。

光芯片内部设计好了还不行,怎么把多个DRAM芯片高效又稳定地“打包”成一个模块,也是个技术活。这就引出了与DRAM pads位置相关的第三个痛点:封装内部走线过长,信号延迟和干扰大增。老式的模块封装,芯片的 bonding pads(键合焊盘)通常在芯片边缘,要连接到模块PCB板上的对应焊点,那根金线得飞老长老长-10。线一长,电阻就大,信号传输就慢,还容易产生各种电磁干扰,更糟的是,过长的线在封装过程中容易下垂碰到芯片边缘,造成短路,良品率都受影响-10。现在的解决方案思路很巧妙,叫做“板上芯片”技术。它把芯片倒着贴装在PCB板上,让芯片中央的DRAM pads直接对准PCB板上开好的窗口-10。这样一来,连接用的金线只需要垂直穿过这个很短的窗口距离就能焊上,路径从“跨海大桥”缩短成了“室内过道”,电阻和电感效应大大降低,信号质量提升的不是一星半点,最终模块的性能和可靠性自然就上去了-10。

所以说,别看DRAM pads只是芯片上微乎其微的一个组成部分,它的布局哲学和结构设计,实则贯穿了从芯片核心到系统封装的整个性能与可靠性链条。它默默解决了兼容性、数据完整性和信号完整性这些底层但至关重要的难题。下次当你觉得自己的设备又快又持久时,也许可以想到,这里面也有那些精心排布的微小焊盘的一份功劳。正是这些微观尺度上的持续创新,才托起了我们宏观数字体验的不断飞跃。

网友提问与回答

问题一(来自网友“硬核数码控”): 看了文章,对DRAM pads有点概念了。但我有个更具体的问题:现在芯片都追求小型化,那DRAM pads的布局设计是不是也面临极限挑战?比如在更小的面积里塞进更多焊盘,会不会反而带来新的信号串扰问题?工程师们是怎么平衡“密度”和“性能”这对矛盾的?

回答: 这位朋友,你这个问题问到点子上了,这绝对是当前芯片设计,尤其是高端DRAM和片上系统(SoC)设计中最前沿的挑战之一!确实,随着制程工艺从7纳米向5纳米、3纳米甚至更小迈进,芯片面积金贵无比,DRAM pads的布局就像在寸土寸金的市中心进行超级精密的城市规划。

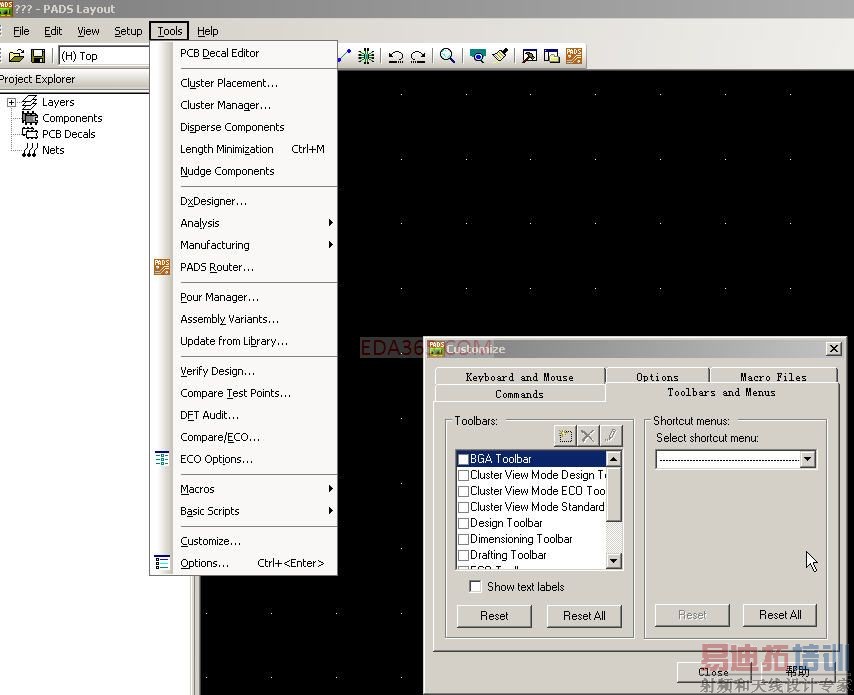

首先,你担心的信号串扰问题非常现实。当焊盘间距(Pitch)急剧缩小,高频率数据线之间靠得太近时,电磁耦合效应会变得极其显著,一条线上的信号跳变很容易“污染”相邻线路,导致数据误码。这就像是老式居民楼隔音太差,邻居家说话你听得一清二楚,没法专心。工程师们应对这一挑战,可不止一两招。第一招是 “空间隔离与屏蔽” 。这包括在关键的、高速的DRAM pads信号线之间插入专用的接地(GND)或电源(VDD)焊盘。这些固定的电位焊盘就像一堵堵“隔音墙”,能有效吸收和阻隔电场干扰。在更高级的设计中,还会采用差分信号对(如DDR内存中的DQS信号)布局,两根线传输反向信号,对外界干扰的抵抗能力更强,同时它们自身产生的磁场也能相互抵消,减少对邻居的影响。

第二招是 “材料与结构创新” 。这涉及到芯片制造的后段工艺(BEOL)。例如,采用更低介电常数(Low-k)甚至超低介电常数(Ultra Low-k)的绝缘材料填充在焊盘引线之间,可以降低线间电容,从而减少通过电场耦合的能量。三维集成电路(3D-IC)和硅通孔(TSV)技术提供了一种革命性的思路:与其在二维平面上死磕,不如把内存堆叠在处理器上方,通过垂直的TSV进行连接。这样,DRAM pads可以设计得更大、间距更宽松,而垂直连接的路径极短,串扰和延迟问题得到根本性缓解,这算是从“平房拥挤小区”升级到了“摩天大楼立体社区”。

第三招是 “电路设计与编码策略” 。在系统层面,采用更先进的信号均衡技术、前向纠错编码等,可以让系统容忍一定程度的信号质量下降。同时,通过精心设计焊盘的驱动强度和接收器的灵敏度,在确保信号完整性的前提下,找到功耗与抗干扰能力的最佳平衡点。所以,平衡密度与性能,绝非简单妥协,而是一场在物理、材料、电路和架构多个维度同时进行的精密协同优化。工程师们的工具箱远比我们想象的丰富,目标就是在微观世界里,既建起“超高层建筑”,又要保证每家每户的通讯清晰、私密且低功耗。

问题二(来自网友“想装机的老王”): 很技术,但对我们普通装机用户有啥实际影响?我选内存条、固态硬盘的时候,会看到不同颗粒(比如三星B-die、海力士CJR),这些顶级颗粒的好,跟它们内部DRAM pads的设计水平有关系吗?我该怎么通过实际产品参数看出来?

回答: 王哥这个问题特别接地气,从技术落地到了咱们真金白银的消费选择。直接说结论:有非常直接且重要的关系! 那些口碑好的顶级内存颗粒(如三星B-die)和高端固态硬盘上的缓存颗粒,其优异的超频潜力、高频率下的稳定性和低延迟表现,一部分正源于芯片内部优秀的电路设计,而DRAM pads作为连接存储阵列与外部世界的咽喉要道,其设计水平是关键一环。

它对用户体验的影响主要体现在两个你能直接感受到的参数上:频率(频率)和时序(Timing)。优秀的DRAM pads设计,通过降低连接电阻、优化信号路径、减少串扰,首先为芯片在高频率下稳定工作打下了物理基础。这就好比一条更宽、更平直、干扰更少的高速公路,能让车辆(数据)以更高的速度(频率)安全通行。它有助于实现更低的时序(CL、tRCD、tRP等)。时序可以理解为数据响应指令的“反应时间”。更干净、更快速的信号传输,意味着从发出指令到数据就位所需的周期数可以更少,延迟更低。这就是为什么顶级颗粒往往能在同样电压下,达成“更高频率+更低时序”这种鱼与熊掌兼得的梦幻组合,其内部信号完整性(包括pads设计)功不可没。

那我们普通用户怎么从产品参数窥见一二呢?虽然厂商不会直接标明“本产品采用先进DRAM pads设计”,但我们可以通过以下几个指标间接判断:

标的频率与时序:同样代际(如DDR4)的产品,标称频率极高(如DDR4-4400+)且时序相对较紧(如CL17以下)的型号,通常对颗粒的内部素质要求极高,背后往往需要优秀的设计支撑。

电压与超频空间:在较低的工作电压(如DDR4的1.35V)下就能稳定运行在高频的颗粒,通常意味着其内部功耗控制和信号完整性更好,漏电更低(这与我们前面提到的pads减少漏电的作用相关),素质更佳。

品牌与系列口碑:像三星的B-die、海力士的DJR/MJR、美光的E-die等,经过大量发烧友的实践验证,形成了公认的“超频体质”口碑。选择搭载这些公认优秀颗粒的内存条或高端SSD,本质上就是选择了其内部包括DRAM pads在内的整套成熟、先进的设计方案。

所以,下次装机研究内存时,别看那些参数枯燥,它们背后正是像DRAM pads这样的微观设计在“暗暗较劲”。选择口碑好的顶级颗粒,就是为你平台的性能与稳定性,打下了一个看不见的、却无比扎实的基础。

问题三(来自网友“好奇小白”): 文章里提到“板上芯片”让金线变短提升了性能。但现在不都流行说“先进封装”吗,像什么2.5D、3D封装、硅光互联这些。在这些更炫酷的技术里,传统的DRAM pads和金线连接是不是就要被淘汰了?未来会变成什么样?

回答: 小白同学眼光很前瞻!你这个问题触及了半导体行业发展的一个核心趋势:从二维平面互联走向三维立体集成,从电互联走向更高效的互联方式。传统的DRAM pads加金线键合(Wire Bonding)的方式,在可见的未来不会完全被淘汰,因为它技术成熟、成本极低,在大量对性能要求不极致的消费级、工控级产品中仍是主流。但在追求极致性能、能效和集成度的前沿领域,它确实正在被一系列更“炫酷”的技术所补充和取代。

未来的图景可能是多层次、多技术并存的:

2.5D/3D封装成为高性能核心:这正是解决“内存墙”(处理器与内存之间的速度瓶颈)的钥匙。在2.5D封装中,DRAM芯片和处理器并排放在一个硅中介层(Interposer)上,中介层内部有密密麻麻的微凸块(Microbump)和再布线层(RDL)进行高速互连,这完全取代了长金线,距离短、带宽巨大。在3D封装中,DRAM芯片直接堆叠在处理器芯片上方,通过硅通孔(TSV) 垂直连通。此时,芯片表面的DRAM pads演变成了与TSV对接的微型焊球或铜柱,实现了芯片间的“垂直电梯式”通信,距离缩短到毫米甚至微米级,带宽和能效提升是数量级的。在这里,传统金线彻底消失。

混合键合(Hybrid Bonding)引领未来:这是比TSV更激进的技术。它通过铜-铜直接键合,将两层芯片的金属层(包括经过改良的pad结构)在原子级别上连接起来,互联密度和带宽可以做到极致,是未来HBM(高带宽内存)等技术的演进方向。

新型互联技术探索:至于硅光互联,目前主要着眼于更长距离(如芯片到芯片、板卡到板卡)的数据中心内部通信。在单个封装内部,短期内仍以电互联为主。但一些研究已经在探索在硅中介层或芯片内部集成微型光引擎,实现超高速光互连的可能性,那将是另一个维度的革命。

所以,总结一下:传统的DRAM pads和金线连接在“平民”市场依然有其位置。但在“精英”和“未来”赛场,它正迅速演变为更精细的微凸块、TSV接口、混合键合面等形态。未来的DRAM pads,可能不再是我们熟悉的二维平面上的金属块,而是三维空间中的立体互联节点,其设计将更加复杂,需要与热管理、应力控制等议题深度融合。它所承载的使命,依然是那个最古老的:如何更快、更稳、更高效地传递信息,只是舞台从平面变成了立体宇宙。