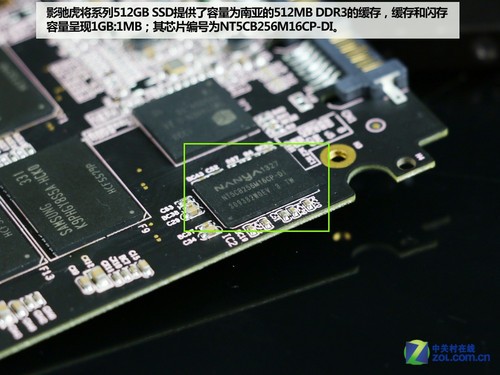

哎呀,我说各位朋友,你们有没有遇到过这种状况:电脑配置看着不赖,可一开大软件或者游戏加载场景,就总觉得差那么一口气,有点“卡脖儿”?很多时候,这个锅可能真不在CPU慢,也不全怪显卡弱,问题说不定就出在内存数据的调度上,也就是咱们今天要唠的DRAM缓存那点事儿-1。你可别一听“缓存”就觉得必须是CPU里头那几MB的SRAM,实际上,通过巧妙的系统设计,DRAM缓存扮演着连接超高速CPU核心和慢速大容量存储之间的关键桥梁,它的整理和优化,直接决定了你机器跑的顺不顺-6。

咱们得先弄明白个底儿。传统上,CPU自家用的小仓库(L1/L2/L3缓存)确实都是SRAM建的,因为它速度快的像闪电(访问延迟就几纳秒)-1。但SRAM有个毛病,它“占地儿”大、成本高,所以容量做不大。这时候,速度稍慢但成本低、容量能轻松做到GB级别的DRAM就来帮忙了。不过,直接让DRAM干CPU缓存的精细活,它有点力不从心,因为它有个“坏习惯”:需要定时刷新数据以防丢失,这就带来了额外的延迟和功耗-1。所以,工程师们的智慧就体现在了“间接参与”和“系统级”设计上。

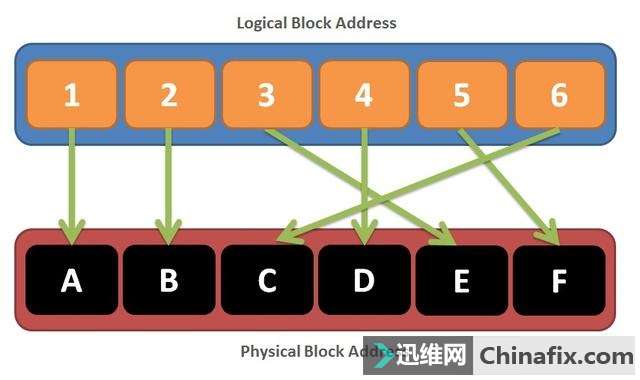

一种高级玩法叫“内存侧缓存”。你可以把它理解成在内存控制器和硬盘(或网络)之间,又搭了个棚子。这个棚子(也就是用一部分DRAM做的缓存)专门存放那些最可能被重复访问的数据-1。比如你打游戏,地图资源从SSD读到这个棚子里,下次再需要时就不用去遥远的SSD找了,速度自然快上一大截。这就是DRAM缓存整理的核心思路之一:在正确的层级,用对的容量,预存对的数据,解决数据传输的瓶颈痛点-4。

但光是搭个棚子还不够,怎么管理这个棚子里的货物更关键。这就得提到些让人眼前一亮的新技术了。比如学术界提出的FASA-DRAM,它的思路特别“聪明”。传统DRAM缓存有个矛盾:把数据从慢速区提升到缓存区(激活),和之后把数据写回原处(恢复),这两个步骤绑在一起,很耗时。FASA-DRAM来了个“分两步走”:第一步,先“破坏性”地把数据快速提升到缓存里用起来,甭管原地方了;第二步,等DRAM银行空闲的时候,再偷偷地把数据恢复回去-4。这就好比你先从仓库大货堆里紧急抽一箱零件到工作台(缓存)上用,等手头不忙了,再回头去整理仓库的库存记录。这套“破坏性激活+延迟恢复”组合拳,据说能平均提升近20%的性能,还更省电-4。瞧,这就是通过算法整理DRAM缓存的威力,直接切中了多核时代数据访问混乱、延迟高的痛点。

再往底层看,DRAM自身的“体质”也在被不断整理和优化。像华邦电子为边缘AI推出的CUBE高带宽内存,用的是3D堆叠和硅通孔(TSV)这些黑科技-5-8。这相当于把原本平铺的存储单元,摞成了摩天大楼,同时用垂直的微型电梯(TSV)连接各层,极大增加了数据进出的通道。带宽能做到256GB/s甚至更高,延迟和功耗还猛降-8。这种“体质”增强,使得它作为AI芯片的专用大容量DRAM缓存时,处理视频、语音这些流数据简直如虎添翼,解决了边缘设备对实时性和能效的双重苛刻痛点-5。

所以说,DRAM缓存的整理,是一门从硬件结构、电路设计、到系统架构、管理算法的综合学问。它不再是“能不能用”的问题,而是“怎么用得更巧、更高效”的进阶比拼。整理得好,你的数据通道就从乡间小道变成了立体高速,电脑反应快、能耗低,用起来那叫一个爽利。

1. 网友“好奇的芯片小白”问:大佬讲得好详细!但还有个基础问题懵懵的,CPU自己有SRAM缓存,系统又有DRAM当内存,现在还说DRAM也能当缓存,它们仨到底是个啥关系?能不能再打个接地气的比方?

答:嘿,这问题问得特别到点子上!好多人都绕不清。咱打个比方你就明白了:想象你是个大厨(CPU),正在厨房(计算机系统)炒菜。

SRAM缓存(L1/L2/L3):就是你手边、灶台边上那几个小碗。里面放着你正在用的油盐酱醋、切好的葱姜蒜(当前活跃数据)。你一伸手(CPU访问)就能拿到,速度极快。但地方小,放不了太多东西-1。

DRAM主内存:就是你身后的大操作台和一堆备料盆。上面摆着你今天这顿饭可能用到的所有食材(运行中的程序和数据)。你转身(访问内存)去拿,比伸手到碗里慢点,但比去仓库快多了。容量很大,够你折腾一顿大餐-3。

DRAM缓存(内存侧缓存/片上缓存):它呢,有点像是一个智能的备菜小助手。这个助手会盯着你的做菜习惯(数据访问模式),它提前从远处的大冰箱(硬盘或网络)里,把你接下来最可能用到的那几样食材(热点数据),比如你常做的招牌菜的调料,拿到操作台(DRAM缓存)上一个特定的、离你更近的预备区放着-1-6。这样当你突然需要时,就不用停下炒锅,跑远去开大冰箱了,直接从小助手的预备区拿,速度比从操作台其他地方找可能还快一点。

所以,DRAM缓存整理,其实就是优化这个“智能小助手”的算法:让它预测更准、备菜更快、占地方更省,最终让你这个大厨炒菜全程无缝衔接,出菜效率嗷嗷叫-4-10。

2. 网友“追求极致帧率”问:我是搞电竞的,对延迟敏感到极致。您提到那些像FASA-DRAM、3D堆叠的新技术,听着很牛,但它们什么时候能实打实地用到我们消费级的电脑或游戏主机上?现在我能通过设置或者买特定硬件体验到类似的优化吗?

答:老哥,你这问题非常实在,从实验室到你的电竞椅确实有段路要走,但曙光已经看见了,而且现在就有能“沾边”的体验法子。

关于新技术落地:像FASA-DRAM这类从学术论文里走出来的架构优化,是解决根本性瓶颈的思路。它们要进入消费级产品,需要芯片设计巨头(比如英特尔、AMD)在设计和验证后,集成到未来的内存控制器或CPU架构中。这个周期通常以“代际”(几年)来计算。不过,其核心思想——“减少不必要的等待和数据搬运”——正是行业持续努力的方向-4。而3D堆叠DRAM(如HBM)目前主要用在顶级显卡、AI计算卡上,因为它成本高。但像前面提到的CUBE这类面向边缘计算、成本优化过的3D堆叠方案,正试图把高带宽、低延迟的特性带入更广的市场-5-8。未来几代游戏主机和高端PC,很有希望采用这类技术来突破数据吞吐瓶颈。

关于现在就能做的:虽然不能直接控制DRAM缓存算法,但你可以通过选择和配置硬件,间接优化整个内存子系统,原理是相通的:

选对内存条:高频率、低时序(CL值)的DDR4/DDR5内存,本身就意味着更短的基础延迟和更快的数据传输率-2。这相当于拓宽了“操作台”(主内存)到“灶台”(CPU)之间的通道并减少排队时间。

利用好预取:在主板BIOS里,确保启用内存相关的预取(Prefetcher)技术(如英特尔MLC Streamer等)。这就是硬件级别的“智能小助手”,会根据你的数据流模式提前把数据从内存读到CPU缓存里-1。

关注平台特性:选择支持“显存智取”(如AMD SAM/Resizable BAR)或“直接存储”(DirectStorage)技术的平台。这些技术可以部分绕过传统慢速路径,让CPU或GPU更直接、更高效地访问显存或NVMe SSD里的数据,本质上也属于系统级缓存访问的优化,能显著提升游戏加载和场景流式传输速度,减少卡顿。

3. 网友“技术前瞻爱好者”问:看得热血沸腾!从您讲的Die-Stacked DRAM混合模式(部分当内存、部分当缓存)-6,到扇区DRAM的细粒度访问-7,感觉DRAM缓存的设计越来越精细复杂了。您觉得再往下发展,最大的挑战和趋势会是啥?会不会有一天SRAM缓存被完全替代?

答:这位朋友眼光很前瞻!行业确实在朝更“精细”和“智能”的方向狂奔,但挑战也随之而来,而SRAM的角色短期内很难被完全取代。

未来挑战与趋势:

“贵”与“热”的挑战:更先进的3D堆叠、更宽的通道,意味着芯片设计和封装成本飙升,散热压力也剧增-8。未来的趋势必须是 “能效比” 的极致优化,即每焦耳能量能搬运和处理多少有效数据。像扇区DRAM只激活和传输缓存块里真正有用的那部分数据,就是对抗“能源浪费”的典型思路-7。

“智能”管理的挑战:缓存容量越大、层级越复杂,管理策略就越关键。未来的DRAM缓存控制器必须更加“聪明”,能动态学习不同应用(游戏、AI推理、数据库)的数据访问模式,甚至能根据工作负载实时调整缓存分配策略(是更多用作直接映射内存,还是用作灵活缓存)-6-10。硬件与操作系统的协同也会更深。

“粒度”与“效率”的平衡:越细粒度的访问(如扇区DRAM)越能减少浪费,但管理元数据(标签)的开销也越大-7-10。未来的趋势是发展低开销的细粒度访问方案,以及像MemCache-6那样的混合设计,对稳定热点数据用粗粒度直接访问(免标签检查),对临时数据用细粒度缓存,达到效率最优。

SRAM会被替代吗? 至少在未来可预见的时间内,不会。SRAM无与伦比的速度(与CPU同周期)和无需刷新的特性,决定了它仍是CPU核心“贴身匕首”的不二之选-1。未来的图景更像是 “SRAM守内,DRAM缓存拓外” 的协作格局。SRAM继续负责L1/L2这类极致速度的缓存,而更高级、容量更大的DRAM缓存(可能是3D堆叠在CPU芯片上或旁边的)则负责管理更庞大的数据集,作为主内存的强大前哨-6-9。它们各司其职,共同把数据的“高速公路网”修建得又宽又智能,确保算力不会堵在路上。