黄仁勋在CES展台上对着媒体镜头,坦言SRAM速度快但容量瓶颈难以突破时,芯片设计者们正在实验室里尝试把DRAM的密度和SRAM的速度结合成一种全新解决方案。

今年初的CES展会上,当英伟达CEO被问及是否会用SRAM全面替代HBM时,他坦言SRAM虽然在某些工作负载下速度快得惊人,但容量瓶颈让它在生产级AI系统中优势尽失-7。

AI芯片架构正经历一场静悄悄的革命,2025年底,英伟达斥资约200亿美元取得Groq语言处理单元技术授权,标志着一个关键转折点的到来-1。

走进今天的AI芯片世界,你会发现内存技术正在重新划分势力范围。传统的动态随机存取存储器(DRAM)和静态随机存取存储器(SRAM)正在寻找各自的新定位。

SRAM凭借低于1纳秒的超低延迟,正在成为2026年AI推理优化的核心力量-2。这种速度优势源于它无需像DRAM那样周期性刷新数据,只要保持通电,存储的数据就能恒常保持-6。

Groq公司的语言处理单元单颗芯片就整合了高达230MB的SRAM,内存带宽达到惊人的80TB/s,成功绕过了传统DRAM与外部内存的带宽瓶颈-1。

在边缘设备领域,SRAM的优势更加明显。联发科的天玑9500手机芯片采用存算一体架构,通过SRAM实现了AI模型常驻运行,用户能享受到“Always-On”的持续体验-1。

说到这里你可能会想,SRAM跑得这么快,那它的“住房条件”怎么样?答案有点让人意外:同样面积的硅片,DRAM能提供更大的存储容量-6。

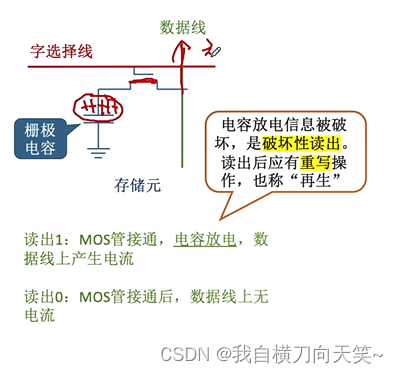

SRAM每个存储单元需要4到6个晶体管,而DRAM只需1个晶体管加1个小电容-6。这意味着在芯片房地产同等的情况下,DRAM能“住”下更多数据。

这种集成度差异直接影响了成本。SRAM的高昂价格一直是它无法大规模替代DRAM的主要原因之一-6。在传统观念中,SRAM的集成度确实无法与DRAM相比。

但技术发展正在改写这一认知。2020年的一项研究展示了一款3D堆叠SRAM,通过垂直堆叠8个SRAM芯片,数据密度达到每立方毫米12.3MB,甚至超越了当时最先进的堆叠DRAM-4。

当平面扩展遇到物理极限时,工程师们开始向立体空间要效益。半导体行业正在见证从2D到3D的思维转变。

平面微缩技术对SRAM和DRAM来说都已经走到尽头-5。无论怎样努力,每字节成本已经停滞了十余年,这是服务器规模扩大后DRAM成本占据系统主导地位的原因。

三维堆叠技术打开了新局面。通过将多个存储芯片垂直堆叠,并使用硅通孔等技术连接,可以在不增加芯片面积的情况下大幅提升容量和带宽-5。

这种3D集成技术正在模糊SRAM和DRAM的界限。HBM通过3D堆叠实现了超高带宽,而SRAM也可以通过类似技术突破传统集成度限制-2。

AI工作负载的多样性让内存选择变得更加复杂。没有一种内存能适合所有场景,灵活性和针对性成为关键考量。

黄仁勋指出,现代AI模型形态各异,对硬件的需求点也不同-7。有的模型依赖内存容量,有的则更看重互联带宽。如果硬件针对某一模式过度优化,一旦工作负载变化,昂贵的芯片就会闲置。

这种不可预测性让英伟达坚持选择HBM路线-7。虽然HBM方案物料成本更高,但它能适应不断变化的算法和模型架构,确保硬件在数周甚至数月的运营周期内保持高利用率。

在AI训练领域,HBM继续主导,提供极致带宽;而在推理端,SRAM凭借超低延迟成为优化核心-2。2026年,我们正看到AI重心从训练转向推理,SRAM与HBM将并驾齐驱的新格局-2。

面对SRAM和DRAM各自的优缺点,科学家们开始思考:为什么不创造一种结合两者优势的新型存储器呢?

斯坦福大学的研究团队正在开发混合增益单元内存,结合了DRAM的高密度和SRAM的高速度-9。他们通过将硅读取晶体管与氧化铟锡写入晶体管结合,制造出性能更好的混合存储器。

这种混合存储器能保持数据超过5000秒,而普通DRAM必须每64毫秒刷新一次-9。同时,它比类似的氧化物-氧化物增益单元快约50倍,真正实现了两全其美。

该研究获得了美国国防部1630万美元的资助,是加州-太平洋-西北AI硬件中心项目的一部分-9。团队负责人H.-S. Philip Wong教授比喻说,这就像从3挡自行车变成20挡自行车,为计算机设计提供更多选择-9。

芯片巨头们仍在各自路线上加注。台积电的CoWoS封装产能预计在2026年达到每月10万片,同时代工HBM4逻辑晶粒与高密度SRAM-2。

三星、SK海力士与美光则计划扩大DRAM生产,应对未来几年需求,但TrendForce预计2026年DRAM市场仍将供不应求-8。

当工程师们在三维空间中堆叠存储芯片时,一种结合DRAM密度与SRAM速度的混合增益单元内存正在斯坦福实验室里成型,它可能最终打破这场持续数十年的存储之争-9。

网友互动问答网友“芯片爱好者”提问: 看了文章很受启发,但有个实际问题:如果SRAM集成度真的提高了,我们普通消费者买手机、电脑会更便宜吗?还是反而更贵?

答: 这个问题很实际!从短期看,采用更多SRAM的设备可能不会更便宜。SRAM的生产成本目前仍高于DRAM,因为同样面积的硅片上能制造的SRAM容量较小-6。比如现在一些高端手机芯片增加SRAM用量来提升AI性能,这些成本很可能转嫁给消费者。

但中长期来看,情况可能发生变化。随着3D堆叠技术的成熟,SRAM的“立体集成度”正在提高-4。像台积电这样的代工厂正在提升先进封装产能-2,大规模生产有助于降低成本。更重要的是,SRAM的高性能可能减少对其他昂贵元件的依赖。

例如,联发科天玑9500芯片采用存算一体架构,用SRAM实现AI模型常驻-1,这可能会降低对独立AI芯片的需求。从系统总成本看,也许反而更经济。

不过黄仁勋也指出,SRAM的容量增长仍跟不上现代AI模型的需求-7。所以未来的设备可能会采用更智能的内存组合策略,而不是简单替换。消费者最终得到的是更高效、更适合AI时代的产品,价格则取决于多种因素平衡。

网友“科技观察者”提问: 文章提到SRAM和DRAM的2D缩放都到尽头了-5,这是否意味着摩尔定律在内存领域真的失效了?接下来内存技术要靠什么发展?

答: 这个问题触及了半导体行业的核心挑战。的确,传统意义上的2D缩放对SRAM和DRAM都已接近物理极限-5。DRAM的每字节成本十余年来基本停滞不前,SRAM也面临类似瓶颈。

摩尔定律在内存领域正在以不同形式延续。首先是3D化,就像文章提到的3D堆叠SRAM-4和HBM技术-2。通过垂直堆叠,可以在不缩小晶体管的情况下增加密度。台积电的CoWoS封装技术就是典型代表-2。

其次是新材料和新结构。斯坦福大学研究的混合增益单元内存就是一个例子,它结合了不同材料的优势-9。还有像氧化铟锡这样的新型半导体材料可能带来突破。

第三是架构创新。存算一体架构让SRAM不再只是存储单元,还能参与计算-1。这种“靠近计算”的设计减少了数据搬运,提升了整体效率。

最后是系统级优化。通过软件硬件协同设计,更智能地管理数据在不同类型内存间的流动,最大化利用每种内存的优势-5。

所以摩尔定律没有完全失效,而是演化成了多维度的创新。内存技术的未来不再仅仅依靠制程微缩,而是制程、材料、架构和封装技术的共同进步。

网友“硬件工程师”提问: 我在做嵌入式系统设计,经常要在SRAM和DRAM之间做选择。在AIoT时代,边缘设备到底应该怎么平衡这两种内存的使用?有什么实用建议吗?

答: 作为同行,我完全理解这种设计权衡的挑战。在AIoT边缘设备中,内存选择需要综合考虑性能、功耗、成本和空间。

对于实时性要求高的AI推理任务,可以考虑采用SRAM主导的设计。像联发科在天玑9500中做的那样,使用存算一体架构让SRAM既存储又计算-1,这对语音唤醒、图像识别等常驻AI功能很有效。SRAM的静态特性适合低功耗场景,只要保持通电就能保留数据-6。

但对于需要存储大量数据或模型的应用,DRAM仍是必要选择。可以考虑分层存储策略:将频繁访问的数据放在SRAM,不常用的放在DRAM-5。这种设计需要精细的数据管理算法。

功耗管理也很关键。SRAM在频繁访问时功耗可能比DRAM还大-6,而DRAM需要定期刷新。根据设备的工作模式动态调整内存使用策略可以节省能耗。

成本控制方面,不必盲目追求全SRAM设计。黄仁勋指出,SRAM容量有限,模型一旦溢出SRAM,系统效率优势就会消失-7。合理搭配才是关键。

密切关注新型混合内存技术的发展-9,未来可能会有更好的选择。同时利用好芯片提供的各种低功耗模式,在性能和能耗间找到最佳平衡点。