哎呀,不知道你发现了没,现在咱们用的手机、电脑,性能是越来越猛,但有时候处理大任务或者玩大型游戏,还是会觉得“差一口气”——数据好像在处理器和内存之间“堵车”了。这背后的老大难问题,就是业界常说的“内存墙”:处理器算得飞快,但数据从内存里搬进搬出的速度,却成了拖后腿的瓶颈-6。这不,科学家和工程师们琢磨出了一个“治堵”的高招:集成DRAM。简单说,就是别再让内存和处理器“分居两地”了,干脆把它们做到同一块芯片上,变成“一家人”。这可不是简单的物理搬家,它带来的变化,那可真是天翻地覆。

你想啊,传统上内存条是插在主板上的,数据得通过长长的电路板走线跑来跑去,速度慢、耗电还高。而一旦把DRAM和逻辑计算单元集成到同一芯片里,情况就大不相同了。距离缩短到了微米级别,通讯的“高速公路”(片上I/O线路)可以修得又宽又多,数据吞吐量瞬间飙升,而传输所需的能耗却大幅降低-1-3。有研究就指出,对于某些图形处理系统,集成DRAM的方案能惊人地将所需芯片数量减少到原来的1/12,而I/O功耗更是能降到原来的1/10-1。这就好比把两个需要频繁沟通的部门,从隔着一栋楼办公换到了同一个大开间,效率能不高吗?

所以,你别看集成DRAM这个词儿听起来挺技术范儿,它其实正悄悄解决着你我日常体验中的核心痛点:卡顿和耗电。尤其是在那些需要实时处理海量数据的场景里,比如手机拍摄超高清视频、玩大型3D游戏,或者AI进行人脸识别时,它的优势就更明显了。数据不必再经历“长途跋涉”,在“家门口”就能被迅速处理掉,流畅度和能效比自然就上去了-8。

说到这儿,就不得不提当前最火热的AI浪潮了。这波浪潮对集成DRAM技术来说,既是“超级考官”,也是“最强推手”。像HBM(高带宽内存)这种高级形式的集成DRAM,已经成为AI芯片的“标配”内存,需求量呈爆炸式增长-4。市场预测显示,到2026年,HBM在整体DRAM销售额中的占比将飙升至41%-4。为啥AI如此偏爱它?因为训练大模型就像是在干涸的算力沙漠里搞建设,数据是水,而集成DRAM打造出的高速、宽带宽通道,就是引水入漠的“超级管道”。没有它,再强大的AI算力芯片也如同巧妇难为无米之炊。

当然啦,把DRAM和逻辑电路“撮合”到一块儿,技术挑战也不小。比如,如何在不显著增加芯片成本和复杂度的前提下,整合进足够容量的内存?如何在提升带宽的同时,管理好发热和功耗?但道高一尺魔高一丈,创新的解决方案也在不断涌现。例如,有研究通过创新的三维堆叠集成技术,将新型的IGZO DRAM与底层硅电路结合,成功实现了超低延迟(<10纳秒)和超低能耗的数据传输,这为未来打破存储瓶颈开辟了一条新路-10。这些前沿探索,正一步步让集成DRAM从特定的高性能领域,走向更广阔的应用天地。

总而言之,集成DRAM绝非一个冰冷的技术术语。它是应对“内存墙”困境的一记重拳,是释放算力潜力的关键钥匙,更是我们未来享受更流畅、更智能、更节能数字生活的底层保障。从你的智能手机到云端的数据中心,它的身影将无处不在,默默支撑起那个我们越来越依赖的、高速运转的数字世界。

1. 网友“好奇宝宝”提问:

博主讲得挺生动!但我还是有点迷糊,集成DRAM和我们现在电脑里插的内存条(比如DDR5)到底有啥本质区别?它是不是以后要彻底取代内存条啊?

答:

嘿,“好奇宝宝”这个问题问得特别到位,可以说是问到根子上了!它俩啊,最本质的区别就四个字:“距离”和“位置”。

你可以把你电脑里的DDR5内存条,想象成一个超级大的、但离CPU有点远的“共享仓库”。CPU(处理器)这个“加工车间”需要原料(数据)时,得派车(通过主板上的电路)跑到仓库去取,路虽修得不错(DDR5带宽也在提升),但毕竟有物理距离,一来一回就有延迟,还费油(耗电)。

而集成DRAM呢,则是直接在“CPU加工车间”的旁边,甚至内部,搭建了一个专属的、小型的“高速缓存仓库”-5。取用数据的距离从“厘米级”缩短到了“毫米甚至微米级”,而且通道极宽(片上互连),所以速度极快、能耗极低-1。

那它会彻底取代内存条吗?我的看法是:不会完全取代,而是会形成一种“分工协作”的新格局。未来的个人电脑和服务器,很可能是一种“混合架构”:芯片内部集成一小块高速、低容量的集成DRAM(或类似HBM的封装内内存),用于存放CPU最急需、最常访问的“热数据”;而主板上的大容量DDR内存条,则作为“主仓库”,存放所有的“冷数据”和大型工作集-6。

这就好比,一个高级主厨不会把所有食材都堆在灶台边(地方不够),而是在手边(集成DRAM)放最常用、最关键的油盐酱醋和正在处理的食材,而更大的冰柜和货架(DDR内存条)则放在厨房里稍远的位置。两者配合,才能实现最高效的运作。所以,未来我们很可能看到的是“集成DRAM+HBM+传统内存条”多种内存形态共存的局面,各自发挥优势-4-6。

2. 网友“硬件DIY爱好者”提问:

感谢科普!从市场新闻里总看到HBM、AI芯片这些高端货在用集成内存。那对我们普通消费者来说,这东西到底啥时候能实惠地用到咱们的手机和家用电脑上?到时候体验会有啥肉眼可见的提升?

答:

“硬件DIY爱好者”你好!你这个问题非常实际,关系到咱们每个普通用户的切身体验。首先说时间表,我认为集成DRAM技术以某种形式“下沉”到消费级设备,其实已经在路上,并且未来3-5年可能会加速。

目前,它确实主要服务于AI服务器、高性能计算这些“高帅富”领域,因为那里对性能和能效的渴求最迫切,也最能承受初期的高成本-4。但是,技术发展的规律就是:一旦在高端领域被验证、量产和规模化,成本就会逐步下降,并开始向主流市场渗透。

对于手机来说,提升是“感知最强”的。想象一下这些场景:一是“永不停顿的流畅”。无论是玩超大型手游、多任务疯狂切换,还是拍摄和实时处理8K视频,因为数据搬运的瓶颈被极大缓解,那种轻微的卡顿、掉帧现象会大幅减少甚至消失。二是“续航的隐形提升”。数据在芯片内部传输比在主板上来回跑省电太多了-3,这部分节省的电量,可能会直接延长你的游戏时间,或者让手机在同等电量下更耐用。三是“AI功能全面开花”。手机上的AI助手、实时语言翻译、更强大的图像处理(比如一键修出大片),都需要瞬间调用海量数据并进行计算。集成DRAM正是这些即时AI体验的基石。

对于家用电脑(特别是笔记本电脑和高端台式机),体验提升类似:更流畅的创意工作(如4K视频剪辑、3D渲染)、更沉浸的游戏体验(更复杂的场景和模型实时加载),以及更低的整机功耗和发热。当然,初期它可能只会出现在最顶级的旗舰产品中,但就像当年的多核处理器、固态硬盘一样,它会逐渐成为中高端设备的标配,带来一次整体的体验跃升。

3. 网友“行业观察者”提问:

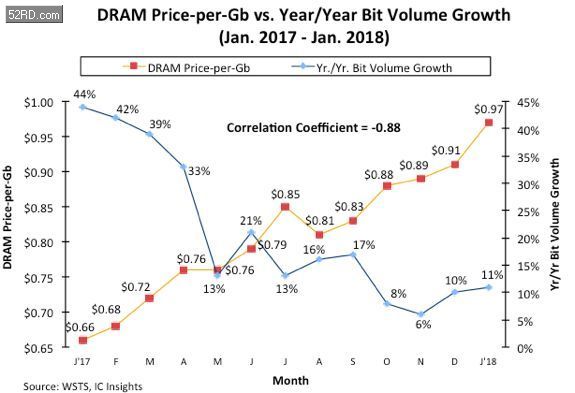

博主分析了技术和体验,我想从产业角度问问。最近看到新闻说存储芯片在涨价,而且大厂都在抢产能-7。这种集成DRAM的趋势,对整个半导体产业链(比如设计、制造、封装)会带来什么样的挑战和机会?我们国内的企业有机会吗?

答:

“行业观察者”的视角非常专业。的确,集成DRAM的兴起,正在重塑半导体产业链的游戏规则,这既是严峻挑战,也是巨大的换道超车机遇。

首先,挑战是全方位的:

设计复杂度剧增:传统的芯片设计是“处理器设计”和“内存设计”相对独立。现在要搞“片上系统”,需要将两者深度融合,这对架构设计、电路设计、信号完整性分析都提出了前所未有的高要求。

制造与封装工艺的极限挑战:这不再是简单地制造一颗CPU或一颗内存颗粒。它涉及到异构集成,可能需要将不同工艺节点、不同功能的芯片(如逻辑芯片和DRAM芯片)通过2.5D/3D封装技术(如硅中介层、硅通孔TSV)堆叠在一起-6-10。这对晶圆厂和封测厂的技术能力是极大考验,也大幅提升了制造成本。

产业链协作模式变革:传统的“处理器厂商-内存厂商-系统集成商”的线性供应链,可能演变为更紧密的“战略联盟”甚至“一体化设计”。例如,处理器巨头需要深度介入内存设计,内存巨头也需要理解计算架构。

机遇也同样巨大:

价值向上游集中:单纯制造标准内存颗粒的利润可能会被挤压,而拥有集成设计与先进封装能力的企业将获得更高的附加值。产业链的“皇冠”将从制造向设计与系统集成环节转移。

催生新玩家和新生态:这为一些在特定领域(如存算一体、异构集成)有深厚积累的创新公司提供了机会。它们可能不需要在传统CPU/GPU的赛道上与巨头硬刚,而是在新的架构范式下开辟细分市场-9。

封装技术成为核心竞技场:先进封装(如CoWoS、HBM封装)从“可选项”变成了“必选项”,相关设备、材料和设计服务公司将迎来黄金期。

对于我们国内的企业而言,机会是存在的,但路径需要清晰:

封装环节是国内的优势领域之一,一些领先的封测企业已经在积极布局2.5D/3D封装技术,这是切入集成DRAM生态的重要支点。

在特定应用领域进行创新:正如-9中提到的,国内有企业早在2019年就开始探索在DRAM中嵌入逻辑的“存算一体”技术,瞄准AIoT等新兴市场。避免在通用处理器红海竞争,而是在边缘计算、自动驾驶等对能效和特定算力要求高的领域,基于新架构打造解决方案,是一条可行的路径。

加强产学研合作与生态建设:如-10所示,国内研究机构在新型存储与集成技术的基础研发上已取得不错进展。推动这些前沿技术从实验室走向产业化,并围绕它们构建从IP、设计工具到制造的合作生态,至关重要。

集成DRAM代表的不仅是技术升级,更是一次产业格局调整的浪潮。它要求企业具备更强的系统思维、跨界整合能力和生态构建能力。在这场变革中,抓住设计和封装这两个核心环节,并在应用层面寻找差异化突破,是国内企业实现超越的关键。