第一次在Vivado里点开那个DDR3控制器IP核配置界面时,我盯着密密麻麻的参数选项愣了半天,心里直打鼓——这要是配错了,板子上的DRAM会不会直接罢工啊?现在想想,当时那份紧张劲儿还挺可爱的。

FPGA设计里用DRAM从来都不是件轻松事,但掌握正确方法后,你会发现Vivado其实为DRAM的应用提供了相当完整的工具链。

从最基本的Block RAM到复杂的DDR控制器IP核,每个环节都有讲究,而我最想跟你分享的,就是如何避开那些我踩过的坑。

刚接触Vivado那会儿,我对FPGA内部的存储资源了解甚少。直到某天项目需要一块大容量缓存,我才开始认真研究Block RAM这东西。

原来在UltraScale+架构的FPGA中,每个36Kb的BRAM可以配置成各种宽度和深度组合,比如32K×1、16K×2等等-1。

最让我惊喜的是,这些BRAM竟然支持真正的双端口操作,意味着两个端口可以完全独立地读写,这为很多并行处理场景提供了便利-1。

不过选BRAM也有讲究,是选18Kb的小块还是36Kb的大块?是做成真正的双端口还是简单双端口?我花了不少时间研究这些细节。

特别是当需要较大存储空间时,还能把相邻的BRAM级联起来,形成更大的存储块-1。这种灵活性让我在设计缓存架构时多了不少选择。

弄清楚BRAM的基本结构后,我开始深入研究它的操作模式。这里面的门道真不少,特别是三种写入模式:WRITE_FIRST、READ_FIRST和NO_CHANGE-1。

WRITE_FIRST模式比较“直白”,写入数据的同时就直接出现在输出端,这种透明写入在某些流水线设计中特别有用-1。READ_FIRST则是“先读后写”,在写入新数据前,先把旧数据读出来。

最省电的是NO_CHANGE模式,写入时输出端根本不动,保持上一次读取的值-1。我第一次用这个模式时,还纳闷怎么数据没变化,后来才明白这是设计特性,不是bug。

选哪种模式得看具体应用场景。如果是实时数据处理流水线,WRITE_FIRST可能更合适;如果是偶尔更新的配置存储器,NO_CHANGE的节能优势就体现出来了。

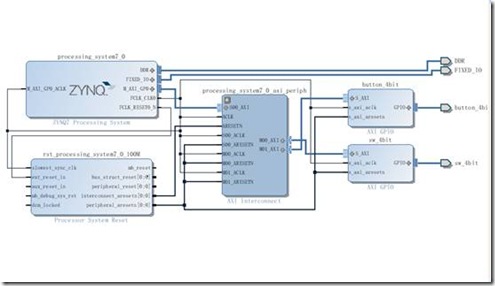

当Block RAM不够用的时候,就得请出外部的DRAM了。Vivado里的DDR控制器IP核真是个强大的工具,但初次使用绝对能让人头晕眼花-6。

我仍记得第一次打开MIG(Memory Interface Generator)时的场景,那一连串的参数:数据位宽、时钟比例、地址映射方式...每个选项背后都是一堆需要理解的概念。

用户接口部分相对友好一些,主要关注app_rdy、app_en、app_addr这些信号就行-6。但即便是这些“友好”的信号,时序配合也得小心翼翼。

特别是命令路径与数据路径的对齐问题,如果app_rdy和app_wdf_rdy没有协调好,很容易导致FIFO溢出或者数据丢失-6。这个坑我踩过,调试了大半天才找到原因。

调通了基本读写后,我开始琢磨怎么提高效率。这才发现DDR的地址映射方式对性能影响巨大-6。

默认的“ROW_COLUMN_BANK”顺序和另一种顺序的差异明显,在连续访问测试中,效率差距能达到肉眼可见的程度。这跟DDR的存储体切换、行激活等底层操作密切相关。

另一个影响效率的因素是刷新机制。DDR需要定期刷新保持数据,这段时间是不能进行正常读写的-6。IP核可以自动处理刷新,也可以交给用户控制,后者更灵活但也更复杂。

ODT(片上终端电阻)也是个需要注意的功能,它能改善信号完整性,特别是在多Rank配置中-6。正确配置ODT参数,能有效减少信号反射,提高稳定性。

硬件设计最怕什么?当然是设计有问题但直到上板才被发现。所以仿真是必不可少的环节-2。

Vivado对DDR IP核的仿真支持做得不错,提供了完整的仿真模型和测试样例-2。我第一次仿真DDR控制器时,就是跟着现成的example design一步步做的。

特别要注意init_calib_complete这个信号,它拉高表示DDR初始化校准完成,在此之前的所有读写操作都可能失败-2。我在仿真时特意观察了这个信号的变化过程。

仿真中还可以故意制造一些异常情况,比如命令与数据不对齐、突发长度不匹配等,看看IP核如何反应。这种“压力测试”能帮助理解IP核的边界行为,避免实际使用中出错。

经过几个项目后,我逐渐形成了自己的DRAM使用模式:对IP核的用户接口进行二次封装-6。

封装后的接口更加简洁,通常只保留类似FIFO的读写信号,这样在不同项目中复用起来方便多了。封装层还可以加入流控、错误处理等增强功能。

比如,我会在封装层里处理好命令与数据的对齐问题,确保app_rdy和app_wdf_rdy同时有效时才发起操作-6。这个逻辑只需实现一次,以后所有项目都能受益。

封装还有利于参数化配置,通过参数选择不同的地址映射方式、不同的突发长度等,使设计更加灵活。这种模块化的思维方式,大大提高了我的设计效率。

有时为了前期验证算法,不需要真正的DRAM硬件,这时可以用BRAM来模拟DRAM的行为-7。

中国科学技术大学的一个实验就采用了这种方法,用BRAM模仿DDR作为主存,同时实现了一个Cache层-7。虽然这种模拟无法完全复现DRAM的所有时序特性,但对于功能验证已经足够了。

这种方法的最大好处是仿真速度快,不需要等待DRAM的初始化校准和长延迟操作-7。在算法开发初期,能节省大量时间。

模拟时需要注意保持接口的一致性,这样当需要切换到真实DRAM时,只需更换底层实现,上层逻辑几乎不用修改。这种设计思路对我后来的项目影响很大。

问题一:在实际项目中,我该如何选择Block RAM和分布式RAM?两者主要区别是什么?

选择Block RAM还是分布式RAM主要取决于你的应用需求和资源状况。Block RAM是FPGA中专门的存储模块,每个36Kb的BRAM可以配置成各种宽度和深度组合-1。

它的优点是结构规整、性能可预测,而且不占用逻辑资源。分布式RAM则是用LUT(查找表)实现的,分散在CLB中。

如果存储需求较大且访问模式规整,Block RAM是更好的选择,特别是需要双端口访问时-1。分布式RAM适合小容量、分散的存储需求,或者需要非常灵活的位宽配置时。

还要考虑时序要求,Block RAM通常能跑到更高频率。资源利用率也很关键,如果你的设计已经用了大量逻辑资源,但Block RAM还有空余,那当然优先用Block RAM。

问题二:调试DDR3控制器时,最应该关注哪些信号和时序?

调试DDR3控制器时,首先要关注init_calib_complete信号,它标志着DDR初始化校准完成,只有这个信号拉高后,才能进行可靠的读写操作-2。

用户接口侧,app_rdy和app_en的握手时序是关键-6。只有当app_rdy为高时,app_en有效才会被接收。类似地,写入数据时要关注app_wdf_rdy信号。

特别注意命令路径与数据路径的对齐问题-6。虽然理论上这两个路径可以独立,但实践中最好保持同步,避免FIFO溢出。还要注意app_wdf_mask信号,如果不需要字节屏蔽功能,记得将其置为0而非保持高阻态。

物理层信号如CK、DQS、DQ的时序关系也很重要,但Vivado的IP核已经处理了大部分复杂性。如果遇到问题,可以检查PCB布局是否满足长度匹配要求。

问题三:为什么我的DDR读写效率无法达到理论最大值?有哪些优化手段?

DDR读写效率无法达到100%是正常现象,有几个固有因素限制:首先是刷新操作占用时间,DDR必须定期刷新保持数据,期间不能进行正常访问-6。

其次是存储体管理开销,每次切换行都需要预充电和激活操作。地址映射方式也影响很大,不同的MEM_ADDR_ORDER设置会导致不同的访问模式,从而影响效率-6。

优化手段包括:优化访问模式,尽量保持行不变的情况下进行列访问;合理设置突发长度,匹配数据需求;调整地址映射方式,找到最适合你访问模式的顺序。

还可以考虑缓存策略,使用Block RAM作为DDR的缓存,减少对DDR的随机访问-7。用户控制刷新时间,避开关键访问时段,也能小幅提升效率。