电脑开几十个浏览器标签就卡顿,游戏加载慢如蜗牛,专业软件运行时内存报错,这些日常烦恼的背后,是一套复杂精密的DRAM架构在默默工作,也在遭遇物理极限的挑战。

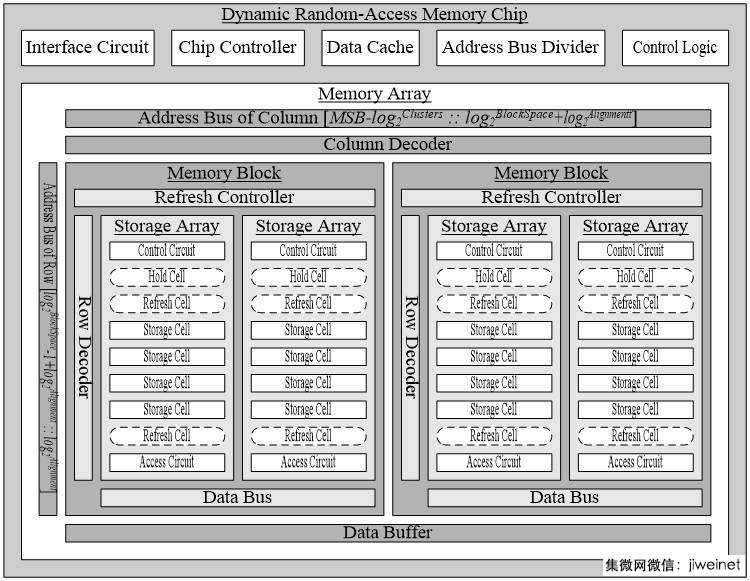

打开任何一台电脑,拆开机箱,你会看到一排排整齐的内存条。这些看似普通的电子元件,里面却藏着数以亿计的微小存储单元,构成了我们熟知的DRAM架构。

DRAM每个存储单元的核心其实非常简单:一个晶体管加一个小电容,这就是业界常说的1T1C结构-1。电容负责存储电荷——有电荷代表“1”,没电荷代表“0”;晶体管则像一个开关,控制着电荷的存取-4。

当你打开一个应用程序,CPU需要从内存中读取数据,这时DRAM架构就开始忙碌工作。地址被分为行地址和列地址,先找到行,再从行中找列,有点像是在大表格里找数据-1。

读取数据时,电容的电荷会通过晶体管释放到位线上。因为电容非常小,电荷也很微弱,所以需要“读出放大器”来增强这个信号-4。

这种设计聪明但也带来了麻烦——读取数据时电容的电荷会被消耗,这叫“破坏性读出”。每次读取后,DRAM都要重新写入数据,确保信息不丢失-1。

你可能不知道,即便你的电脑什么都不做,内存也在不停忙碌着。DRAM架构有个“先天缺陷”:电容会漏电。

这不是质量问题,而是物理特性。随着时间的推移,电容上的电荷会自然泄漏,如果放任不管,存储的“1”就会悄悄变成“0”-4。

为了防止数据丢失,DRAM必须定期“刷新”——重新读取每一行数据并再次写入。行业标准是每64毫秒就要刷新所有行一遍-1。

刷新操作看似简单,却占用了宝贵的内存带宽。想象一下,你正专注工作,每隔几分钟就有人打断你问同样的问题,效率自然会下降。内存也是如此,刷新操作打断了正常的数据读写。

随着DRAM工艺越来越先进,存储单元越来越小,这个问题更加严重。电容小了,电荷存储能力下降,泄漏更快,刷新的频率可能还需要提高-2。

过去几十年,DRAM的发展遵循着摩尔定律,存储单元不断缩小。从最初的微米级到现在的十几纳米,我们取得了巨大进步-2。

但这趟微缩之旅即将到站。当DRAM单元尺寸缩小到10纳米以下时,一系列物理问题开始显现:电容难以保持足够电荷,晶体管泄漏增加,工艺复杂性急剧上升-2。

主要DRAM制造商如三星、美光和SK海力士已经将DRAM单元缩小到15纳米以下,正在开发被称为D1b(或1β)和D1c(或1γ)的下一代技术-2。

即使使用最先进的EUV光刻机,DRAM单元进一步缩小到12纳米以下也面临着巨大挑战-2。这不仅仅是技术问题,更是经济考量——设备成本飙升,但性能提升有限。

当前的6F² DRAM单元设计预计在2027或2028年达到10纳米设计规则,这可能将是传统平面DRAM的最后一个节点-2。

作为普通用户,你可能最关心三个问题:内存能开多少程序(容量)、程序运行快不快(速度)、会不会突然崩溃(稳定性)。但在DRAM架构中,这三个目标形成了经典的“不可能三角”。

传统DDR5架构下,提升内存容量通常需要在频率与稳定度之间做出取舍-3。高容量内存很难同时达到高频率,因为信号完整性面临挑战。

当你插满四条内存条,特别是大容量型号时,主板内存控制器压力增大,往往不得不降低运行频率以保证稳定。这就是为什么很多发烧友只插两条内存条,而不是插满所有插槽。

技嘉在CES 2026上展示了突破性的CQDIMM技术,通过两条128GB内存实现256GB容量,同时达到DDR5-7200的高频率,突破了高容量与高频率无法兼得的传统限制-3。

这一突破背后是主板电路设计的优化和BIOS调校技术的结合,有效提升信号完整性,即使在高负载与长时间运作下,依然能维持稳定表现-3。

当平面微缩遇到瓶颈,工程师们开始向上寻找空间。就像城市无法向外扩张时就建高楼一样,DRAM架构也正从2D平面走向3D立体-8。

3D DRAM被认为是下一代高密度架构的关键方向。随着平面DRAM制程逼近物理极限,产业正转向立体化。三星、SK海力士、美光等大厂都在积极布局3D DRAM技术-8。

三星正在开发VCT(垂直通道晶体管)DRAM,预计最快2-3年内能看到实际产品。SK海力士已经展示了5层堆叠原型,良率达到56.1%-8。

更有突破性的是,NEO Semiconductor最近宣布了3D X-DRAM技术,采用单晶体管单电容(1T1C)和三晶体管零电容(3T0C)的全新架构,有望提供比当前普通DRAM模块10倍的容量-9。

这种3D DRAM架构可以像3D NAND闪存一样堆叠,在单一模块上容纳高达512Gb(64GB)的容量,同时保持出色的读写速度和能效-9。

随着计算需求多样化,一种DRAM架构适应所有场景的时代正在结束。现在的趋势是为不同应用专门设计不同的内存解决方案。

对于AI和高性能计算,HBM(高带宽内存)成为关键。HBM通过堆叠DRAM芯片并使用硅通孔(TSV)技术垂直连接,大幅提升数据传输带宽-6。

SK海力士在CES 2026上展示了HBM4 16层48GB产品,速度达到业界领先的11.7Gbps,专门为下一代AI加速器设计-6。

对于移动设备和边缘AI,低功耗是关键。LPDDR6作为下一代低功耗DRAM,使设备端AI能够独立运行,无需依赖云端-6。

还有一些特殊应用需要定制化内存。台厂华邦电的CUBE产品具备高带宽、低功耗、散热优化与可定制化特点,首波锁定穿戴式装置与轻量AI眼镜等新兴市场-8。

除了架构创新,材料科学也在推动DRAM进步。氧化铟镓锌(IGZO)这种新材料正被研究用于DRAM晶体管通道-8。

与传统的硅相比,IGZO具有更低的泄漏电流,这意味着更低的功耗和刷新的频率-8。对于需要长时间保持数据的应用,如物联网设备,这一特性尤其重要。

SK海力士正在研究将IGZO作为内存晶体管通道材料,以改善功耗与刷新特性-8。NEO Semiconductor的3D X-DRAM设计也采用了基于IGZO的材料-9。

在电容方面,高k介电材料的使用也在增加。这些材料可以在更薄的厚度下提供相同的电容值,有助于缩小存储单元尺寸,同时保持足够的电荷存储能力-2。

随着AI、边缘计算和物联网的发展,内存需求将持续增长。未来的DRAM架构可能会更加多样化——3D堆叠、新材料、专用化设计将齐头并进。

到2027年底,DRAM有望迈入个位数纳米技术节点,如D0a,随后将是0b和0c世代-5。但这可能接近传统平面DRAM的终点,之后3D DRAM将成为主流。

DRAM架构的演进反映了整个半导体行业的创新精神——当一条路走到尽头时,总能找到新的方向。从平面微缩到立体堆叠,从通用设计到专用优化,从硅基材料到新型化合物,内存技术正在多个维度上突破极限。

无论你是普通用户还是技术爱好者,理解这些DRAM架构的基本原理和发展趋势,都能帮助你更好地选择和使用计算设备,也能更深入地理解数字世界是如何运作的。

网友“科技探险家”提问: 我听说未来会有3D DRAM,这和现在的3D NAND闪存有什么区别?它们能互相替代吗?

这是一个很好的问题!3D DRAM和3D NAND虽然都采用堆叠技术,但设计目标和原理完全不同。3D NAND是非易失性存储,断电后数据不丢失,主要用于SSD等长期存储设备-2。

3D DRAM则是易失性存储,需要持续供电保持数据,但访问速度快得多,主要用作系统内存-9。它们的工作原理也不同:DRAM依靠电容存储电荷,需要定期刷新;NAND则通过浮栅晶体管存储电荷,不需要刷新-4。

未来两者不太可能直接替代,而是在不同层级共同工作——3D DRAM作为高速内存,3D NAND作为大容量存储,可能还会有新兴存储技术如MRAM填补中间层级-2。

3D DRAM的挑战在于保持DRAM的高速特性同时实现堆叠,而3D NAND则专注于在垂直方向增加层数来提高容量-8。

网友“硬件小白”提问: 我最近装电脑,应该选DDR4还是DDR5?另外容量和频率哪个更重要?

对于新装机用户,如果预算允许,DDR5是更好的选择,尤其是考虑到未来几年的使用需求。DDR5提供更高的频率和能效,虽然目前价格较高,但已逐渐成为主流。

关于容量和频率的选择,这取决于你的使用场景。对于游戏玩家,频率往往更重要,因为更高的频率可以提供更高的帧率,特别是使用集成显卡时。16GB DDR5-6000可能是比32GB DDR5-4800更好的选择。

如果你主要进行视频编辑、3D渲染或运行虚拟机,那么容量优先。32GB或64GB的容量可以避免频繁的硬盘交换,大幅提升工作效率,即使频率稍低也值得。

最新的CQDIMM技术已经突破高容量与高频率不能兼得的限制,如技嘉展示的256GB DDR5-7200配置-3,但这类高端方案价格不菲,适合专业用户。

网友“未来观察者”提问: AI发展这么快,对DRAM架构会有什么特别的影响?我们普通用户会感受到什么变化?

AI确实在深刻改变DRAM架构的发展方向。AI训练需要极高的内存带宽,这推动了HBM技术的发展。HBM通过3D堆叠和宽接口提供远超传统DDR的内存带宽-6。

对于普通用户,最直接的感受可能是设备端AI功能的增强。新一代LPDDR6内存使手机、笔记本电脑能够本地运行更复杂的AI模型,无需联网-6,这意味着更快的响应速度和更好的隐私保护。

AI也会推动内存定制化。针对特定AI工作负载优化的内存设计会出现,如SK海力士展示的cHBM(定制高带宽内存)和CuD(计算用DRAM)-6。

长远来看,AI可能催生全新的计算架构,如内存计算(在内存中直接处理数据),这将彻底改变传统冯·诺依曼架构中CPU与内存的关系,进一步推动DRAM架构的创新。