哎呀,说起现在那些高性能的电脑、手机和AI服务器,性能是一个比一个猛,但暗地里个个都是“吃电大户”。你可知道,在许多系统里,内存(尤其是DRAM)这家伙,悄摸摸地就能吃掉总功耗的近三分之一-3!这可不是个小数目,电费蹭蹭涨,设备发热量嗷嗷叫,工程师们头发一把把地掉,都想着怎么给这头“电老虎”拴上缰绳。不过别急,这几年行业里对付DRAM芯片功耗的法子是越来越高明,一场精彩的降耗大戏正在上演。

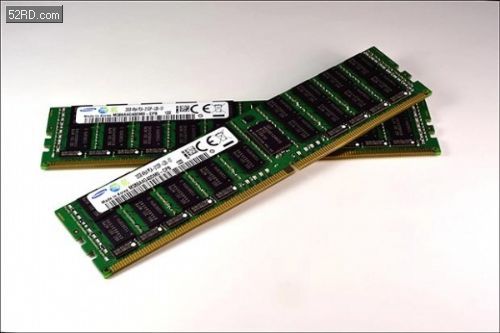

要降低功耗,最根本的路子就是让芯片本身更“精干”。这就好比给汽车换上一个更高效、更省油的发动机。各大厂商在这条路上可是铆足了劲。美光科技前不久宣布开始出货的1γ(1-gamma)制程DDR5 DRAM,就是个狠角色。它采用了下一代高K金属栅极CMOS技术,再配合一系列设计优化,跟前一代产品比起来,速度提升15%的同时,功耗直接砍掉了20%以上-1。你可别小看这20%,放到庞大的数据中心里,省下的电费能盖好几层楼!而且,这个新制程还能让每片晶圆产出更多的芯片,成本摊薄,对我们消费者来说也是好事一桩-1。

更激进的“瘦身”计划还在后头。传统的DRAM就像平房,想住更多人就得拼命扩占地面积(平面微缩),但现在快到物理极限了。于是,大家开始想着盖“摩天大楼”——也就是3D堆叠。铠侠(KIOXIA)最近亮出了一项黑科技:用氧化物半导体(比如InGaZnO)来做晶体管沟道。这材料有个绝活,它的关断电流极低,低到不可思议(<1aA,也就是10的负18次方安培)-7。这意味着啥?意味着DRAM里最烦人、最持续的“刷新”操作可以大大减少。因为数据电荷漏得慢嘛,就不用那么频繁地去“加固”它了。这项技术为未来高密度、低功耗的3D DRAM铺平了道路,一旦实用化,可能就是颠覆性的-7。

光有先进的制造工艺还不够,针对不同场景的“对症下药”同样关键。这就好比虽然都有了节能发动机,但跑车、家用轿车和货车的省油设计肯定不一样。

对于手机、平板这些对电量斤斤计较的设备,LPDDR系列一直是低功耗的代名词。有实测案例显示,在嵌入式系统里,把内存从DDR4换成LPDDR5,整体功耗能狂降41.2%-6。这是因为LPDDR5的工作电压更低(VDDQ IO摆幅0.5V,而DDR5要1.1V),本身阵列设计也更省电-6。华邦电子则在产品设计优化上玩出了花,他们推出的Green Power Boost DRAM,运行功耗比常规产品低10%,待机功耗更是吓人,比普通SDRAM低了60%到70%-2。待机功耗能压这么低,对物联网设备这种常年“睡着”偶尔“醒一下”的装置来说,简直是续命神器。

就连对性能极致追求的显卡内存(GDDR),也在琢磨省电的学问。有研究专注于降低其待机和自刷新功耗,因为显卡内存其实在很多时间里也处于“待命”状态-4。通过改进架构和管理模式,也能从这只“电老虎”嘴里抠出不少能源。

除了硬件本身,在系统和电路层面动脑筋,也能挖出巨大的节能潜力。这里面的门道,可一点也不比造芯片简单。

最经典的一招就是“降压”。有学术研究对大量现代DRAM芯片做了实验,发现如果能在严格控制延迟和可靠性的前提下,把工作电压稍稍降低那么一点,就能实现平均10.5%的DRAM节能效果,而对系统性能的影响只有微不足道的1.8%-8。这需要非常精密的电压-延迟-可靠性协同管理技术,就像给芯片进行一场精密的“降压手术”。

另一大块肥肉是“刷新功耗”。DRAM需要定期刷新来保持数据,这部分功耗是背景功耗的大头,而且内存容量越大,它越高-3。研究人员提出了各种聪明的办法,比如在芯片空闲时,动态分析每一行数据的保持时间特性,温度高时刷勤点,温度低时刷慢点,而不是死板地按最高温标准来-3。还有些方法能找出那些特别“健忘”(电荷漏得快)的存储单元,对它们进行特殊照顾或加固,从而让其他大部分单元可以享受更长的刷新间隔-3。这些方法都能有效缓解DRAM芯片功耗中这个顽固的“固定支出”。

降功耗不仅是芯片厂商的事,更是一个系统工程。好消息是,整个生态都在为此努力。比如,为了更早、更准地预估和优化内存子系统的功耗,像弗劳恩霍夫协会这样的研究机构正在开发开源的DRAM仿真和功耗分析框架(如DRAMSys和DRAMPower)-9。这能让更多公司和开发者在设计初期就把功耗考量进去,避免后期抓瞎。

同时,强大的测试工具也至关重要。泰克科技等公司提供的专业DDR/LPDDR测试方案,能帮助工程师在设计和验证阶段就精准地把控信号完整性、电压和时序-5。确保内存稳定工作在最佳状态,本身也是避免无畏功耗浪费的关键。你想啊,信号质量差导致数据出错,系统就得重传,这来回折腾不都是额外的耗电吗?

所以说,驯服DRAM这头“电老虎”,是一场从纳米级晶体管工艺到系统级架构设计,再到开发测试工具的全面战役。我们欣喜地看到,通过制程迭代、产品创新、系统优化和生态共建,内存的能效比正在飞速提升。未来的AI世界需要海量数据高速流动,而承载这些数据的内存,必将以更冷静、更高效的方式,默默支撑起我们的智能时代。

1. 问:@数码刨根哥 你文章里提到降低电压可以省电,但又说可能出错,这不矛盾吗?具体怎么安全地“降压”?

答:嘿,这位哥问到了点子上,这不矛盾,但确实是在走钢丝!简单比喻,就像让一个人用95%的力气匀速跑步,比让他用100%的力气更省体能,且能跑很久。但力度降到90%可能就跑不稳了。DRAM电压也是类似,厂商会给一个标称电压(比如1.2V),保证在所有恶劣条件下都绝对稳定-8。

安全“降压”的核心是 “动态精细管控” 。它不是一刀切,而是:1. 实时监控:系统会持续监测芯片的温度、当前工作负载(是疯狂计算还是轻度待机)-3。温度低时,电荷泄露慢,降压空间就大些。2. 容忍小幅延迟:研究发现,稍微延长一点数据存取的核心操作(如激活、预充电)的时间,就能在更低的电压下避免出错-8。3. 性能模型决策:就像文章里提到的Voltron技术,系统里有个智能模型,它会实时计算:“在当前状态下,电压最多能降多少,既不出错,又把性能损失控制在用户设定的可接受范围内(比如2%以下)?”-8。通过这种组合拳,才能实现平均节能超10%而几乎不影响体验的效果。

2. 问:@硬件菜鸟 对于像我这样的普通DIY玩家,想给电脑省电、降低发热,在内存选择上有什么最直接、实操性的建议吗?

答:同学你这问题很实在!对于大部分玩家,不用搞懂复杂技术,抓住几个关键点就行:

第一,优先选择新款制程的内存。 直接看产品宣传,比如现在最新的DDR5内存,如果注明是采用“1β”或“1γ”制程的,就像文章里美光那个,其能效比通常比早期DDR5产品明显更好-1。第二,认清“LPDDR”与“DDR”。 如果你是装笔记本或者迷你主机,现在很多高性能型号也开始采用板载的LPDDR5内存了。它的最大优势就是超低功耗,能显著提升续航和降低发热-6。对于台式机,目前主要还是DDR5,但可以选择低电压版本(注意查看参数)。第三,关注频率与时序的平衡。 不是频率越高越好。超高频率的内存往往需要加电压来稳住,可能更热更耗电。对于绝大多数游戏和日常应用,选择一套频率适中(如DDR5-6000)、时序较低(如CL30)的内存,往往能获得更好的能效比和更低的发热。在主板BIOS里,可以尝试开启“节能模式”或“XMP/EXPO低电压预设”,这通常是在保证稳定的前提下,由厂商调优过的省电设置。

3. 问:@工程师老王 我是做嵌入式开发的,项目对功耗极其敏感。除了选LPDDR,在电路设计和系统层面还有什么能降低内存功耗的细节?

答:王工,同行你好!嵌入式场景的功耗真是抠到毫厘之间。除了选型,这几个实战细节值得关注:

1. 充分利用低功耗状态。 像LPDDR4/5都有丰富的电源状态(如Active、Idle、Self-Refresh)。一定要确保你的内存控制器驱动和固件能根据总线活跃度,及时、合理地将内存颗粒或通道切入更深的休眠状态。2. 优化刷新策略。 如果设备工作环境温度相对稳定(比如室内设备),可以研究一下能否在驱动层,根据温度传感器读数,动态调整刷新率(部分芯片支持)。避免在低温环境下仍使用高温的刷新参数,能省下可观的背景功耗-3。3. 物理布局与信号完整性。 这可是隐藏的功耗杀手。确保内存走线符合规范,做好阻抗控制和端接。信号质量差会引起数据错误重传,增加无效功耗。使用文章里提到的专业调试工具,在前期做好信号验证(眼图、时序测量)至关重要-5。4. 业务逻辑优化。 在软件层面,优化数据访问模式。尽量让访问连续、集中(高页命中率),减少随机、分散的访问。因为每次打开一个新的内存行(激活命令)都会比连续读取消耗更多功率-6。通过缓存、数据预取等算法减少对内存的访问次数,是从根源上省电。