游戏加载总卡在99%,视频剪辑时进度条龟速前进,这些电脑卡顿的背后,都藏着一个被忽视的关键角色——DRAM访问时间。

性能更佳的DRAM访问时间,就是允许电脑在同一时间片内完成更多的数据读写操作,这不就是让人感觉电脑变快的原理吗-3。

近年来,研究显示,FASA-DRAM技术相比传统DDR4 DRAM,在处理四核工作负载时平均性能提升了19.9%,能耗降低了18.1%-3。

组装过电脑的朋友可能都经历过这样的困惑:CPU和显卡都是最新型号,内存条频率也标得老高,可有时候系统还是会莫名其妙地“卡一下”。

玩大型游戏加载场景时,明明进度条显示已经99%了,却要等上好几秒。或者用视频软件渲染时,看着那个缓慢前进的进度条干着急。

以前我总把这些归咎于CPU不够快或者硬盘太慢,直到深入了解计算机原理后才发现,很多时候问题出在内存访问这个环节。

特别是动态随机存取存储器(DRAM),它就像电脑的短期记忆库,存放着CPU当前需要处理的所有数据-1。

什么是DRAM访问时间呢?简单来说,它指的是从CPU发出数据请求到实际从DRAM中获取到数据所需的平均时间,通常以纳秒(ns)为单位-4。

这可不是一个简单的取数据动作。实际上,DRAM访问时间等于地址设置时间加上延迟时间-1。就像你要去图书馆找一本书,得先确定书在哪一排书架(地址设置),然后再走到具体位置取出书(数据访问)。

现代计算机系统中,这个时间通常在50-70纳秒左右-4。对于以GHz频率运行的CPU来说,几十纳秒的等待意味着几十甚至上百个时钟周期的浪费。

这导致一次缓存未命中操作可能会引起几十个周期、甚至上百个周期的等待,大大降低了整个系统的性能-5。

为什么DRAM访问会这么耗时?这要从它的工作原理说起。DRAM使用电容来存储数据,电容有电荷代表1,没电荷代表0-5。

但这种存储方式有个致命缺点——电容会自然放电,所以必须定期刷新数据-2。这个刷新周期一般是2ms、4ms或8ms-2。

以集中式刷新为例,每2ms的刷新周期内,有64微秒用于实际的刷新,这段时间DRAM无法提供数据-7。想象一下,如果内存条每2秒就有近1/30的时间“罢工”,系统性能能不受到影响吗?

一个完整的DRAM访问包括三个部分:行选、列选和预充-5。就像在大型仓库找货,得先找到正确的货架(行选),再找货架上的具体位置(列选),最后完成取货动作(预充为下一次访问做准备)。

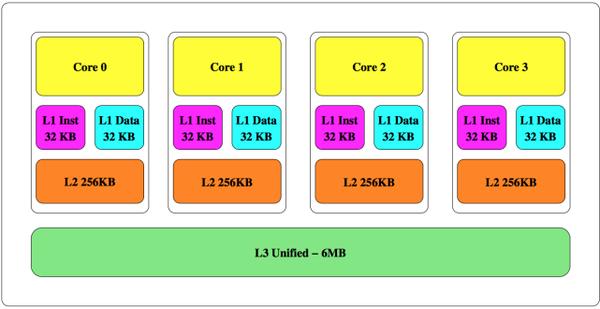

随着多核处理器的普及,DRAM访问时间问题变得更加复杂。多个核心同时请求内存访问,就像多条道路的车流汇入一个收费站,拥堵几乎不可避免-3。

应用程序间的相互干扰导致随机内存访问流量增加-3。更糟糕的是,写入密集型应用的数据局部性要低得多,会频繁地替换掉内存中的有用数据-3。

现代研究指出,数据在快速DRAM缓存和慢速常规阵列之间频繁移动产生的开销,甚至可能抵消DRAM缓存的性能和能源优势-3。

这就像快递员不停地在仓库和配送点之间来回跑,大部分时间都花在路上了,实际送货的效率反而降低了。

面对这些挑战,研究人员并没有坐以待毙。近年来出现了许多创新技术来优化DRAM访问时间。

FASA-DRAM就是其中一项很有前景的技术。它采用破坏性激活和延迟恢复的方法,将数据移动过程分为两个阶段-3。

第一阶段是负载减少破坏性激活(LRDA),它会破坏性地将数据提升到DRAM缓存中;第二阶段是延迟周期窃取恢复(DCSR),在DRAM存储体空闲时恢复原始数据-3。

这种设计的巧妙之处在于,它将最耗时的恢复阶段与激活阶段分离开,并通过存储体级并行性隐藏恢复延迟-3。这就像是餐厅的服务流程优化——服务员不用等一桌客人完全离开并清理干净后才接待下一桌,而是可以同时管理多桌客人的不同需求阶段。

DRAM访问时间的未来发展方向是什么呢?自适应DRAM控制器可能是答案之一-10。

与传统DRAM控制器不同,这些新型控制器采用调度器与协议分离的架构,能够根据不同的使用场景动态调整-10。

实验结果显示,这种自适应调度算法在各种实际场景中能将延迟降低约10%到50%-10。想象一下,如果你的内存访问效率能提升一半,那电脑的整体性能会有多大的飞跃!

另一种思路是在芯片上集成DRAM缓存,以弥补高速核心和片外内存之间不断扩大的延迟差距-8。片上DRAM缓存有两个重要参数——缓存未命中率和缓存命中延迟,它们共同影响着系统性能-8。

DRAM访问时间的优化竞赛在实验室和半导体工厂中悄然加速。当自适应控制器学会预测不同应用的内存访问模式,当破坏性激活技术巧妙隐藏了延迟,DRAM不再只是被动存储数据的仓库。

那个让CPU等待数十个周期的瓶颈,正在被一层层剥开。每一次访问时间的缩短,都是向瞬时响应世界迈出的一小步,最终将编织成无处不在的无缝体验。