不知道你有没有过这种经历,新买的电脑头两个月飞快,用着用着就感觉“堵”得慌?或者玩大型游戏正到关键团战,画面突然卡成PPT?早些年我在一家主板厂打杂的时候,可没少听工程师们吐槽:“这代内存延迟又没压住”,“信号完整性真是玄学”。后来自己折腾超频,对着BIOS里那一排排看不懂的时序参数发呆,我才真正意识到,DRAM芯片读写线的整理与优化,根本不是发烧友的炫技,而是实实在在影响每台电脑流畅度的底层密码。它就像城市里错综复杂的道路系统,规划得好,数据一路绿灯;规划得不好,再强的CPU也得在路上干着急-2。

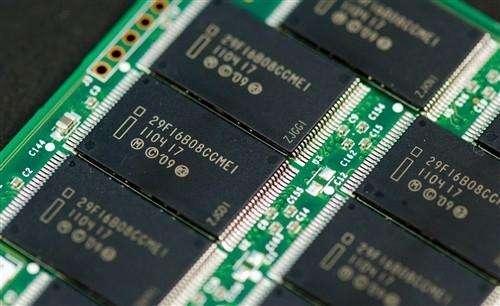

首先咱得破除一个迷思。提到“读写线”,很多人脑子里可能就是电路板上那些细细的铜箔。其实,在DRAM的世界里,它是一整套从处理器出发,穿过内存控制器(PHY),最终抵达DRAM存储单元阵列的完整数据传输路径。这条路径上跑的不是一辆车,而是由时钟(CK)、命令地址(CA)和无数数据位(DQ)组成的、一支必须在严格同步下齐步走的“军团”-3。

DRAM的存储核心可以想象成一个巨大的棋盘(存储阵列),每个格子(存储单元)由一个晶体管和一个微小的电容组成,数据就靠电容里有没有电荷来表示-1。当你需要读取数据时,控制器先发通行证(激活命令)打开对应的某一行(字线),这一整行的电荷状态会被连接到非常敏感的读出放大器上。再选择具体的列(位线),把放大后的数据送出去-1。这个过程本身就慢(有tRCD、CL等各种延迟等待期),更麻烦的是,读操作会“消耗”电容的电荷,所以读完还得赶紧把数据原样写回去(重写/预充电),不然数据就丢了-1-8。你看,DRAM芯片读写线上跑的每一次数据,背后都是这一连串精密的“物理动作”。

而现代计算机追求的“高带宽”,说白了就是让这支数据军团跑得更密集、步伐更快。但速度一提,问题全来了:信号在物理线路里传输会有延迟,每根线的延迟还未必一样(这叫偏移,Skew);线路间的电磁干扰会加剧(串扰);高频下信号波形本身也会衰减变形-3。这就好比要求百米赛跑运动员每一步都精确到纳秒,但每个人的跑道摩擦力和风向都不同。结果就是数据到达时间参差不齐,接收方采样的窗口变得极窄,极易出错,这就是系统不稳、蓝屏死机的根源之一。

所以,“整理”读写线,核心目标就是让所有数据信号对齐,在正确的时刻出现在正确的位置。这可不是拿个扎带把线捆整齐就行,而是一套软硬结合的系统工程。

第一招,也是基本功:PHY的“军训”——读写均衡训练

这是高速DDR内存(如DDR4/5)稳定工作的基石。你可以把内存控制器(PHY)理解成教官,DRAM颗粒是新兵。上电后,PHY会自动发起一系列“训练”,核心任务就是测量并补偿命令地址线和数据线之间的路径延迟差-3。

举个例子,在“写入均衡”训练中,PHY会不断微调它发送数据选通信号(DQS)的时机,让DRAM颗粒能用这个DQS准确地采样到时钟信号(CK),然后DRAM把采样结果反馈回来。通过分析这个反馈,PHY就能精确知道该把数据信号提前或推后多少,才能和命令同步抵达-3。这就解决了“教官喊齐步走的口令,因为距离不同,传到每个新兵耳朵有时间差”的问题。一些先进的方案(如某些国产IP厂商采用的固件训练)甚至能解决更复杂的整数周期偏差,让对齐精度更高,在大规模量产时一致性更好-3。

第二招,架构革新:从“羊肠小道”到“立体高架”

如果说训练是交通管制,那架构升级就是拓宽道路、建立交桥。传统的DRAM访问模式效率低,就像一条单车道,同一时间只能进行读或写一种操作,还要频繁地为关闭一行、打开另一行而“预充电”浪费周期-8。

而像“全字线I/O”这样的创新架构,则带来了革命性的变化-4。它有点像把一整条街(一行所有存储单元)同时对外开放。在这种架构下,配合特殊的感应放大器电路,可以在同一个时钟周期内,让一个Bank执行读取数据的“回写”操作,同时让另一个Bank利用全局数据线进行新的读写,实现了真正的读写流水线-4。这极大地提升了DRAM芯片读写线的数据吞吐效率,把单车道变成了可以同时上下客的立体交通枢纽。

第三招,系统级协同:接口芯片组的“超级助攻”

当数据速率冲向每秒数千兆次传输(GT/s),单靠CPU和DRAM颗粒已经力不从心。这时,内存接口芯片组就成了关键的“信号中继站”和“交警”-2。

特别是在服务器常用的RDIMM(寄存式双列直插内存模块)和更先进的MRDIMM(多路合并内存模块)上,你会找到一颗寄存器时钟驱动器(RCD)和若干数据缓冲器(DB)。它们的作用是重新驱动并整形从CPU发过来的命令、地址和时钟信号,再分发给模块上的多个DRAM颗粒,极大地减轻了CPU的信号负载,提升了信号完整性和可支持的内存容量-2。根据瑞萨电子的资料,其第五代RCD能让RDIMM在8GT/s下稳定运行,而针对DDR5的MRDIMM方案更是瞄准了12.8GT/s的惊人速度,通过让两列内存并行工作,将有效带宽提升了6%到33%-2。这相当于在主干道上设立了多个智能分流点和信号增强器,保证了即便车队再庞大、车速再快,指令也能清晰、同步地传达到每一个终端。

整理技术的前沿探索,正朝着三维立体和材料创新的方向发展。HBM(高带宽内存)通过3D堆叠和硅中介层,将内存直接“盖”在GPU旁边,用超短、超宽的互联通道实现了堪比“数据电梯”的极致带宽和能效-9。而像4F2垂直晶体管、电容-晶体管异质键合(CBA)等新型DRAM制造工艺,则致力于在芯片内部进一步缩小单元面积、提升密度,从源头上为更高效的数据通路布局创造物理空间-10。

说到底,每一次点击、每一次游戏加载、每一次AI计算,背后都是海量数据在DRAM芯片读写线这座复杂立交桥上的疯狂竞速。我们用户感受到的“快”与“慢”、“稳”与“崩”,很大程度上就取决于这条数据通路是否被精心设计和持续优化。从主板的布线设计、BIOS里的训练算法,到内存颗粒本身的体质和接口芯片的效能,环环相扣。所以,当你下次再抱怨内存延迟时,不妨想想这片隐藏在芯片之下、由物理、电路和算法共同构建的微观交通世界——它的畅通与否,直接决定了我们数字生活的体验时速。

1. 网友“硬核装机佬”提问:看了文章,感觉内存布线好复杂。我们DIY玩家在选主板和内存条时,怎么从硬件上判断一套配置对读写线优化好不好?有啥肉眼可见的窍门吗?

答: 这位哥们问题很实在!确实,我们不能拆开芯片看布线,但还是有几个非常实用的“外部观察点”。

首选,看主板“堆料”与设计。 高端主板(尤其是Z系列、X系列芯片组)在内存插槽附近会下重本。第一,数电感和电容。内存供电模块(通常在插槽上方或左侧)的“小方块”(电感)和“小圆柱”(电容)越多、越密集,说明供电相数可能更足,能为内存超频提供更纯净、稳定的电压,这是信号稳定的基础-2。第二,看布线。优质主板会采用所谓的“菊花链”或“T型拓扑”布线。简单说,你可以观察内存插槽到CPU插座之间的线路:如果线路走得非常直、对称,而且两条插槽间的走线长度看起来经过精心匹配,这通常是为高频稳定信号设计的。很多主板还会在内存走线层做屏蔽罩,这在产品介绍里会作为卖点。

看内存条本身的“身份”。 对于追求极致稳定的玩家,特别是用AMD锐龙或英特尔至强(多通道)平台,建议首选 “带寄存器”的RDIMM(通常用于服务器,部分消费级主板支持)或至少是带有温度传感器的裸条。RDIMM上面那颗RCD芯片(就是文章里说的“信号交警”),对于稳定驱动多根大容量内存条有奇效-2。而温度传感器能让主板更精准地调控电压,防止高温导致信号失真。另外,内存颗粒的品牌和批次(如三星B-die、海力士CJR等)在超频社区有口碑,本质上也是其内部读写路径电气性能一致的体现。

终极窍门:查BIOS选项和厂商“背书”。 进主板BIOS,看看内存高级设置里有没有丰富的时序调整和训练选项(比如华硕的“MemTweakIt”功能)。功能越细,说明厂商在信号优化上投入的研发越深。更直接的是,去主板官网内存支持列表(QVL)查。列表里不仅写明支持型号,还会标注最高支持的频率。如果某块主板能把某款内存标到很高频率(比如DDR5-8000+),这本身就是其PCB布线、信号完整性设计过硬的最好证明-3。记住,好的配置是让数据军团跑起来的基础,而优秀的主板和内存,就是给它们修建了高标准、无干扰的“军用跑道”。

2. 网友“深夜运维猫”提问:我是做服务器运维的,最近机房有台机器老报不可纠正内存错误(UE),换过内存条也没根治。从读写线信号角度看,除了内存本身,还有哪些地方容易出问题?排查思路应该是怎样的?

答: 老哥遇到的情况太典型了!服务器环境下的UE错误,硬件问题远多于软件,而且确实不能只盯着内存条。从信号路径出发,你的排查思路可以像“顺藤摸瓜”一样系统化:

第一步:锁定物理位置与拓扑。 先通过BMC或操作系统日志,精确记录报错的内存通道、DIMM槽位甚至逻辑Bank号。现代服务器CPU内存控制器都是多通道的。如果错误总是发生在同一个通道的不同槽位上,那么“瓜藤”的根部很可能在CPU插座到这个通道的路径上:可能是CPU底座触点氧化、主板该通道的布线有物理损伤或阻抗异常,当然,CPU内部的内存控制器(IMC)本身缺陷也是可能原因。如果错误随机出现在不同通道,则更倾向于是全局性问题,比如主板供电(特别是VDDQ内存电压)不稳,或者PCIe设备等高速信号对内存线的电磁干扰-3。

第二步:重点怀疑“信号中继站”——RCD与时钟。 对于使用RDIMM/LRDIMM的服务器,RCD芯片是最高危的嫌疑人之一。它工作频率高,压力大。如果散热不良(比如被导风罩挡住),或者其本身的供电(由DIMM上的PMIC提供)不稳,就会导致它转发的命令/地址信号出现扭曲或偏移,引发大面积数据错误-2。你可以尝试:1. 调换DIMM位置,如果错误跟着RDIMM走,那就是该内存条(包括其上RCD)问题;如果错误留在槽位,则是主板或CPU问题。2. 在BIOS中轻微调高相关电压(如VPP、VDDQ),有时能补偿因老化导致的信号强度下降。另外,检查主板上的参考时钟发生器,它为内存系统提供基准时钟,其质量至关重要。

第三步:环境与压力测试。 服务器内存错误常有“温度特性”。在业务低峰期(环境温度较低)可能正常,一到业务高峰(机箱内温度升高)就报错。这是因为半导体特性随温度变化,信号时序会漂移-3。建议在高负载且提高环境温度的条件下,运行长时间的内存压力测试(如memtest86+),看是否能复现错误。同时,检查机箱风道,确保内存区域有持续且均匀的气流。

总结给你的排查清单:1.换CPU试试(排除IMC);2.换主板(排除布线);3.确保所有固件(BMC、BIOS)最新,因为内存训练算法会更新;4.终极手段:对疑似故障通道,在BIOS里手动放宽主要时序(如tCL、tRCD、tRP)并适当加压,如果因此稳定,就反向证明了是信号时序边缘问题。服务器追求稳定第一,性能这个牺牲是值得的。记住,内存错误是结果,我们要找的是信号链上最先变形的那个环节。

3. 网友“好奇小白兔”提问:文章最后提到了HBM和3D堆叠,感觉好厉害!那未来的DDR6,还有像MRDIMM这些新技术,对我们普通电脑用户和游戏玩家来说,最直接能感受到的提升会是什么?是帧数暴涨,还是加载速度起飞?

答: 好问题!新技术带来的提升,会是非常直观且全方位的,但它的方式可能和你想象的“单点爆破”有点不同。

对于游戏玩家,最甜点的提升将是“最低帧率”的稳固和“卡顿”的消失。 现在的游戏场景越来越复杂,数据调用是随机的。当游戏瞬间需要调用大量分散在不同地址的贴图、模型数据时,传统内存可能会因为频繁的“预充电-激活”切换而出现延迟峰值,这就是你感觉到的“瞬间卡顿”。而像MRDIMM这种技术,通过让内存模块内部多组资源并行工作,以及DDR6预计会继续提高带宽并优化并发访问能力,能极大地平滑掉这种延迟波动-2-6。结果就是,你的平均帧数可能不会从120帧飙升到200帧,但烦人的“掉帧到60帧”的情况会大大减少,整体体验更加丝滑。同时,更高的带宽也能让CPU和GPU之间的数据交换更顺畅,有助于提升复杂特效场景下的帧数。

对于所有用户,体验提升在于“无感”的流畅与“多开”的从容。 未来内存的改进,核心是同时做更多事的能力。这直接关系到你的多任务处理体验:一边玩游戏一边直播推流再加几个浏览器页面?一边运行大型编译任务一边处理4K视频?更强大的内存子系统能更好地充当这些海量数据的“中转枢纽”,减少让CPU“等待数据”的空转时间-6。你感受到的不是某一个软件快了十倍,而是同时运行一堆软件时,系统依然跟手的“跟脚感”。加载速度也会受益,特别是那些需要实时载入大量资源的开放世界游戏,更高的带宽能更快地填满显存和游戏缓存。

至于HBM,它短期内可能还是高端显卡和计算卡的“奢侈品”。它的优势是逆天的带宽和能效,但成本高、容量增长难。对普通用户来说,HBM的意义在于它推动了GPU性能的飞跃,让你能用上画面更震撼的游戏。而它的部分设计理念(如极致重视带宽和能效)会反馈到DDR和GDDR标准的发展中-9。

总而言之,未来的内存升级,不仅是“容量更大、频率更高”的数字游戏,更是 “更聪明、更协调、更抗压”的系统工程。它带来的将是数字生活整体流畅度的“水位”上升,让我们的电脑在应对日益复杂和多变的任务时,显得更加游刃有余,那种“刚刚好”的跟手体验,就是技术进化的终极目标。