实验室里的一个电容加晶体管设计,竟在半个世纪后卡住了全球AI发展的脖子,成为大国博弈的战略要塞。

1966年,IBM研究员罗伯特·丹纳德在实验室里捣鼓出一个简单想法:用一个晶体管加一个电容来存储数据-7。这个看似不起眼的发明,如今已成长为年营收近700亿美元的巨无霸市场-1。

从个人电脑到智能手机,再到如今炙手可热的AI服务器,每一台电子设备的心脏旁边,都跳动着DRAM的脉搏-1。

DRAM的诞生本身就是一场意外革命。1960年代,计算机内存还停留在磁芯存储阶段,那玩意儿又大又笨,价格贵得离谱。罗伯特·丹纳德在IBM实验室里琢磨出的那个“晶体管+电容”设计,就像一道闪电劈开了混沌-7。

不过IBM自己都没想到这玩意儿能成多大气候,反垄断调查还拖了后腿,结果让英特尔捡了个大便宜。

1970年,英特尔推出第一款商用DRAM芯片C1103,只有1Kbit容量,售价10美元-3。现在看来简直寒酸得不行,但在当时可是划时代的产品。英特尔靠这款芯片吃到了第一波红利,到1974年,它在全球DRAM市场的份额竟然达到了82.9%-3。

那会儿的竞争格局跟现在完全不一样,全球有40-50家DRAM厂商-3。可惜好景不长,德州仪器、莫斯泰克这些美国同行很快跟进,日本厂商也开始虎视眈眈。

1980年代,日本通产省搞了个大动作——VLSI计划。政府牵头,日立、NEC、富士通这些大企业联手攻关-9。这种“举国体制”的效果惊人,日本DRAM的良率比美国高出30%,价格却便宜一半-9。

这下美国厂商扛不住了,连DRAM的发明者英特尔都含泪退出市场,转去做CPU了-9。到1986年,日本拿下全球DRAM市场65%的份额,美国只剩下30%-3。

但日本人没想到,螳螂捕蝉,黄雀在后。韩国人玩得更狠——逆周期投资-9。简单说就是行业不景气时,别人都在收缩,他们反而疯狂扩建工厂。

三星半导体在1984年建厂时,每片64K DRAM生产成本1.3美元,市场价却跌到0.3美元-3。到1986年底,三星累积亏损3亿美元,差点破产。关键时刻,韩国政府出手救市,投了3.5亿美元,还帮忙拉来20亿美元投资-3。

这种“要么把对手熬死,要么自己先死”的赌徒策略,最终让韩国人笑到了最后。

DRAM发展历程中最有意思的转折,是应用场景分化导致技术路径分叉。标准DDR主打电脑和服务器;LPDDR专攻移动设备,以低功耗著称;GDDR则服务于显卡,追求极致带宽-1。

DDR这条线最稳扎稳打。从2000年第一代DDR面世,到如今主流的DDR5,数据传输速率从128Mbps飙升至6400Mbps-1。听说三星已经在捣鼓DDR6了,速度还能再翻倍-1。

GDDR的故事更带劲。这玩意儿刚出来时跟DDR区别不大,但随着游戏和AI对图形处理的需求爆炸式增长,GDDR开始放飞自我。GDDR6的带宽已经能达到768GB/s,而DDR4只有25.6GB/s,完全不是一个量级-1。

最新的GDDR7更夸张,带宽破纪录达到1.5TB/s,比GDDR6高出40%-1。不过价格也漂亮,一片顶十片普通DRAM。

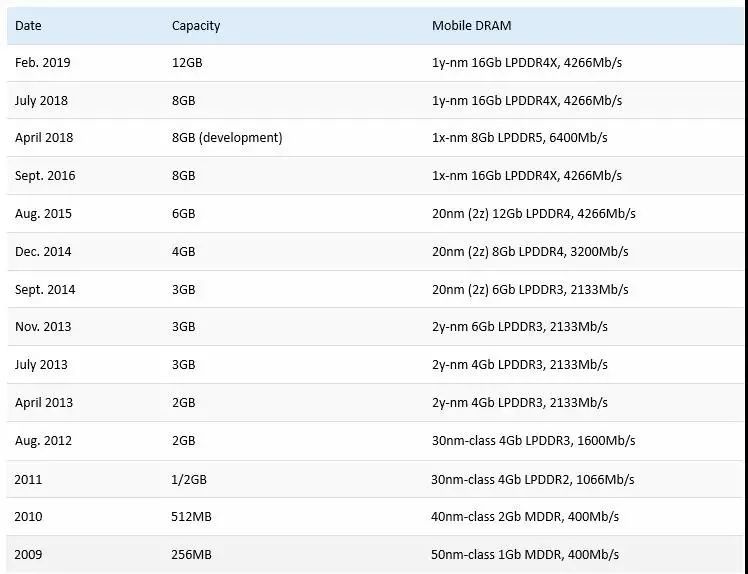

LPDDR则是另一番景象。从LPDDR4开始,它就和DDR分道扬镳,建立起自己的规范体系-1。现在的LPDDR5X功耗降低明显,短视频降30%,游戏降30%-1。手机能边玩游戏边直播,还不烫手,LPDDR功不可没。

时间跳到2025年,AI大模型火爆全球,人们突然发现:限制AI速度的不再是GPU,而是内存带宽-9。传统DRAM那点带宽,根本喂不饱饥渴的AI芯片。

HBM(高带宽内存)就这样横空出世。这东西本质上是把多个DRAM芯片像搭积木一样堆叠起来,通过硅通孔技术内部直连-9。简单粗暴,但效果惊人。

现在一颗HBM的价格是传统DRAM的几倍甚至十倍,三星和SK海力士为了争产能,投资计划都排到2027年了-9。DRAM从廉价的“工业粮食”,一夜之间变成了算力的“输油管”,卡着AI发展的脖子-9。

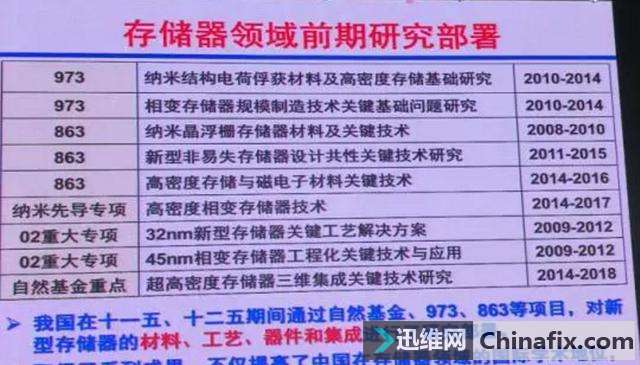

中国的DRAM产业史,曾是中国半导体的一块心病。每年进口数千亿美元的芯片,很大一部分就是DRAM-9。没有自主DRAM,中国的电子工业就像建在别人地基上的大楼。

长鑫存储的出现改变了这一局面。这家公司从零开始技术攻坚,先推出DDR4打破国产空白,再搞出DDR5和LPDDR5-9。在三星、海力士、美光三座大山的夹缝中,硬生生撕开了一道口子。

最近听说长鑫科技正在推进IPO,这不仅仅是上市融资那么简单,更像是中国DRAM产业的“弹药补充”-9。上市融来的钱,会变成研发设备、先进产线和高薪人才。

回顾这段DRAM发展历程,从日本人的“举国体制”到韩国人的“逆周期豪赌”,再到中国玩家的艰难突围,这从来不是纯粹的商业游戏-9。一枚小小的DRAM芯片背后,藏着一部大国工业的“争霸史”。

DRAM发展历程中的技术分化仍在继续,未来可能看到更多针对特定场景的定制化内存解决方案。当电路尺寸逼近物理极限,3D堆叠和新材料将成为突破方向-8。而在全球算力竞赛中,谁掌握了下一代内存技术,谁就可能握住AI时代的钥匙-9。

网友“硬件小白”提问: 经常听人说DDR4、DDR5,它们到底有什么区别?我打游戏该选哪个?

简单说,DDR5比DDR4快得多也聪明得多。DDR5的基础速度从4800MT/s起步,而DDR4通常到3200MT/s就差不多了-2。这意味着数据传输更快,游戏加载更迅速,大型场景切换更流畅。

但DDR5的真正优势在于能效和稳定性。它的工作电压更低,只有1.1V(DDR4是1.2V),意味着更省电、发热更少-6。DDR5还内置了电源管理芯片,这可是以前主板干的活-2。稳定性方面,DDR5的错误校正能力更强,系统崩溃的概率更低-2。

选哪个?如果你是新装机,预算充足,直接上DDR5。但要注意主板必须支持,目前只有较新的平台才兼容DDR5-2。如果你是老平台升级,可能只能继续用DDR4。玩游戏的话,16GB是起步,32GB会更舒适,特别是玩大型开放世界游戏。

网友“科技观察者”提问: HBM为什么这么贵?它和传统DRAM有什么本质不同?

HBM贵就贵在它的3D堆叠结构和制造工艺。传统DRAM是平铺在电路板上的,而HBM是把多个DRAM芯片像叠汉堡一样垂直堆在一起,然后用硅通孔技术从上到下打通-9。这种3D结构需要更复杂的工艺,良率也更难控制。

本质区别在于带宽和互联方式。传统DRAM通过电路板上的走线连接处理器,信号传输距离长,速度受限。HBM则是通过硅中介层与处理器紧贴在一起,互联距离极短,带宽可以达到传统DRAM的数倍甚至十倍以上-9。

这就是为什么AI芯片这么依赖HBM——大模型训练需要频繁地在处理器和内存之间搬运海量数据,传统DRAM的带宽根本不够用,会成为系统瓶颈。HBM虽然贵,但对AI应用来说是必需的“输油管”-9。随着技术成熟和产量增加,未来HBM的成本有望逐步下降。

网友“内存历史迷”提问: 从历史角度看,DRAM技术接下来会往哪个方向发展?

从DRAM发展历程看,接下来有几条清晰的技术路线。首先是继续堆叠,无论是HBM的垂直堆叠,还是3D DRAM的存储单元堆叠,都是为了在单位面积内塞进更多存储单元-8。其次是更精细的制程,虽然DRAM制程进步比CPU慢,但仍在向更小纳米数迈进,美光已经在研发1β工艺节点-1。

新材料是另一个方向,比如用铁电材料做电容,可以延长电荷保存时间,减少刷新频率,降低功耗-8。还有人在研究用氧化铟镓锌薄膜晶体管替代硅基晶体管,可以进一步缩小单元面积-8。

新型接口也值得关注,像CXL(Compute Express Link)允许CPU、GPU和内存之间更高效的连接,可能会改变传统的内存架构-2。模块形态也在创新,CAMM2可能会成为未来笔记本电脑的主要内存模块形式-2。

未来的DRAM会更加多样化和专用化,针对AI、边缘计算、自动驾驶等不同场景,会出现更多定制化的内存解决方案。