嘿,FPGA老铁们,今儿咱不聊风花雪月,就唠点实在的——你调代码的时候,有没有被数据流堵得心发慌?写端哐哐怼数据,读端慢慢悠悠,眼瞅着缓存要爆,时序要崩,那个急啊,真想给开发板两拳!别挠头了,今天咱就深扒一下救场神器:DRAM FIFO。这玩意儿用好了,你设计的“肠梗阻”瞬间变“高速路”-1。

首先得整明白,FIFO就是个“先进先出”的队列,好比是条单行隧道,车子(数据)从一头进,就得按顺序从另一头出,不能加塞-1。它在FPGA里主要就俩活儿:数据缓存和跨时钟域传输。你想啊,两个模块干活节奏(时钟)不一样,直接传数据肯定乱套,这时候就得有个FIFO在中转站帮着协调,你写你的,我读我的,完美解耦-1。

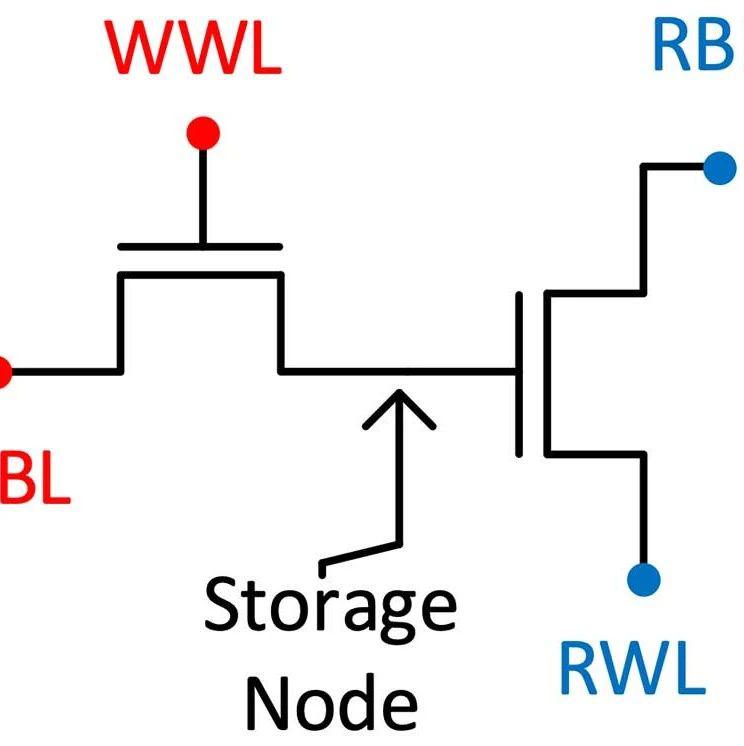

那你可能要问,FIFO不都用RAM做吗,扯什么DRAM?这里头学问就大了!在FPGA的IP工具箱里,FIFO通常分两种:一种叫分布式FIFO(Distribute FIFO),是用咱们芯片里到处都有的查找表(LUT)资源凑出来的;另一种,就是今天的主角——DRAM FIFO。听名字就知道,它是用FPGA内部专门的DRAM块(也叫Block RAM或UltraRAM,不同厂家叫法不同)硬核资源搭建的-1。这区别可大了去了!用LUT搭,好比用砖头临时垒个灶台,能做饭但容量小、火力(性能)有限;而DRAM FIFO那是专门的燃气灶,火力猛、锅(容量)还大,能炖下更多的“菜”(数据),而且支持的功能也更全乎-1。搞高速数据采集、视频流处理,数据量大得像洪水,这时候分布式FIFO可能就扛不住了,必须得上DRAM FIFO这种“重型水库”来缓存-8。

光说厉害不算数,咱得知道咋用。配置一个DRAM FIFO,核心是选对“型号”。主要就分两种:同步(SYNC)和异步(ASYNC)-1。同步的,读写用一个时钟,简单但适用场景少;异步的,读写时钟完全独立,这才是跨时钟域传输的“本尊”,用得最广-1。我有个项目,图像传感器出来的像素时钟是74.25MHz,我处理模块用的系统时钟是100MHz,就是靠一个异步的DRAM FIFO在中间稳稳当当地摆平了它俩,数据一点没丢,那感觉别提多舒坦了。

配的时候,关键得盯紧几个信号,这都是血泪教训换来的经验啊!“空”(empty)和“满”(full)信号是生命线,告诉你现在能不能读、能不能写-1。但等这俩信号动作往往就晚了,所以高手都会用“几乎满”(almost_full)和“几乎空”(almost_empty)信号来打提前量。比如你设置“几乎满”水位线为124(假设总深128),当写到124个数据时它就拉高报警,给你留出几个时钟周期的余地去关闭写操作,防止“写溢出”这种毁灭性错误-1。读端同理。这就好比水池子,不能等水漫出来了才关龙头,看到快满了就得提前关。

光说不练假把式,有论文真就把DRAM FIFO的潜力榨到了极致。为了对付雷达、高清视频这种海量数据流,有人直接用外挂的DDR2 SDRAM内存条来实现一个超大容量的异步FIFO-8。你想想,FPGA片内BRAM才几M字节,而人家这个设计,通过精妙的控制器,把DDR2 SDRAM当成FIFO的存储体,直接干到了2GB的恐怖容量,总线速率高达475MHz-8。这思路一下就打开了,片内DRAM FIFO资源不够?咱外挂个“内存海”当缓存池!虽然设计复杂点,但解决了真正的大问题。

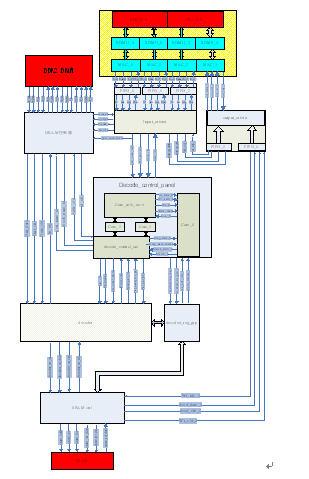

更妙的是,DRAM FIFO的玩法和价值远不止在FPGA内部。在计算机系统深处,内存控制器和DRAM颗粒之间,传统上也靠一堆FIFO来排队、同步命令和数据-2。但英特尔的一项专利揭示了新思路:当内存(比如3D堆叠DRAM)和控制器“脸贴脸”挨得极近时,延迟变得非常固定且可预测-2。这时候,就可以大胆地砍掉DRAM那边的FIFO,只留控制器这边的,用一套精巧的触发时钟方案来同步-2。这么一整,系统延迟和功耗嗖嗖地就降下来了-2。你看,同样是DRAM FIFO,在不同场景下,从“必不可少”到“可以优化掉”,这背后的设计哲学,够咱们琢磨半天。

所以啊,老铁们,DRAM FIFO绝不仅仅是个普通的缓存模块。在小处,它是你FPGA设计里稳定数据流的“定海神针”;在大处,结合特定架构(如3D堆叠、近存计算),对它进行优化或重构,能直接撬动系统级的性能提升和功耗下降-2-6。下次当你被数据流折腾得焦头烂额时,别光埋头调代码,抬起头,好好审视一下你的数据通道,或许,一个正确配置和应用的DRAM FIFO,就是你一直在找的那把钥匙。

网友问题与回复

1. 网友“时钟迷途者”提问:大佬讲得真生动!我最近在做摄像头数据接收,CMOS输出的像素时钟和我的处理时钟不同源,就是典型的跨时钟域了。您说异步DRAM FIFO是首选,那我配置的时候,深度到底设多少才保险呢?设大了浪费资源,设小了又怕丢数据,有没有个靠谱的计算方法?

答: 兄弟,你这问题问到点子上了,深度设置确实是异步FIFO设计的核心“玄学”之一。说白了,这本质上是计算“水池”在进水速度(写时钟)和出水速度(读时钟)波动下,需要多大才能不溢出。

一个最经典的简化公式是:FIFO最小深度 = (写时钟频率 × 突发写数据量) / 读时钟频率。但注意,这假设了写端在连续突发写入时,读端也在以最大能力连续读。你搞摄像头,数据往往是连续、稳定的帧数据(比如每行固定像素)。

更贴近你场景的思路是:考虑“最坏情况”。比如,你的处理模块(读端)可能会因为某些中断或耗时操作,短暂地停止读取(这是最坑的!)。此时,FIFO需要能容纳写端在这段“停滞期”内持续写入的所有数据。所以,你需要估算:读端最大可能暂停多少个写时钟周期?把这个时间乘以写时钟频率,再乘以每次写入的数据宽度(字节数),就能得到一个关键参考深度。

另外,别忘了给你计算出来的理论值加上足够的“安全余量”。因为实际系统中时钟可能有微小抖动,或者你的“几乎满”水位线需要提前动作。通常,我会在理论值上再增加10%-20%。比如你算出来需要1000个数据项的深度,那就设成1100甚至1200。在资源允许的范围内,稍微“奢侈”一点,换来的是系统的绝对稳定,这买卖划算。资源浪费一点顶多是“有点胖”,但深度不够导致数据丢失,那可是“要了命”的-1。

2. 网友“硅农萌新”提问:感谢分享!听您提到还能用外挂DDR内存做超大FIFO,感觉很酷!但这样岂不是要把DDR控制器和FIFO控制器都自己写一遍?复杂度是不是飙升?在什么情况下,才值得放弃用片内DRAM FIFO,去折腾这种外部方案呢?

答: 这位同学,你抓住了关键——工程上的权衡。没错,用DDR SDRAM实现FIFO,你需要一个成熟的DDR内存控制器(通常用IP核)和一个自己设计的、将FIFO读写逻辑映射到DDR存取上的“包装”控制器,复杂度确实比用片内IP核高一个数量级-8。

什么时候该上这种“大杀器”?主要看三个指标:容量、带宽和成本。

容量是首要驱动力:当你的数据流巨大,一片甚至多片FPGA的所有内部DRAM(Block RAM)加起来都不够你缓存一帧或一个数据包时,就必须外扩了-8。比如你要缓存一整幅4K甚至8K的原始图像,或者一段长时间的雷达回波数据,内部BRAM的MB级容量杯水车薪,而外挂DDR则是GB级别的,优势碾压。

带宽要跟得上:光容量大不够,吞吐量也得够。像DDR2/3/4,理论带宽很高,但你的控制器设计必须能有效利用,确保FIFO的读写速率满足系统要求-8。

成本与资源的权衡:如果项目对FPGA逻辑资源(LUT、FF)消耗极其敏感,用内部大深度FIFO可能占用过多BRAM,挤占其他功能。此时,虽然外挂DDR方案控制器逻辑复杂,但它解放了宝贵的片上存储资源,有时反而是更优的整体方案。

所以,这不是一个“哪个更好”的问题,而是一个“哪个更合适”的问题。常规的、数据量在几十MB以内的流处理,片内DRAM FIFO IP核干净利落。一旦触及海量数据缓存(比如视频服务器、大型科学计算中间数据暂存),外部DDR FIFO方案就显示出其不可替代的价值了-8。

3. 网友“架构师老王”提问:您最后提到在3D堆叠等近存架构中可以优化掉DRAM侧的FIFO,这个角度很有意思。这对我们未来做高性能计算芯片的存储子系统设计有什么启发?除了省掉FIFO本身,还能带来哪些连带好处?

答: 王工,您这个问题是从架构师视角出发的,非常有深度。英特尔那份专利揭示的思路,其精髓在于:当存储单元与计算单元的距离(延迟)变得极短且确定时,很多为了对抗不确定性和长延迟而设计的“冗余”中间环节,就可以被简化甚至移除-2。

这给我们的启发是革命性的:

降低核心延迟与功耗:这不仅是省了几个FIFO晶体管那么简单。省去DRAM内部的一整套时钟域同步、数据重定时电路,直接降低了内存访问最核心的读/写延迟,并且显著减少了相关电路的动态功耗-2。对于追求极致能效比(如移动设备、数据中心)的场景,这一点点提升都至关重要。

推动更极致的耦合设计:它鼓励我们将内存和计算视为一个整体系统来优化,而不是两个通过标准接口连接的独立模块。在这种“近存计算”或“存算一体”的范式下,我们可以定制更简单、高效的数据通路协议,甚至绕过传统的内存控制器架构,让计算单元更直接地“触摸”数据-2。

简化设计与验证:少了一层FIFO及其同步逻辑,就意味着更少的潜在时序问题、更简单的验证负担。这能加速芯片设计周期,提高首次流片的成功率。

所以,连带好处是系统级的:更低的整体延迟、更高的能效、以及更简洁、可定制性更强的内存-计算接口-2。随着Chiplet、3D堆叠(如SK海力士正在推进的3D DRAM技术-6)等先进封装技术的成熟,这种“靠近了,就可以更简单”的设计哲学,将成为高性能芯片架构创新的一个重要方向。您在设计下一代架构时,或许可以思考:在我们给定的封装和互连技术下,内存接口的哪些“传统”部分,其实是我们可以挑战并优化的?