老铁们,今儿咱不聊虚的,就唠点实在的。你肯定在选电脑、配固态硬盘(SSD)或者看那些硬核测评时,心里犯过嘀咕:这DRAM能写么?它到底是个啥玩意,为啥有的SSD拿它当宝,大吹特吹,有的SSD却又想方设法把它省了?今天咱就给它扒个底朝天,保证你听完,从“内存小白”秒变“半个明白人”。

先撂个最直接的答案:DRAM不仅能写,而且“写”正是它作为“内存”的天职! 你可别被它的名字“存储器”给唬住了,觉得它就是个静态仓库。实际上,它更像一个高速运转的“临时工位”,CPU要处理的数据,都得先搬到这个工位上来操作。这个搬入数据的过程,就是“写入”;而CPU从这个工位取走结果,就是“读取”-1。

那它是咋干活的呢?简单说,DRAM的每个存储单元,就像一个个超微型的“小水桶”(电容器),搭配一个“水龙头开关”(晶体管,通常是MOSFET)-1。要写入数据“1”,就给这个小水桶充上电(充满电荷);要写入数据“0”,就把它放空-10。读数据呢,就是去检查这个小水桶里有没有水(电荷)。但这里有个关键点:DRAM的读取操作有点“败家”,是 “自毁性” 的——你打开水龙头看一眼,里面的水(电荷)也就流掉一部分了-1。这导致了一个大问题:时间一长,即使没人去读,这些小水桶也会自己慢慢漏电-5。所以,为了不让数据“蒸发”掉,DRAM必须有个“后勤阿姨”定时(比如每64毫秒)给所有存着“1”的水桶重新加满水,这个过程就叫 “刷新” -1-10。你看,这就是它名字里“动态(Dynamic)”的由来——数据是动态的,不刷就没了。

说到这,你可能要拍大腿了:这么麻烦,又慢又费电,为啥还用他?兄弟,这就叫“性价比的智慧”。DRAM的结构简单到极致(1个晶体管+1个电容),所以在同样大小的芯片里,它能塞进海量的存储单元,实现超大容量,而且成本还低-1-7。相比之下,它的堂兄SRAM(静态随机存储器)速度贼快、不用刷新,但结构复杂(要用6个晶体管锁住1个数据),死贵死贵的,容量还做不大,所以只能用在CPU缓存这种“土豪专区”-1-7-9。所以,你的电脑主内存(DDR4、DDR5那些长条条)清一色是DRAM,它就是那个默默承受所有、量大管饱的“经济适用型”骨干-10。

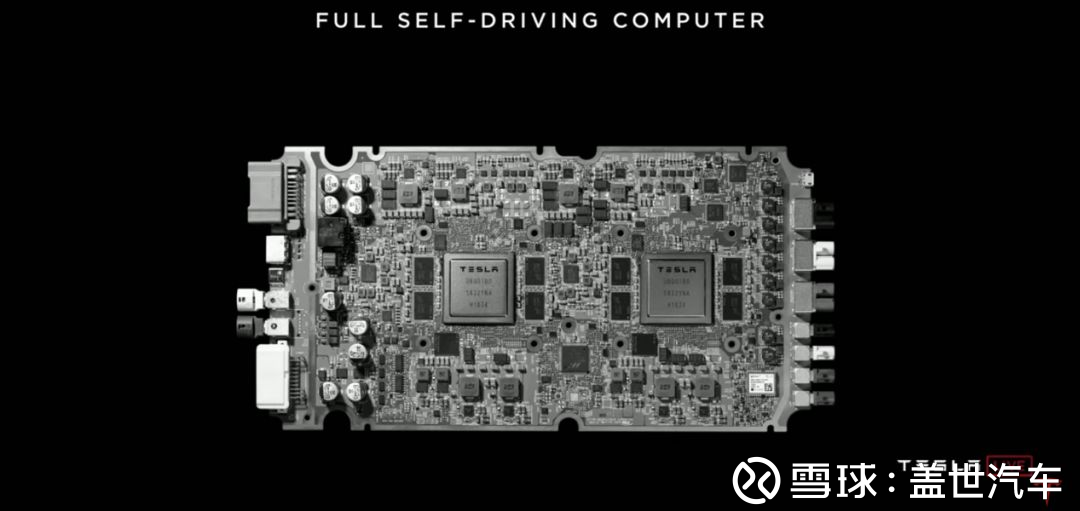

第二个“DRAM能写么”的深层拷问就来了:在固态硬盘(SSD)里,这个“写”有啥门道?这就牵扯到“有DRAM缓存”和“无DRAM缓存”SSD的世纪之争了。在SSD里,DRAM扮演一个“超高效前台”的角色。当你往SSD里存文件时,数据不是直接扔进NAND闪存(那个永久仓库)的,而是先飞速写入DRAM这个“前台缓冲区”整理好,再由主控芯片有条不紊地搬进仓库-2。更重要的是,DRAM里存着一张 “货物地图” (FTL映射表),能瞬间告诉你每个文件具体存放在NAND闪存的哪个“货架”上-2。这样一来,读写速度,尤其是随机读写速度,快得飞起。

所以,带独立DRAM缓存的SSD,就像给仓库配了个五星级前台和活地图,性能自然强悍,尤其适合干重活:比如4K视频剪辑、3D渲染、大型数据库查询,还有那些追求极致加载速度的3A游戏-2。但是,这个前台(DRAM)本身也是个“电老虎”和“成本大户”-2。于是,为了省钱省电,特别是用在轻薄本、平板等设备里,“无DRAM缓存”方案就火了。那“无DRAM能写么”?也能,但活儿干得就有点别扭了。它要么把那张宝贵的“货物地图”直接塞进本来速度就慢的NAND仓库里,找起来费劲;要么就借用电脑主机内存(HMB技术)的一小块地方来当地图-2。这就像把前台和地图都撤了,你要找东西得自己进仓库翻,或者跑到很远的地方查地图,延迟自然就上去了-2。

不过,也别把无DRAM方案一棍子打死。现在的SSD主控芯片(比如群联的E21T、E31T)越来越聪明,通过算法优化和智能预读,能在很大程度上弥补这个缺陷-2-6。对于咱们日常办公、上网、看剧,这种无DRAM缓存的SSD完全够用,性价比超高,而且更省电、发热更小-2。所以,选哪个根本不是“能不能写”的问题,而是 “你想花多少钱,买来干什么用” 的问题。

聊到未来,第三个关于“DRAM能写么”的挑战,已经上升到了AI时代的生存层面。现在训练大模型,数据量海了去了,对内存带宽和容量的需求简直是个无底洞-3。传统DRAM虽然能写,但快要写到“瓶颈”了:处理器算得飞快,但数据从DRAM里搬运出来的速度(带宽)快跟不上了,这就是所谓的 “内存墙” -3-5。更头疼的是,给DRAM“刷新”数据消耗的电量,在一些大型数据中心里,能占到整机功耗的一半-2-6!这谁受得了?

所以,整个行业都在绞尽脑汁想新招。比如,把DRAM芯片像盖楼一样堆叠起来(3D堆叠、HBM技术),用超短的垂直通道来提升带宽-3。再往远了看,科学家们在鼓捣更革命性的东西,比如“存算一体”架构,想在存储器里直接做运算,彻底省去搬来搬去的麻烦-5。所以你看,从微观的小水桶写入,到宏观的技术路线抉择,再到面对未来的物理极限,“DRAM能写么”这个问题,贯穿了过去、现在和未来,答案也在不断被刷新。

1. 网友“图吧垃圾佬”问:大神,照你这么说,SRAM又快又好,为啥不把电脑内存全换成SRAM?这样不就起飞了?

哎呦,这位兄弟,想法很美好,但钱包它不答应啊!咱们来算笔实在账。SRAM快是快,因为它用6个晶体管“手拉手”锁住一个数据,电路稳如老狗,不用刷新-1-10。但代价就是面积大、成本高。你想啊,存1比特数据,DRAM只用1个晶体管加1个小电容,结构简单,在硅片上占的地方极小-1。而SRAM的6晶体管结构,占的面积可能是DRAM单元的4-6倍甚至更多。

这意味着,同样指甲盖大小的芯片,DRAM能做出8Gb(1GB)的容量,而SRAM可能连1Gb都做不到。你要是想配个16GB的SRAM内存,那成本估计能直接买好几台整机了,而且那体积和功耗也得爆炸-7。所以,业界玩的是“分层存储”的智慧:把最快、最贵、容量最小的SRAM,放在CPU内部当一级、二级缓存(L1/L2 Cache),专门伺候CPU最急切的数据需求;而把容量大、成本低的DRAM,作为主内存(就是咱们插的内存条),负责海量数据的临时驻扎-10。这才是兼顾速度与成本的王道组合,全用SRAM?那真是“土豪都不敢这么玩”-9。

2. 网友“AI炼丹学徒”问:最近总看到新闻说内存成AI瓶颈了,具体是咋回事?对我们搞AI学习的,选设备有啥影响?

同学,你抓到了问题的关键!这个瓶颈,可以形象地理解为 “厨房太小,厨神也挠头” 。现在训练AI大模型,就像一位顶尖厨神(GPU)要处理堆积如山的食材(海量参数和数据)。厨神切菜炒菜的速度(算力)每年翻倍,但食材仓库(DRAM内存)到灶台的距离和搬运速度(内存带宽和容量),提升得却慢得多-3。

具体来说,瓶颈在两方面:一是带宽,数据从内存搬到GPU核心的速度跟不上核心计算的速度,GPU经常得“饿着肚子”等数据-3。二是容量,现在的模型动不动几百亿、上千亿参数,光把它们加载进内存就需要超大空间,更别说训练过程中产生的中间数据了-3。为了解决这个,高端AI服务器已经用上了堆叠式的HBM(高带宽内存),带宽恐怖,但价格也极其昂贵,而且产能紧张,都优先供给大厂了-3。

对咱们学习和研究来说,影响就是:配设备得更有策略。如果预算有限,重点应该放在 “保容量、看带宽” 上。优先确保你的显卡(GPU)有足够大的显存(例如12GB以上),这比盲目追求核心频率更重要,否则大一点的模型根本载不进去。对于系统内存(DRAM),容量建议32GB起步,有条件上64GB或更多。频率上,在主板和CPU支持的情况下,选择高频率的DDR5内存,对提升整体数据吞吐有积极帮助。说白了,在AI学习阶段,“喂饱”内存,比单纯追求顶级的CPU/GPU核心,有时更能提升你的实验效率和能跑的模型规模。

3. 网友“持家小能手”问:看电商页面都写“PCIe 4.0高速SSD”,不提DRAM缓存的事。我就普通家用,不打大型游戏,有必要多花钱买带DRAM缓存的吗?

这位朋友,你是懂过日子的!问到了点子上。我给你个核心建议:对于纯普通家用,无DRAM缓存的SSD,很可能是更具性价比的“甜点之选”。

理由如下:PCIe 4.0是公路的宽度(接口带宽),决定了理论上的最高运输速度。而DRAM缓存相当于高速公路上的服务区/物流中心,负责临时集散货物,对处理大量零碎小文件(4K随机读写)尤其重要-2。你提到的日常使用场景——开机、打开Office/WPS、上网、看流媒体、用微信QQ——这些操作,对硬盘的压力绝大多数是持续的大文件顺序读写(比如加载系统、加载软件)和轻度的随机读写。

现在优秀的无DRAM方案(如采用HMB主机内存缓冲技术的SSD),通过借用你电脑主内存的一小块区域来当“临时地图”,并依靠先进的主控算法优化,在应对这些日常负载时,实际体验与有缓存的盘差距微乎其微,几乎感觉不到-2-6。但是,它的价格更便宜,发热量通常更低,对笔记本的续航和散热更友好-2。

所以,结论很清晰:省下那几十到一百块的差价,把预算加到内存容量(从16G升到32G)或者CPU上,对你整体体验的提升会更明显。 除非你明确知道自己将来会频繁进行大文件剪辑、代码编译,或者就是个游戏发烧友,否则,一块口碑好的无DRAM缓存的PCIe 4.0 SSD,绝对是家用“神装”。