数据中心的轰鸣声里,海量信息奔腾不息,而一颗小小的DRAM堆栈芯片正悄然改变着计算世界的游戏规则。

深夜的超级数据中心,一排排服务器机柜泛着蓝光。工程师小张看着监控屏幕上的带宽使用率曲线,第n次叹气:“这瓶颈啥时候是个头啊!”

他的烦恼代表着一个时代困境:芯片算力每两年翻三倍,但内存带宽增长速度仅有这个数字的一半,拖慢了整个系统。

这种被称为 “内存墙”的现象已经困扰行业整整20年-3。

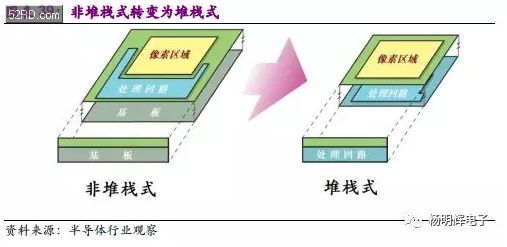

DRAM技术经历了从沟槽技术到堆叠技术的转变。那些老的沟槽技术先做电容再做晶体管,电容埋在硅片下面;而咱们今天要说的DRAM堆栈技术则倒过来,先搞定晶体管,再把电容堆叠在上面-1。

这两种技术路线代表不同时代的制造智慧,可惜德商奇梦达公司2009年破产后,沟槽技术基本退出历史舞台-1。

从那时起,DRAM堆栈技术就成了唯一的微缩制程发展方向,继续着半导体工业的摩尔定律神话。

你或许会好奇,这么小的东西里怎么能存那么多数据?其实DRAM单元的基本结构很简单:一个晶体管当开关,一个电容负责储存电荷-1。

问题就在于,随着晶体管越做越小,漏电问题越来越严重,数据保留时间缩短,需要更频繁地刷新,导致功耗居高不下-3。

AI应用的爆炸式增长让传统内存技术捉襟见肘。想象一下,从GPT-3的1750亿参数到如今万亿级参数的大模型,这对内存带宽的要求简直是几何级数增长-3。

HBM(高带宽内存) 正是这场内存革命的产物。哎呀,你看我这儿说错了,是“HBM”不是“HBM堆栈”,不过HBM本质上就是DRAM堆栈技术的集大成者-5。

它把多个DRAM芯片像搭积木一样垂直堆叠起来,形成了三层技术核心:3D堆叠架构、硅通孔(TSV)和硅中介层-5。

这种设计带来了一系列优势:超高带宽(HBM3E已达1.2TB/s)、超低功耗(比传统方案降低30-50%)、紧凑尺寸(仅需传统方案三分之一的空间)以及极低延迟-5。

HBM的发展历程可圈可点。2013年首次商业化量产,2015年AMD首次在Fiji架构GPU中使用HBM1,总带宽达到512GB/s-5。到了2025年,HBM4规范发布,带宽将跃升至2.0TB/s-5。

说到DRAM堆栈技术的应用,那可真是一场看不见硝烟的战争。目前全球存储市场主要由三星、美光、SK海力士等巨头主导,它们已经将DRAM单元微缩到15纳米以下-2。

你知道吗?制造一颗先进的DRAM芯片可不是件容易事。这玩意的制造难度,大概相当于400多层NAND闪存的堆叠技术水准-9。新建立一座先进DRAM工厂需要150亿至200亿美元的投资,建设周期长达18到24个月-9。

在AI军备竞赛中,DRAM堆栈技术更是成为了战略资源。目前全球AI芯片市场对HBM的需求呈几何级增长,预计2024-2027年复合年增长率超过50%-5。

摩根士丹利甚至称,我们正在进入一个新的 “存储超级周期” ,这波行情就是由AI算力需求驱动的-9。

任何技术都不是完美的,DRAM堆栈技术也有自己的烦恼。在DRAM使用过程中,可能会出现各种故障:固定故障、转换故障、耦合故障等等-7。

要是数据量大了,还可能出现所谓的 “相邻矢量敏化故障” ,就是一个存储单元因为邻居的活动而状态出错-7。这就像住在集体宿舍,舍友太闹腾,你也别想安宁。

实际应用中,当DIMM上的列出现大量单位元错误时,系统会报告错误,需要通过重启和内存测试来修复-4。

这些问题促使工程师们不断寻找更可靠的设计方案,比如在堆叠过程中加强结构支撑,避免因微小缺陷导致整个堆栈报废-1。

面对这些挑战,研究人员正在开发下一代DRAM堆栈技术。IMEC研究中心提出了一种2T0C设计:用两个薄膜晶体管,完全不用电容-3。

这种方法采用氧化铟镓锌作为半导体材料,关断电流极低,大大提升了数据保留时间-3。更重要的是,这些材料可以在较低温度下沉积,与后端制程兼容,为全新的DRAM架构铺平了道路-3。

另一个方向是3D DRAM。它通过垂直堆叠存储层,在不增加芯片面积的前提下提高存储容量-6。三星正在开发垂直通道晶体管DRAM,SK海力士则推进垂直栅极DRAM-6。

有意思的是,3D DRAM对光刻设备的依赖度较低,反而更需要先进的蚀刻和沉积技术-6。这一特点,恰好给中国的半导体产业提供了一些独特机会。

当被问及HBM的价格时,工程师小张会笑着说:“贵是真的贵,但没有它,你那些炫酷的AI应用连跑都跑不起来。”

看着屏幕上流畅的带宽曲线,他轻舒一口气。数据中心远方,服务器指示灯如繁星闪烁。

新一批采用HBM4标准的AI芯片已整装待发,单堆栈带宽将突破2.0TB/s-5。

未来,或许真正的突破来自那些看似疯狂的点子——无电容器设计、铁电RAM、甚至量子存储。

网友互动问答问:看了文章还是有点迷糊,能不能更简单地解释一下DRAM堆栈到底是什么?和普通内存有啥不一样?

答:兄弟,你这问题问到点子上了!咱们可以这么想:传统内存就像是平房小区,所有住户(数据)都住在地面上,要互相串门得走好远的路。而DRAM堆栈技术呢,就像是建起了摩天大楼,把住户(数据)一层层摞起来。

这样做的好处可多了:第一,节省地皮(芯片面积),同样大小的地儿能住更多人(存更多数据);第二,邻里之间串门方便多了(数据传输快),不用跑老远;第三,整栋楼统一管理更高效(能耗降低)。

具体到技术上,DRAM堆栈的核心就是“垂直堆叠”加“硅通孔”。想象一下,大楼里不是靠楼梯上下,而是每层楼板都有专门的小通道(硅通孔),楼上楼下可以直接递东西,速度自然快多了-5。

现在最先进的高带宽内存(HBM)就是DRAM堆栈的集大成者,已经能堆到12层高,数据带宽达到每秒1.2TB,是传统内存的数十倍-5。

问:文章提到中国在3D DRAM领域有机会,能具体说说吗?我们普通消费者什么时候能用上这些新技术?

答:嘿,这个问题很有前瞻性!中国的机会主要在于技术路线的差异化。目前的DRAM堆栈技术对高端光刻机依赖很大,而3D DRAM更看重蚀刻和沉积技术-6。

国内企业比如中微公司,已经开发出深宽比达到90:1的刻蚀设备,能满足3D DRAM制造的需求-6。这就像别人在比拼谁家的相机像素高,咱们另辟蹊径,专攻照片后期处理技术,也能做出好作品。

至于普通消费者什么时候能用上,得看技术发展和市场推广。预计未来两三年,三星可能会推出垂直通道晶体管DRAM产品-6。

这些新技术会先用在高端领域,比如AI服务器、数据中心,然后慢慢渗透到消费级产品。就像当年的SSD硬盘,最初贵得离谱,现在不也普及到千家万户了?

问:DRAM堆栈技术这么牛,为什么还会有“内存墙”问题?未来真的能彻底解决吗?

答:哎,这问题就像在问“汽车这么快为什么还会堵车”。DRAM堆栈技术确实大幅提升了内存带宽,但与此同时,处理器的算力增长得更快啊!

处理器算力每两年增长3倍,而内存带宽增速只有1.6倍,这个差距就是“内存墙”的根源-3。堆栈技术是在追赶,但处理器跑得更快。

未来要彻底解决这个问题,可能需要更多突破:比如把计算单元和存储单元更紧密地结合,减少数据搬运的距离;或者开发全新的存储材料和技术,像铁电RAM这样的新秀,它能同时具备DRAM的速度和闪存的非易失性-3。

还有一种思路是改变计算机体系结构,让内存和处理器不再是分开的部件。这就像把城市的单中心结构改为多中心结构,从根本上缓解交通压力。

所以啊,彻底解决“内存墙”不是单一技术能搞定的,需要材料、工艺、架构等多方面的突破。但至少,DRAM堆栈技术已经为我们打开了一扇重要的大门。