哎,你说现在这网络,动不动就卡顿、延迟,打游戏关键时刻掉链子,开视频会议卡成PPT,真是让人火大。这背后的罪魁祸首,很多时候是网络设备里处理海量数据请求时“脑子转不过来弯”。你知道吗,就像咱们城市里错综复杂的立交桥,如果没有一个反应神速的交警在枢纽处指挥,车流立马就瘫痪。而在路由器、交换机这些网络核心枢纽里,扮演这位“智能交警”角色的,就是一种叫做 TCAM(三态内容寻址存储器)的神奇芯片-1。不过,这位“交警”最近遇到了大麻烦——活儿太多,自己又太耗电、占地方,快顶不住了!幸好,工程师们想了个妙招,把它和另一位存储界的“仓储大师”DRAM(动态随机存取存储器)来了个强强联合,这下可解了燃眉之急。

TCAM到底是干啥的?咱们打个通俗的比方。普通的内存,比如你电脑里的DRAM,就像一个有固定门牌号的仓库管理员。你想找一件货(数据),必须告诉我具体的门牌号(地址),他才能去那个位置给你取出来。这个过程是“按址寻物”。

但TCAM完全不同,它是个“神探”。你直接把货的样子(关键字)拍在它面前,它能在一眨眼功夫里,把自己管理的成千上万个仓库(存储条目)全部同时扫描一遍,然后“啪”一下告诉你:“找到了,符合您描述的货物在X号仓库!”-1 这个过程是“按内容寻址”,而且是一次性、并行地比对所有内容,速度杠杠的。

更绝的是,它名字里的“三态”(Ternary)意味着它支持“0”、“1”和“无所谓”三种状态-1。这个“无所谓”状态太关键了!它就像你查快递时,只记得收件人姓“张”,不记得全名也能模糊。在网络里,这允许它进行最长前缀匹配(比如从一大堆IP地址里精确找到目标网络),正是路由器能瞬间决定数据包该往哪条路上扔的核心本事-1。

所以,从企业级交换机、核心路由器到云数据中心的防火墙,到处都有TCAM的身影。它确保你的数据包能以“闪电侠”般的速度,在迷宫般的网络里找到最优路径,不迷路、不堵车-6。

这位“闪电神探”有个致命的弱点:特能吃(功耗高)、特占地方(密度低)、还特贵-1。

为了实现那种恐怖的并行比较能力,它的电路设计非常复杂。一个TCAM存储单元需要多达16个晶体管,而存同样一个比特的数据,普通SRAM只要6个,DRAM只要1个晶体管加个电容就行-1-9。这就导致在同样一块指甲盖大小的芯片面积上,TCAM能存的信息量(存储密度)远不如DRAM和SRAM,但成本和功耗却高出几十倍-1-4。

现在网络流量爆炸式增长,路由表、访问控制列表(ACL)的规则越来越庞大复杂-6。TCAM表示:“臣妾记不住啊!”容量不够,有些规则就塞不进去,直接影响网络性能;就算勉强塞进去,那功耗和发热也让人头疼,有论文指出,传统TCAM的功耗问题严重限制了大型路由表的处理能力-3。这成了摆在所有网络设备厂商面前的一道硬坎。

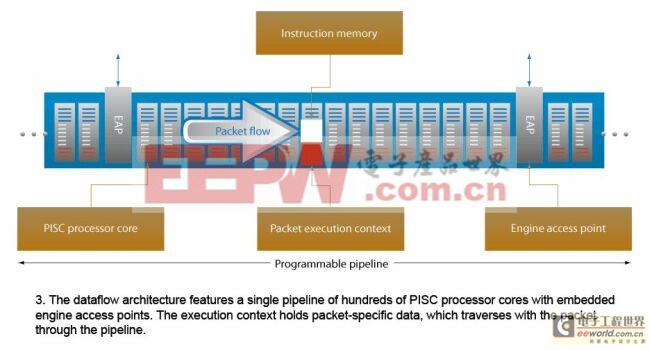

怎么办呢?硬着头皮把TCAM芯片做得更大更耗电?显然不是出路。工程师们的智慧是:分工协作,混合架构。让TCAM这位“神探”只干它最擅长、最核心的“快速甄别”工作,而把存储海量详细信息的“体力活”,交给另一位以“高密度、低成本”著称的专家——DRAM。

这个思路催生了一种创新的芯片封装结构。你可以想象成:把一小块但极其精锐的TCAM芯片,和好几层堆叠起来的、容量巨大的DRAM芯片裸片,像盖楼一样封装在同一个“房子”(封装层)里-4。它们之间通过极短的内部超高速通道(如硅通孔TSV或微凸块)连接-4。

工作流程变成了这样:

数据包来了,TCAM 凭借其并行的超能力,在一个时钟周期内就从其有限的精锐数据库里,快速匹配出关键信息的“索引地址”-1-8。

这个索引地址立刻被传递给隔壁庞大的 DRAM 仓库。

DRAM 根据这个精确的“提货单”,高效地取出完整的、详细的数据(如下一跳IP地址、安全策略动作等)-1。

这就好比神探TCAM只负责在嫌犯数据库里瞬间锁定指纹匹配的嫌疑人ID号,然后助手DRAM立刻根据这个ID号调出该嫌疑人的全部档案。如此一来,既保留了TCAM纳秒级的速度,又借助DRAM获得了海量的存储空间,同时整体成本和功耗也得到了非常好的控制-4。一些研究也表明,这种基于RAM的混合硬件架构,在保持性能的同时,能将成本和功耗大幅降低-3。

这种TCAM+DRAM的混合思路,代表了解决传统痛点的一个重要方向。同时,产业界也没闲着,正在多管齐下给这位“神探”减负增效:

工艺升级:像灿芯半导体这样的国内厂商,已经在28纳米先进工艺上推出了高性能、低功耗的TCAM IP核,通过“匹配线分段控制”等技术,能省下约30%的功耗-6。

架构创新:学术界和工业界一直在探索用更少的晶体管实现TCAM功能,比如利用新型非易失性存储器(如RRAM、FeFET)来设计单元,有望将能效和密度提升数倍-7。

智能管理:通过软件算法(如SDM交换数据库管理器)对TCAM进行分区和动态管理,把好钢用在刀刃上,优先保障最关键的业务规则-1。瑞萨电子的TCAM IP还提供了“预”和“有效位控制”功能,进一步精打细算地节省功耗-8。

所以你看,从TCAM DRAM的物理组合,到芯片工艺和设计架构的层层优化,工程师们正在为我们的网络枢纽打造一个更强大、更节能的“智能交通大脑”。下一次你的网络丝般顺滑时,背后或许就有这对“神探+仓库”组合在默默地高效工作。

1. 网友“网络小白”问:看了文章还是有点晕,TCAM这么厉害,为什么我自家几百块钱的路由器里好像没听过?它是不是只用在特别高端的设备里?

答: 这位朋友问到了点子上!确实,你家的普通消费级路由器里,基本不会用到独立的硬件TCAM芯片,因为那真的“杀鸡用牛刀”了。家用路由器的路由表很小,用软件算法或者处理器内置的一些简单加速功能就完全能应付。

硬件TCAM主要活跃在企业级、数据中心级和电信运营商级的网络设备里-6。比如:

核心路由器/交换机:要处理整个城市甚至跨省的海量网络流量,路由表极其庞大,必须靠TCAM才能实现线速转发。

高端防火墙:里面有成千上万条复杂的安全策略(ACL),每个数据包都要和这些规则快速比对,决定是放行还是拦截,离不开TCAM的快速匹配能力-1。

云数据中心:为了保障你手机APP的快速响应,内部东西向流量巨大,需要TCAM来快速进行策略执行和负载均衡-10。

简单说,TCAM是“专业运动员”,专攻高速、超大规模网络处理这个顶级赛事。随着技术普及和成本优化(比如通过TCAM IP集成到主芯片里),未来一些中高端的企业或家用设备也可能会用上它的简化或模拟版本-2-8。

2. 网友“硬件控”问:TCAM和CPU里的缓存(Cache)比,谁更快?它们原理好像都是快速查找?

答: 哈哈,这个问题非常专业!它们的目标有相似之处(求快),但设计的哲学和工作的层级完全不同,可以说是“各快其所快”。

CPU缓存(Cache):它的核心目标是降低CPU访问主内存(DRAM)的延迟。利用的是“时间局部性”和“空间局部性”原理(比如一个数据被访问后,很可能很快再被访问;访问一个地址,很可能接着访问相邻地址)。它通过硬件自动预测和管理,把最可能用到的数据放在离CPU最近、速度最快(也最贵、容量最小)的SRAM里。它的查找虽然也快,但本质还是“按地址映射”的。

TCAM:它的核心目标是基于内容本身进行确定性的、无延迟的并行匹配。它不关心数据是不是最近用过,只关心“我现在要找一个长这样的东西,你这里有没有?”。它牺牲了存储密度和能效,换来了无与伦比、且耗时固定的匹配速度。在网络世界里,一个数据包必须在几个纳秒内决定去向,这种可预测的、极致的速度比缓存那种“大概率很快”更重要。

举个不恰当的例子:CPU缓存像一个贴心的秘书,把你最近看的文件都摆在手边桌上(SRAM),你(CPU)要时他大概率能瞬间递给你。而TCAM像一个过目不忘的超级图书馆员,你描述一本书的任何特征(内容),他都能在同一时间扫过全部书架,百分百确定地告诉你在哪个位置。

3. 网友“科技观察者”问:现在AI和可编程芯片(如FPGA)这么火,它们会不会取代TCAM?

答: 这是一个非常有前瞻性的问题!答案不是简单的“取代”,而是“融合与演进”。

AI的挑战与融合:AI,特别是深度学习,在处理模式识别、异常流量检测等方面有巨大优势。但对于网络转发中最基础、最底层的“查表”动作(如IP寻址),当前的AI模型在确定性、速度和功耗上还无法与纯硬件的TCAM匹敌。不过,未来很可能出现“AI引导的TCAM”智能管理系统。例如,用AI分析网络流量模式,动态优化TCAM中规则的排列顺序、预加载热点规则,甚至压缩规则条目,让TCAM工作得更高效-3。AI和TCAM会形成互补,AI处理复杂智能决策,TCAM保障底层转发面的绝对速度。

FPGA的灵活性与竞争:FPGA确实对传统TCAM构成了直接竞争和补充。由于很多FPGA芯片内部没有专用的TCAM硬件块,工程师们就用FPGA里丰富的查找表(LUT)和触发器来“模拟”出一个TCAM功能,这被称为“软TCAM”或“仿真TCAM”-2。它的优势是极其灵活,可以随时根据协议变化重构电路,而且可以集成到更大的定制化数据通路中。缺点是纯粹用逻辑单元模拟,在速度、密度和能效上通常仍不如专用集成电路(ASIC) 中的硬化TCAM IP-9。所以,在追求极致性能和能效的固定功能设备(如核心路由器芯片)中,硬化TCAM(尤其是与DRAM混合的)仍是首选;在需要快速迭代、协议多变的实验性网络或软件定义网络(SDN)中,FPGA实现的TCAM则大放异彩-2。

总而言之,TCAM这项经典技术,正通过与DRAM等存储技术的物理集成、自身架构的革新以及与AI、可编程逻辑的协同,不断进化,继续在网络数据的洪流中扮演着不可替代的“定海神针”角色。